Стереотипы и алгоритмы поведения поисковых систем – изменяющаяся величина. Хорошая новость: именно поэтому каждый уважающий себя SEO-специалист находится в постоянном саморазвитии. Плохая новость: правила игры, которые еще вчера приносили деньги, трафик и красивые числа в метриках, сегодня вдруг перестают работать и обрушивают показатели.

Каких ошибок можно и нужно избегать?

При работе над клиентскими проектами мы регулярно сталкиваемся с уже существующими ошибками, которые могут свести к нулю все усилия по продвижению. Я решил выделить наиболее эпичные и часто встречающиеся и рассказать не только о том, как их избежать, но и как исправить ситуацию, если просчет уже допущен.

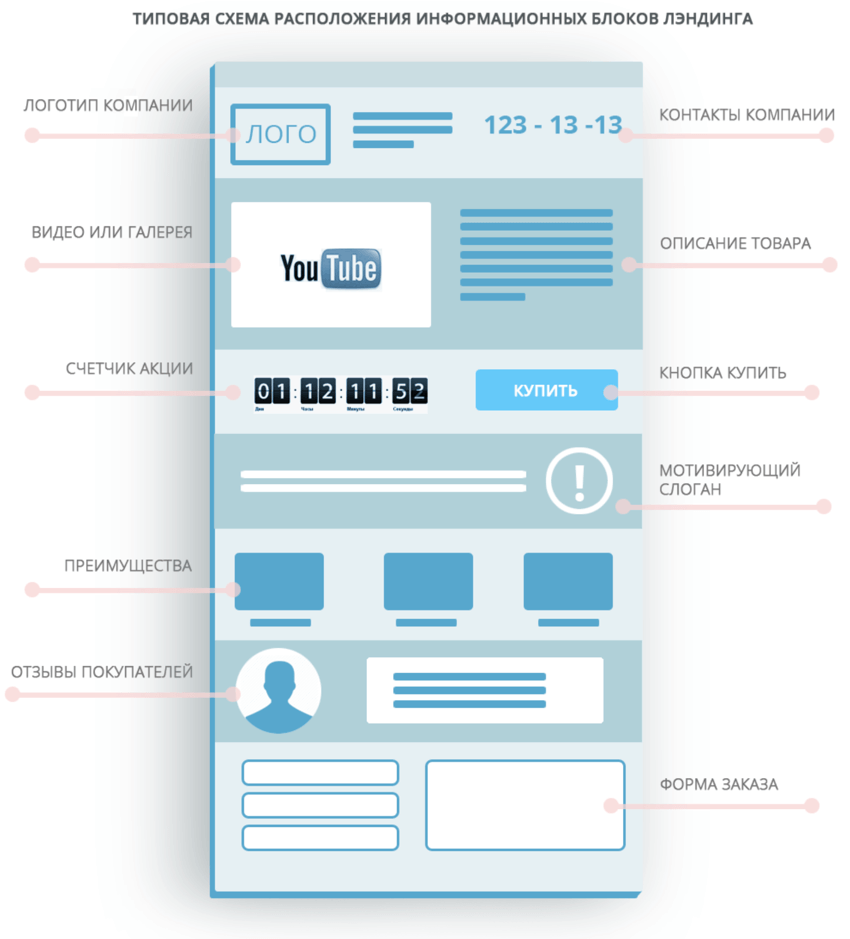

1. Продвижение лендингов (одностраничников)

Многочисленные курсы и обучающие программы в интернете пропагандируют лендинги как наиболее эффективный с точки зрения продвижения и конверсии инструмент бизнеса.

Это не так: продвигая одностраничник, вы можете работать только с сильно ограниченной группой запросов – 10–15 ключевых фраз. Все остальное, по сути, остается за бортом.

Аналогичным образом обстоит дело с удовлетворением интента – намерения, с которым пользователь осуществляет поиск в Google и Яндекс. В рамках одной страницы вы можете удовлетворить только один интент.

Для того чтобы продвигаться по более широкому семантическому ядру, нужны разные лендинги под каждую из групп ключевиков, чтобы каждая из страниц закрывала тот или иной интент.

Актуальный тренд – создание разветвленной структуры, большого количества страниц, большего числа точек входа на сайт. Все это в комплексе позволяет получать больше трафика из поисковых систем. В рамках лендинга реализовать подобное не получится.

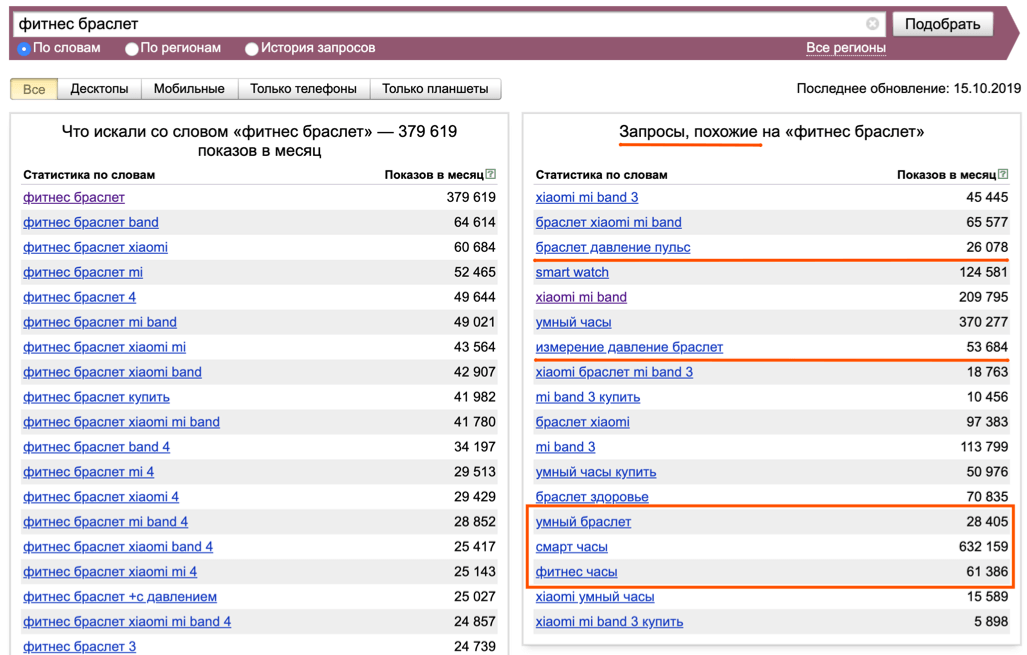

2. Узкое семантическое ядро

Эта ошибка вытекает из предыдущей. Ее допускают специалисты, которые считают, что не стоит тратить много времени на сбор максимума семантики. Они ограничиваются небольшой группой запросов и работают только с этими ключами. Сейчас тренд обратный – нужно собирать как можно больше ключевых фраз. Мы редко работаем с семантикой менее 1000 запросов. Это необходимый минимум для любого проекта.

Чем больше групп запросов, тем больше должно быть посадочных страниц и точек входа для поискового трафика. Это в несколько раз повышает шансы на привлечение целевой аудитории.

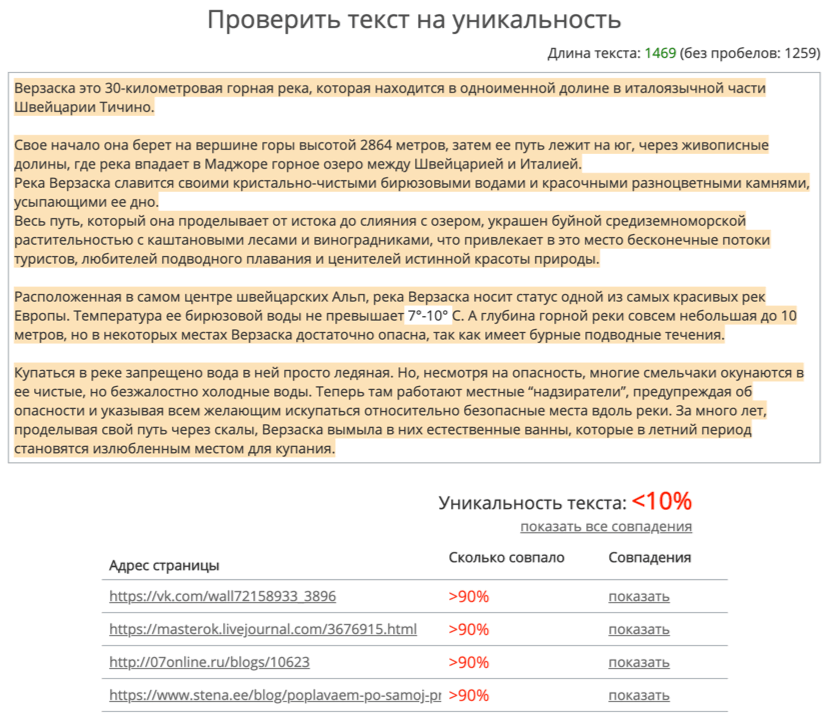

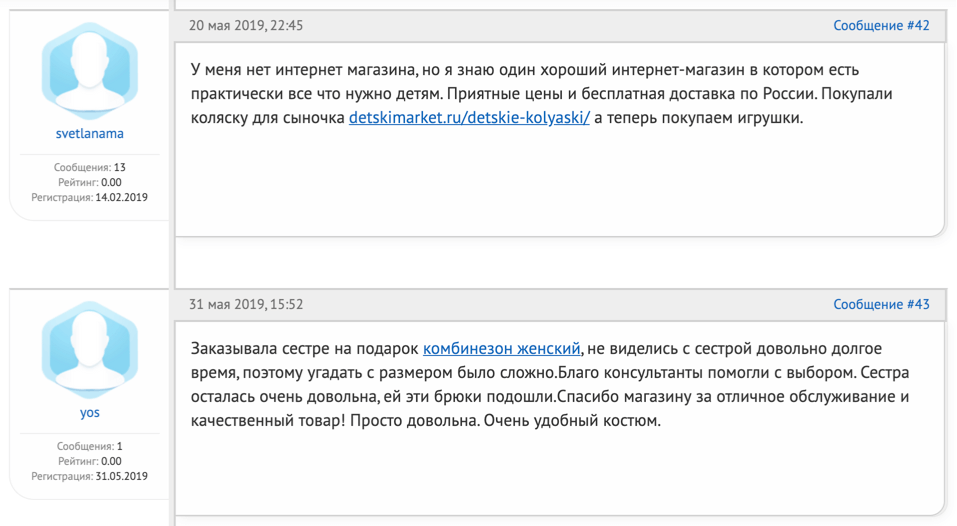

3. Плохой контент: ворованный, переспамленный, низкого качества

Частое явление: подрядчик запрашивает у заказчика контент для наполнения сайта, а представитель компании заимствует его с чужого сайта с минимальными правками. Поисковые системы такой контент не любят, о чем их представители постоянно напоминают.

Другая проблема – контент оригинальный, но крайне низкого качества. Как правило, это относится к текстам, выполненным биржевыми копирайтерами. Такие статьи – неинформативные, с большим количеством «воды», переспамом по ключевым словам. Они либо вообще не дают ответа на вопросы пользователя, либо слишком поверхностны.

Продвинуть страницы с такими текстами в ТОП не получится. Если же такого контента много, весь домен может попасть под санкции со стороны Баден-Баден, Google Panda и Google Fred.

Пишите уникальные тексты, привлекайте к их созданию авторов, которые разбираются в теме, а ключевые слова и фразы используйте в естественном виде. Достаточно и пары-тройки упоминаний на текст, чтобы поисковая система поняла, о чем он.

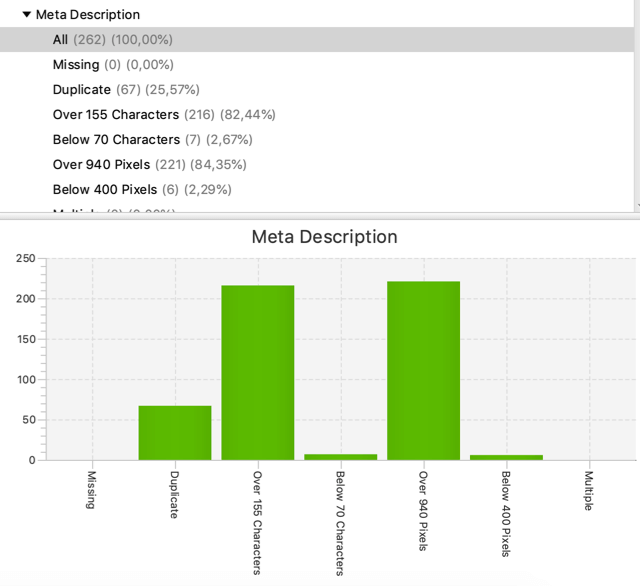

4. «Слетели» метатеги

В поисковой оптимизации важную роль играют метатеги. Одна из серьезных проблем – «обнуление» метатегов в результате работ на сайте. Причиной этого могут быть:

- технические работы;

- загрузка товаров через импорт;

- переезд на другой хостинг;

- результат некорректной работы подключаемого модуля и т. д.

Решение напрашивается само. Перед любыми более-менее серьезными техническими работами делать резервное копирование. А после их завершения – проверять ключевые параметры.

Чтобы отслеживать изменения на конкретных страницах сайта, подключите специальные сервисы и инструменты, например, модуль «Радар» в Топвизоре. Для технического аудита воспользуйтесь следующими популярными инструментами:

- Screaming Frog SEO Spider

- NetPeak Spider

- Website Auditor

Если проблема обнаружилась, ее можно оперативно исправить. Поисковые роботы не успеют отреагировать, и негативных последствий не будет.

5. Тексты для интернет-магазинов

До сих пор существует мнение, что для сайтов интернет-магазинов обязательно нужны тексты. Мол, поисковая система ранжирует только по текстам, поэтому обязательно нужно делать напичканные ключевыми словами «простыни» для категорий, а для карточек товаров создавать уникальные описания.

Поставьте себя на место пользователя и попробуйте ответить на вопрос: вы сами такие описания читаете? Это ненужная и неактуальная работа. За перебор с описанием категорий можно еще и под санкции со стороны Баден-Баден попасть.

Аналогично и с товарами. В уникальных текстах на товарных карточках нет необходимости, так как поисковые системы отлично понимают, что множество интернет-магазинов продают одни и те же товары. Их технические характеристики точно меняться не будут, поэтому стандартные описания от производителя – это нормально.

6. На сайте отсутствуют цены

Эта ошибка является одной из наиболее серьезных. Подобное чаще всего встречается на сайтах услуг, и в качестве основной причины декларируется необходимость индивидуального просчета стоимости для каждого потребителя.

Кто-то боится отпугнуть клиента высокой ценой или, наоборот, продешевить. Кому-то кажется, что цены нужно скрывать от конкурентов. Мотивы бывают разные, но в любом случае это ошибка, из-за которой сайт может ранжироваться ниже конкурентов по коммерческим запросам.

Выход найти просто. Даже если у вас есть веские причины не указывать точную цену, всегда можно указать диапазон цен, базовые расценки, общий прайс и т.д.

7. Проблемы с robots.txt

Закрыть сайт через «Disallow:/» в robots.txt – нормальная практика, если сайт на этапе разработки. Если же сделать это для уже работающего сайта, он просто постепенно вылетит из индекса.

Мы сталкивались с историями, когда штатные разработчики наших клиентов забывали открыть индексацию после завершения работ. Были случаи, когда они случайно закрывали его в процессе реализации очередной фичи или когда изменения в robots.txt были внесены каким-то новым установленным на сайте плагином/модулем.

Не забывайте время от времени просматривать состояние сайта в панелях вебмастеров. Если с robots.txt будут какие-то проблемы, вы получите автоматическое уведомление.

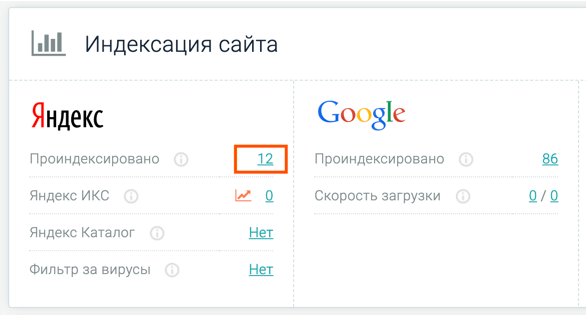

8. Плохая индексация проекта

При индексации сайтов поисковые системы используют так называемый краулинговый бюджет, который определяет, сколько именно страниц вашего сайта будет проиндексировано за визит поискового робота.

На сайте с выверенной структурой краулинговый бюджет расходуется эффективно. Но если структура сайта перегружена, он будет растрачен впустую.

То же самое происходит, если на сайте много «мусорных страниц»: дублей, технических страничек, на которые тоже тратится краулинговый бюджет. Это бьет по рейтингу сайта, дает ему более низкие позиции в выдаче, и в результате вы теряете трафик.

Чтобы избежать проблемы, надо закрывать ненужные страницы от индексации и хорошо продумывать структуру сайта.

9. Страница «404» и код сервера «200»

Иногда страница ошибки «404» может отдавать ответ сервера с кодом «200», который сигнализирует поисковому роботу, что страница доступна для индексации. А должно быть наоборот.

Часто это связано с настройками движка или неправильной настройкой сервера. И основная проблема в том, что таких страниц может быть огромное количество. Даже если изначально у вас на сайте реальных посадочных несколько десятков.

Поэтому, чтобы избежать попадания подобного мусора в индекс и негативного влияния этого на рейтинг сайта в целом, обязательно время от времени проверяйте код ответа сервера по страницам «404».

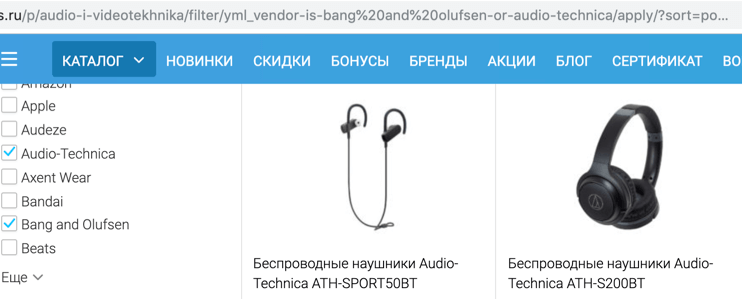

10. Поиск, фильтры и динамические страницы

Частично этот пункт пересекается с предыдущими, так как перечисленные типы страниц не должны попасть под индексацию поисковыми системами. На сайте для пользователя они полезны, но в индексе фактически являются «мусором». Причем комбинаций тех же фильтров могут быть тысячи.

Поэтому обязательно нужно закрывать такие типы страниц от индексации через robots.txt. Генерируются они обычно по похожему шаблону в URL, и на основе этой информации можно прописать соответствующие директивы в данном файле.

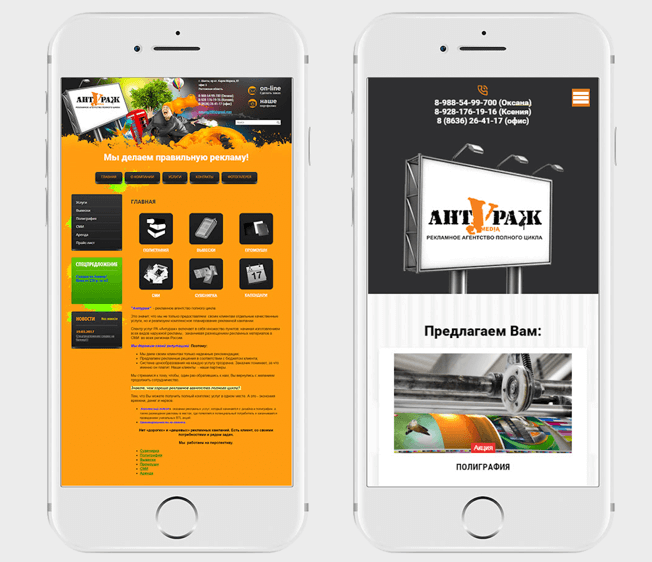

11. Сайт не адаптирован под мобильные

По данным Google, более 50% всего интернет-трафика приходится на пользователей мобильных устройств. А в некоторых нишах этот показатель в Рунете составляет 70% и выше.

Мобильная и десктопная поисковые выдачи отличаются. Именно для мобильной выдачи адаптивный дизайн является важным фактором, который влияет на положение сайта в поиске. Это отражается и на поведении пользователей – если работать с сайтом на смартфоне неудобно, то показатель отказов будет очень высоким, а конверсия минимальной.

Накануне 2020 года сайт не адаптирован под мобильные – это странно. Но все же, подобные проекты приходят к нам на аудит и продвижение с завидной регулярностью.

12. Контент мобильной и PC-версии сайта отличается

Есть несколько способов адаптации сайта под мобильные устройства:

- Адаптивный дизайн. Верстка шаблона сайта реализована таким образом, что позволяет ему адаптироваться под размер экрана устройства, с которого осуществляется просмотр.

- Динамическая мобильная версия. При запросе пользователя к сайту определяется, что он использует мобильное устройство, и в ответ сервер отдает специальную мобильную версию скриптов.

- Мобильная версия на поддомене. С основной PC-версии для мобильных пользователей осуществляется редирект на мобильную, которая вынесена на отдельный поддомен.

Бывает так, что для мобильных убираются определенные блоки, чтобы облегчить дизайн и улучшить восприятие контента. Из-за этого контент по сравнению с десктопной версией может отличаться.

Сейчас выдача Google формируется по принципу mobile first indexing. То есть сначала поиск индексирует именно мобильную версию и на основе ее анализа ранжирует сайт и на десктопах. Соответственно, если часть контента отсутствует, поисковая система просто не будет учитывать его при ранжировании.

Решение: оптимальным выбором для адаптации сайта под мобильные является именно использование варианта с адаптивным дизайном. Это практически исключает ситуацию, когда контент на разных устройствах отличается.

13. Автоматизированная покупка ссылок

Для меня факт закупки ссылок стал своего рода открытием. Оказывается, в 2019 году некоторые проекты все еще используют автоматические и полуавтоматические методы получения ссылок. Например, прогон по сотням полумертвых каталогов, базе форумов и прочим подобным источникам.

Сегодня в этом нет никакого смысла, и никакой пользы такие ссылки не приносят. Более того, когда масса таких бэклинков станет критической, есть высокая вероятность попасть под фильтр Минусинск от Яндекса. Тем более что часто используются еще и прямые коммерческие анкоры, которые алгоритмы поиска определяют как неестественные.

14. Накрутка поведенческих факторов

Хотя влияние поведенческих факторов ощутимо в любой нише, нужно помнить: чем ближе к ТОПу, тем они важнее. Заниматься их накруткой точно не стоит. Однако существуют специализированные биржи и сервисы, которые предлагают подобную услугу. И все еще встречаются владельцы сайтов, желающие проверить свою удачу в погоне за быстрым результатом.

Да, на короткое время вы вполне можете улучшить позиции сайта. Но потом попадете под фильтры и останетесь вообще без трафика на полгода. Поисковые системы слишком хорошо научились определять поведенческие накрутки.

Нет смысла рисковать, если можно поработать над сайтом и улучшить эти показатели естественным путем. Проведите аудит и исправьте технические ошибки, работайте над повышением загрузки, улучшайте юзабилити и качество посадочных страниц, повышайте кликабельность сниппетов.

Все перечисленные вещи положительно влияют на поведение посетителей, причем абсолютно органически.

15. Слишком хорошие поведенческие факторы

Считается, что чем больше времени проводят пользователи на сайте, чем больше страниц они просматривают, тем лучше. При этом не учитывается фактор тематики. Есть ниши, где пользователь должен получить ответ максимально быстро. Пример такой ниши – эвакуаторы. Люди заходят на сайт и покидают его буквально за несколько секунд, как только находят номер телефона.

И наоборот, если посетители проводят на сайте долгое время, просматривают множество страниц и другим подобным образом взаимодействуют с ним, то Яндекс может сделать выводы, что сайт не удовлетворяет потребности аудитории.

Так что при работе над поведенческими факторами, необходимо учитывать особенности тематики, ведь поисковые системы учитывают интент, и у них есть срезы по каждой из ниш.

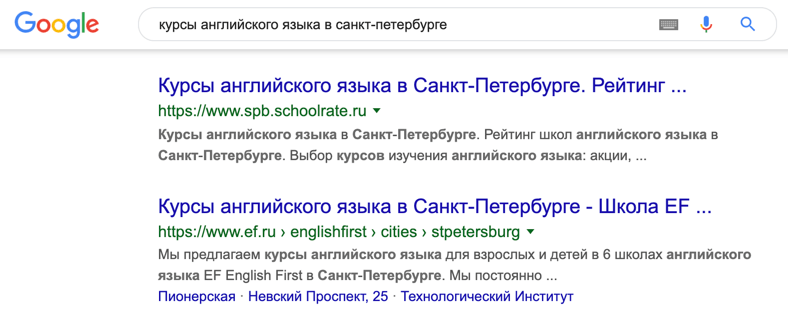

16. Продвижение по агрегаторным запросам

В рамках семантического ядра, по которому продвигается сайт, могут присутствовать запросы, места по которым в поисковой выдаче заняты агрегаторами, каталогами и сервисами самих поисковых систем. Таких запросов может быть немало. Пытаясь продвигать по ним свой сайт, вы просто зря потратите время и бюджет.

Но даже в таких условиях можно получать трафик, если немного поменять стратегию. Более правильный подход – использовать такие ресурсы как своего рода прокладки. То есть создавать страницу-карточку под свой бизнес на них, пытаться выйти в ТОП нужной категории (можно и платно) и оптимизировать страницу своей компании, чтобы занять позиции по нужным запросам в выдаче.

В таком случае путь пользователя будет выглядеть так:

- Пользователь вводит запрос.

- Переходит на категорию или страницу вашей компании в агрегаторе.

- Далее уже или звонит вам, или кликает на адрес сайта в карточке компании.

Проанализируйте свои шансы, есть ли смысл бороться за место в выдаче с Avito, «Из Рук в Руки» и другими гигантами? Или можно получать нужные вам переходы обходными путями?

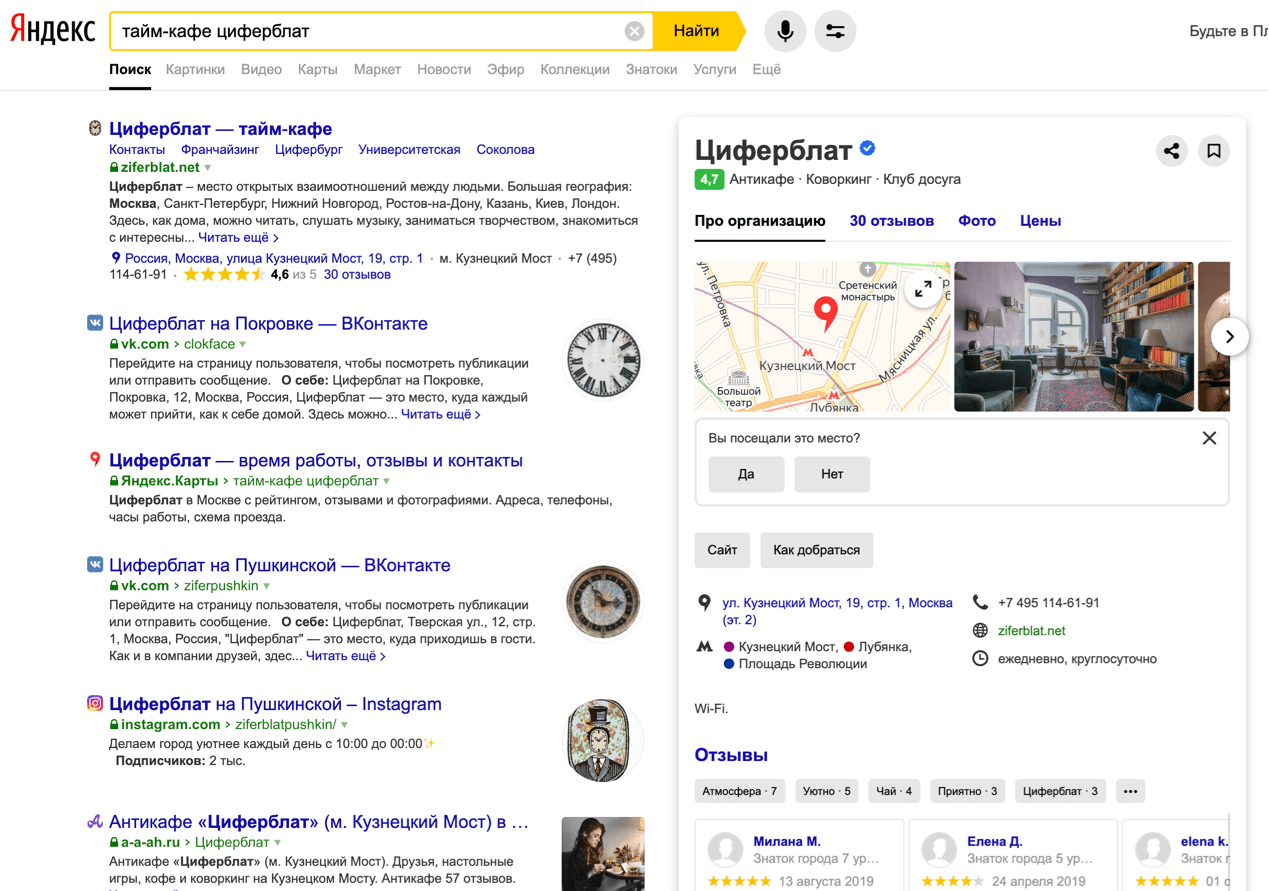

17. Выдача по брендовым запросам

Последние исследования продемонстрировали, что 88% пользователей перед тем, как заказать товар или услугу, читают отзывы либо о товаре, либо о компании, которая предоставляет услугу. Мало кто готов сходу сделать заказ, обычно пользователь хочет ознакомиться с опытом других людей.

Вариантов запросов вида «бренд + отзывы» может быть много. Люди ищут отзывы о товаре или услуге, информацию о компании как работодателе и т. п. В любом случае выдачу по таким ключам нужно изучать, так как здесь обычно совершенно отсутствует конкуренция, а значит, результатами можно легко управлять.

Вот краткий чек-лист по SERM (управление репутацией в поиске), который вы можете взять на вооружение:

- формируем список брендовых запросов;

- проверяем и изучаем поисковую выдачу;

- создаем контент и инфоповоды;

- доводим нужные страницы до ТОП 10.

Вы можете сконструировать желаемые результаты поисковой выдачи по бренду своей компании, заполнив ТОП 10 своими ресурсами.

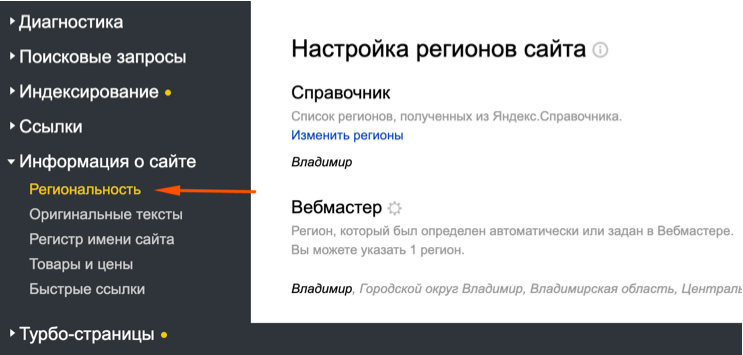

18. Не указан регион продвижения

Отсутствие региона продвижения – ошибка, которая часто встречается в проектах наших клиентов. Что происходит? Поисковая система неправильно определяет региональную принадлежность сайта, а тот, в свою очередь, имеет низкие позиции по геозависимым запросам.

Регион указывается в настройках Яндекс Вебмастер, а также подтягивается поисковиком из данных в Яндекс Справочнике. Это обязательно нужно сделать еще в начале продвижения.

Если регион не будет указан, то продвигаться по коммерческим геозависимым запросам будет крайне сложно.

19. Продвижение PDF вместо страниц сайта

Был такой тренд, когда в выдаче поисковых систем активно продвигали PDF-страницы. Это дополнительная точка для входящего трафика, но по факту такие усилия бесполезны по целому ряду причин.

При работе с такими страницами вы не можете их настраивать (по сути это просто документ), нельзя интегрировать CTA, нельзя управлять многими техническими вещами. Конверсия с такой входящей всегда будет минимальной.

Если подходить к этому вопросу объективно, то от PDF нужно отказаться в пользу классических HTML-страниц, и вопрос такого выбора не должен стоять в принципе.

20. Неправильно настроены цели на формы

Проблемы с настройками целей приводят к тому, что вы просто не видите и не понимаете происходящие на сайте процессы. Трафик идет сам по себе, а вы как владелец сайта не можете мониторить эффективность продвижения и конверсию.

Причин этого может быть несколько:

- цели не были настроены вообще;

- цели были настроены, но перед запуском сайта код не был проверен, и настройки работают криво;

- цели настроены, но не на то, что нужно.

На последней ситуации остановимся подробнее. Типичный пример: цель настроена не на отправку формы, а просто на клик по кнопке. А нажатие кнопки далеко не всегда равно отправке. На практике пользователь может неправильно заполнить поле, и после нажатия кнопки, получит сообщение об ошибке. А из-за неверных настроек системы аналитики в этот момент зафиксируют успешную конверсию, что довольно ощутимо может портить статистику.

Поэтому конверсией должна считаться именно отправка формы и передача данных, а не просто клик по кнопке.

Бонусный пункт – пост-аналитика

Я бы даже назвал его «капитанским», если бы эта ошибка не встречалась так часто. Нужно не только выполнять задачи, направленные на увеличение видимости и трафика, но и регулярно анализировать результаты этих действий:

- результаты внедрения правок, которые проводились по проекту;

- поведение пользователей на сайте;

- динамику и сезонные изменения;

- качество трафика и т. д.

Всем этим тоже можно управлять. Поэтому позиция «я SEO-специалист и отвечаю только за трафик из поиска, ситуация на сайте меня не волнует» – неправильная. Работа над конверсией в рамках сайта тоже должна лежать в зоне ответственности специалиста по поисковому маркетингу.

Изучение особенностей целевой аудитории, понимание ее поведения, анализ качества трафика – все это является необходимостью для создания действительно качественной посадочной страницы. А хорошо проработанные посадочные продвигать в ТОП гораздо проще. Надеюсь, наш опыт поможет вам избежать ошибок и повысить отдачу от продвижения сайта.

Теги:

Теги: