Когда семантическое ядро разрастается до сотен тысяч запросов, наращивать темп вручную становится дорого и сложно. Логичное решение – не нанимать десяток дополнительных специалистов, а автоматизировать процессы.

Мы приложили это к SEO – так появился пайплайн автоматизации с LLM. Результат – экономия в 3–6 раз и ускорение в 10–15. Разбираем технические подробности и делимся впечатлениями.

Почему вообще решили автоматизировать

Мы выполняли задачу для клиента: за полгода собрать семантику для 500 000 кластеров. Требовалось выстроить структуру, прописать H1 и анкоры, типизировать страницы.

Команда из шести человек за три месяца обработала только 10% запланированного объема. Рентабельность проекта упала до минус 60%, все перерабатывали, качество страдало. Масштабирование классическим способом означало бы найм еще 12–15 человек – с теми же проблемами координации и контроля качества.

Классический SEO-процесс для крупного проекта включает семь этапов:

-

Выгрузка семантики из сервисов в Excel.

-

Ручная чистка от мусора.

-

Кластеризация.

-

Построение структуры.

-

Типизация страниц.

-

Написание метатегов.

-

Формирование анкоров для перелинковки.

Каждый этап упирается в технические или человеческие ограничения.

Keys.so по умолчанию не отдает всю семантику сразу по крупным проектам – приходится выгружать частями. Excel останавливается на миллионе строк, а буксовать начинает уже на 300–500 тысячах. Чистка семантического ядра съедает до 40% времени команды. Построение структуры требует опыта и внимания – делегировать джунам не получится. Типизация страниц, теги и анкоры – рутина, но объемная.

Что сделали: трехуровневая архитектура

Выстроили систему, где база данных хранит миллионы запросов, Python-парсер управляет процессом, а LLM обрабатывает данные. Рассказываем подробнее.

Уровень 1: SQL БД – хранилище и источник данных

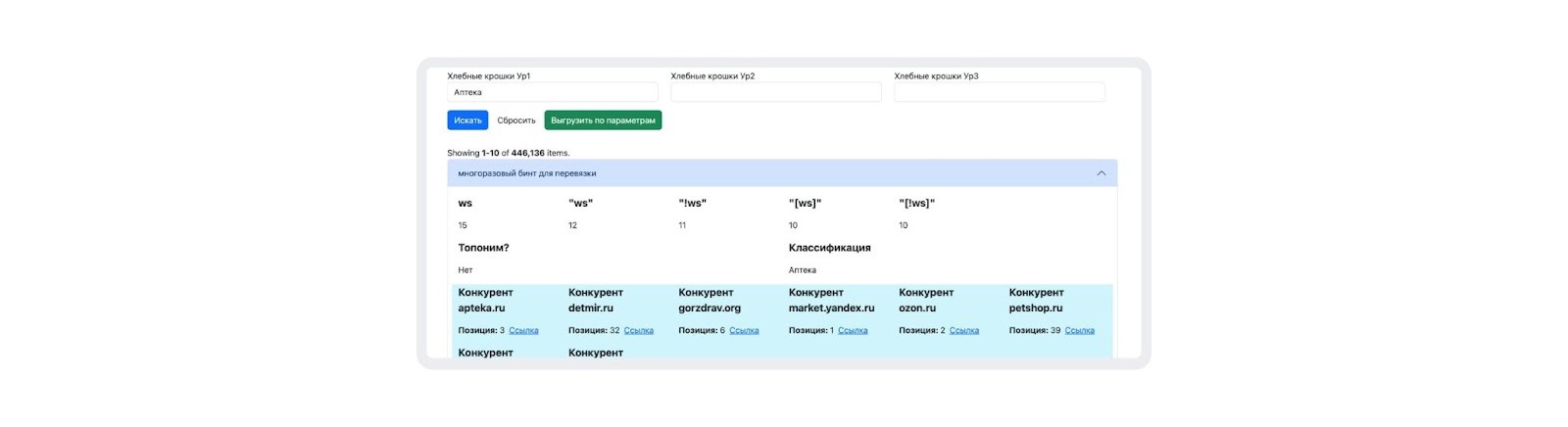

База данных заменяет Excel. Она обеспечивает работу с миллионами строк без пробуксовок, принимает данные по API из Keys.so и JustMagic, сама мэтчит ключи (быстрее и надежнее) и отдает данные порциями для обработки.

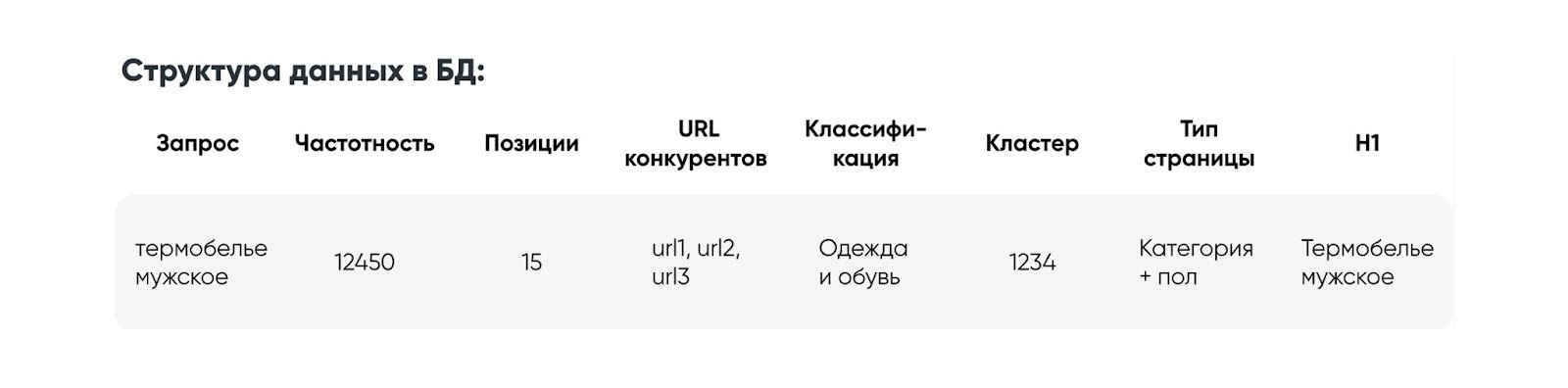

В базе лежит все: сам запрос, частотность, позиции и URL конкурентов из выдачи, категории, номера кластеров, типы страниц, заголовки.

Уровень 2: Python Parser – оркестратор процесса

Парсер берет данные из базы, разбивает на фрагменты по 200–300 строк (это лимит LLM), отправляет по API к нейросети, объединяет результаты в общий список.

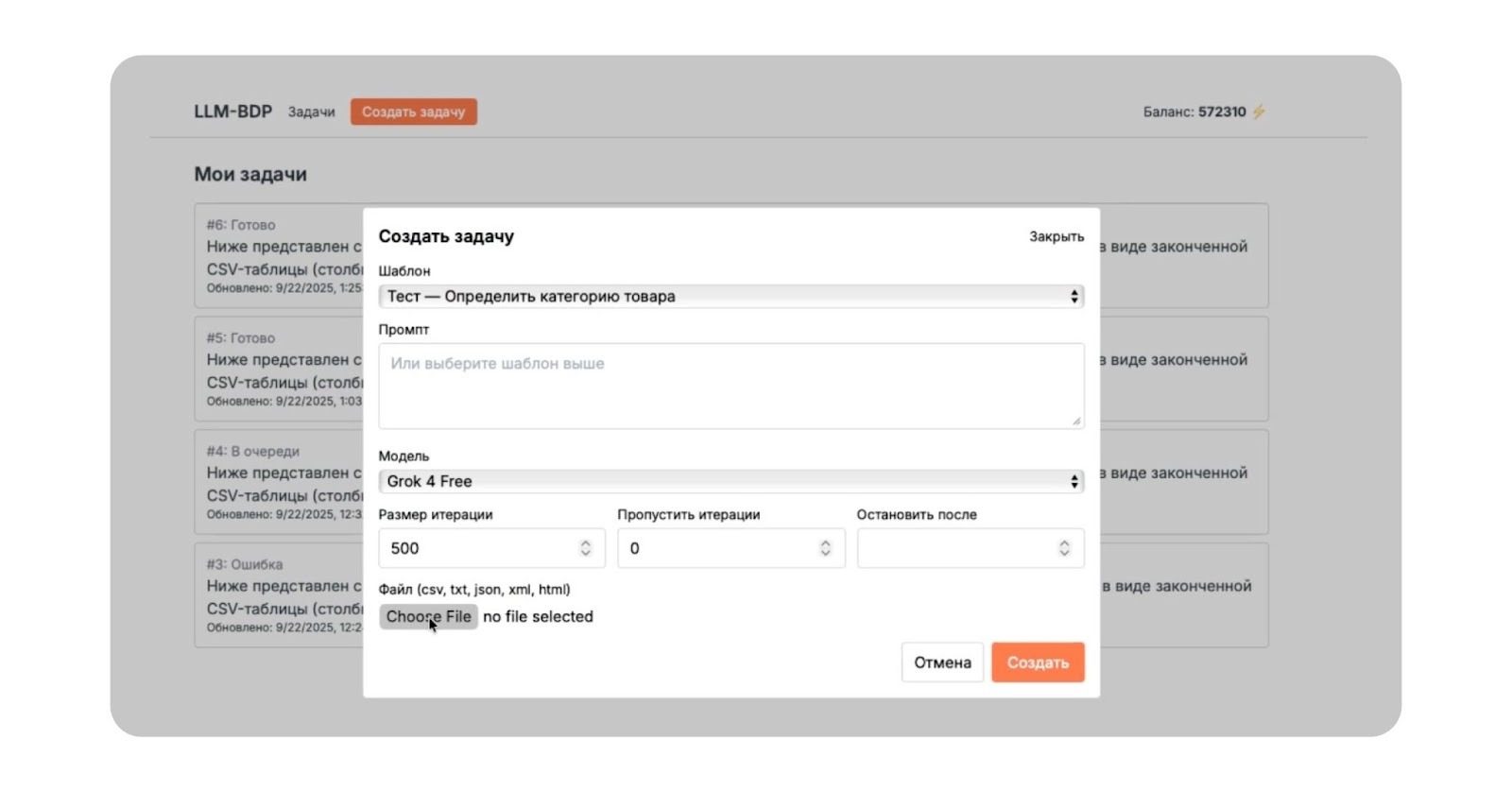

Интерфейс парсера позволяет выбрать шаблон задачи (чистка семантики, генерация H1, построение структуры, формирование анкоров), отредактировать промпт, выбирать из сотен доступных моделей, задать размер итерации и количество параллельных запусков.

Уровень 3: LLM через OpenRouter – обработчик данных

В OpenRouter можно переключаться между 300+ моделями, мониторить популярность и тренды, работать с единой биллинговой системой.

По данным платформы, для SEO и маркетинга чаще используют Claude 3.7 Sonnet, GPT-4o-mini, Gemini 2.0 Flash и Gemini 2.0 Flash Lite. Но мы убедились: модели показывают разную точность на конкретных этапах.

По нашему опыту, для чистки семантики оптимальна Gemini Flash 2, для построения структуры – DeepSeek V3.1, для генерации заголовков – Gemini 2.5 Flash.

Пайплайн: три блока обработки

1. Подготовка данных

Сбор и загрузка

Запускаем API-парсинг по фрагментам – результаты сразу объединяются в SQL-базе.

Классификация

Здесь определяем категорию каждого запроса. Например, «брюки мужские» относятся к одежде и обуви, «палатка 4 местная» – к спорту и отдыху, «кольцо с сапфиром» – к ювелирным украшениям. Это позволяет на старте отсечь нерелевантные категории и сосредоточиться на приоритетных или сезонных.

Подойдет модель Gemini Flash 2.

|

Пример промпта «Определи категорию из списка доступных, верни только название без пояснений». |

Чистка семантики

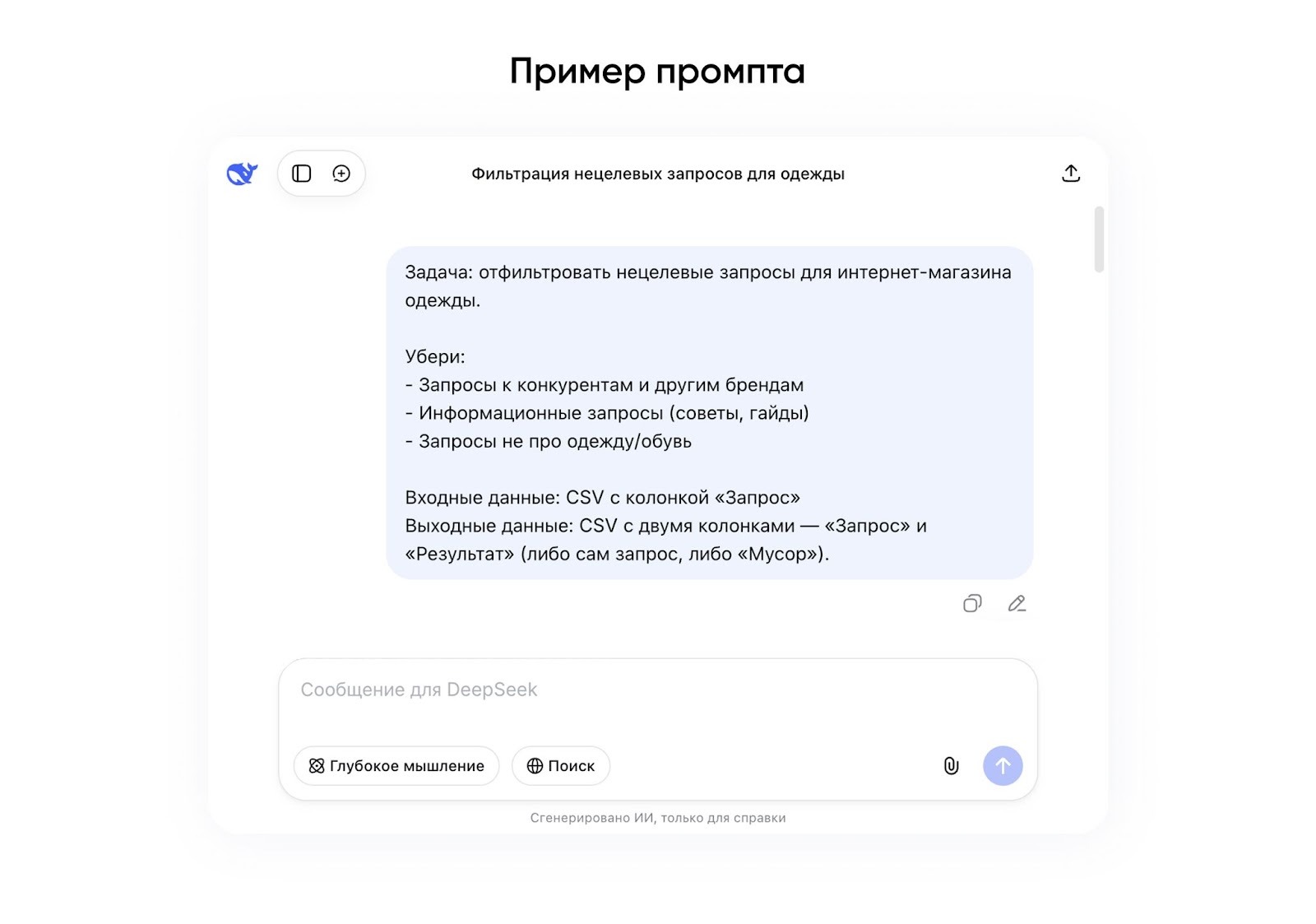

Задача – отделить коммерческие запросы от мусора. К нему относятся навигационные, информационные и нерелевантные запросы.

Для максимального качества (но со сниженной скоростью) подойдет DeepSeek V3. Для баланса «быстро/качественно» – Gemini Flash 2.

Важно: на этом этапе делаем «сверку с реальностью»: контролируем, что LLM не потеряла важное. Это не полностью ручная работа, а выборочный контроль 5–10% результата. Его стоит поручить миддлу или сеньору.

2. Структурирование запросов

Кластеризация

Сгруппировать запросы по интенту – задача, которая пока не под силу LLM. Поэтому берем проверенные инструменты: Key Collector, Rush Analytics, Топвизор, собственные алгоритмы.

Сцепка дублей

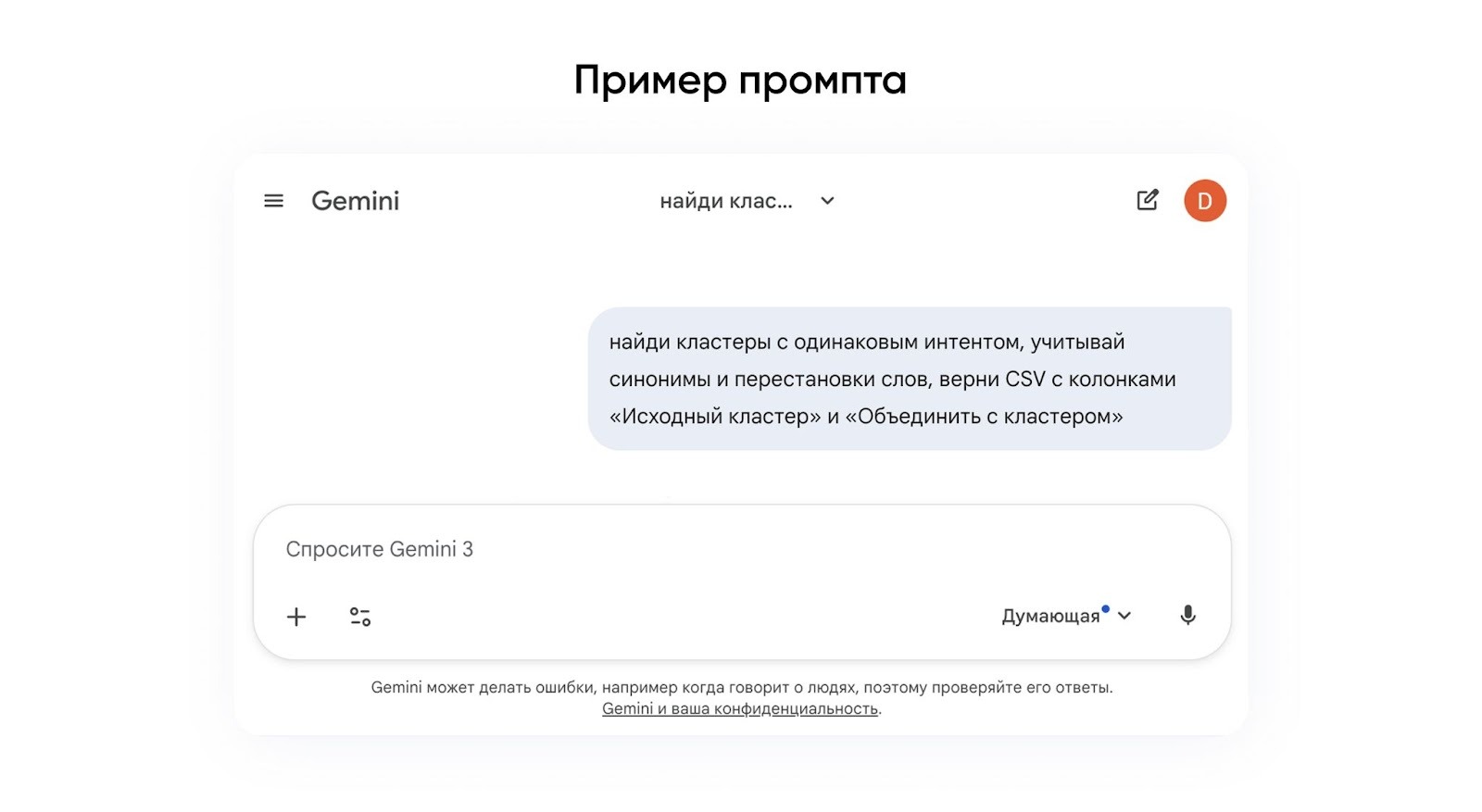

LLM находит и объединяет кластеры, которые идентичны по смыслу. С разным порядком слов как в «брюки мужские» и «мужские брюки», «куртка зимняя женская» и «зимняя женская куртка», или с однокоренными, как в «кольцо с сапфиром» и «сапфировое кольцо».

Здесь хороша модель Gemini 2.5 Flash – она быстрая, дает минимум потерь.

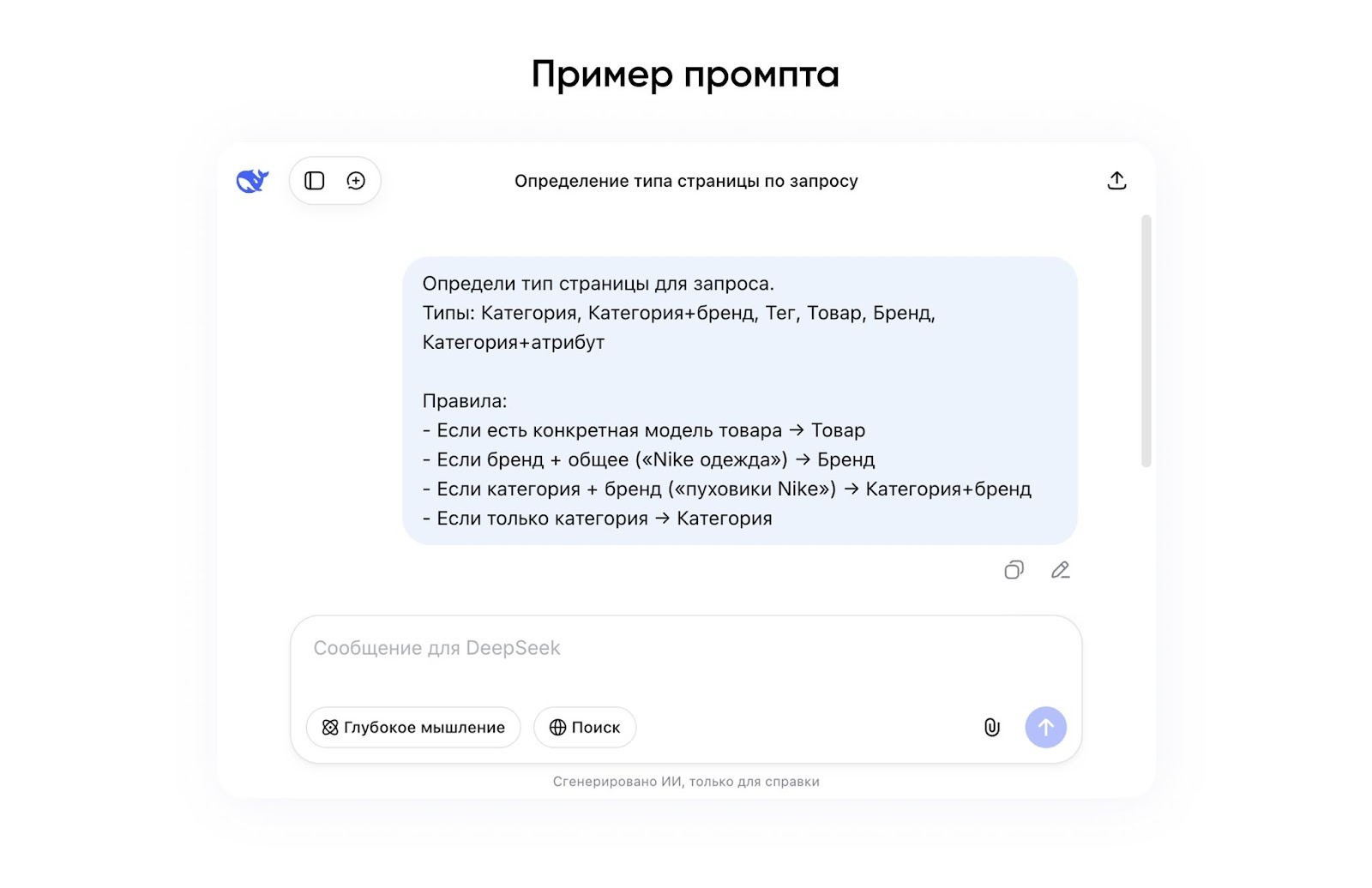

Типизация страниц

Теперь нужно определить тип страницы для каждого кластера – от этого зависят шаблон, структура URL и стратегия продвижения.

Используем DeepSeek V3.1, ведь тут важна точность.

3. Логика страниц

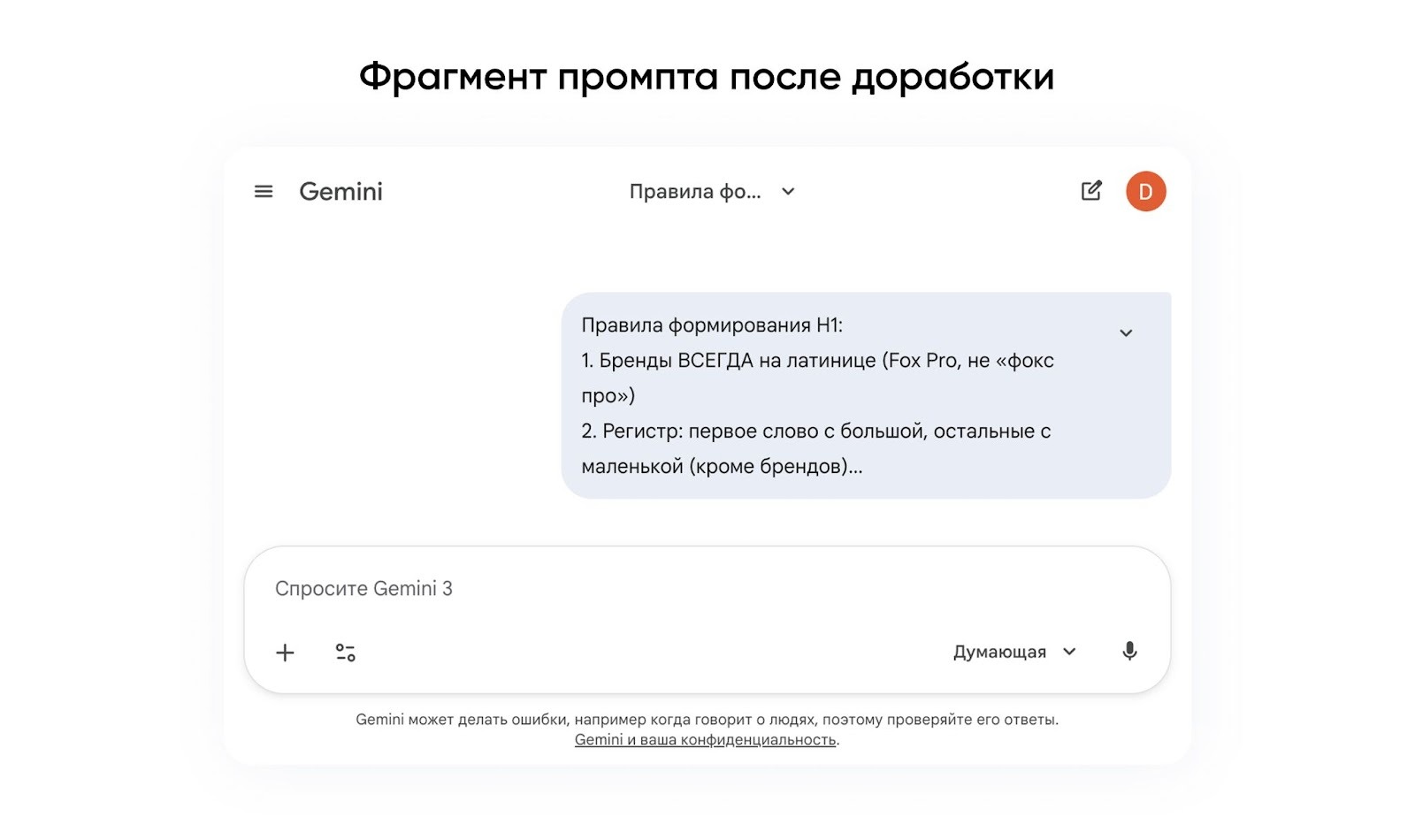

Формирование H1

Написать заголовок для каждой страницы – задача, где нужна естественность. Для этого важно учитывать ряд нюансов: язык написания бренда, регистр и порядок слов, число (единственное или множественное) как в запросе.

Модель Gemini 2.5 Flash на этом этапе быстро выдает приемлемое качество. Но может потребоваться итеративная доработка:

прогнали модель → сравнили результат с ручным эталоном → зафиксировали типовые ошибки → уточнили правила в промпте.

Повторяем, пока не останемся довольны уровнем.

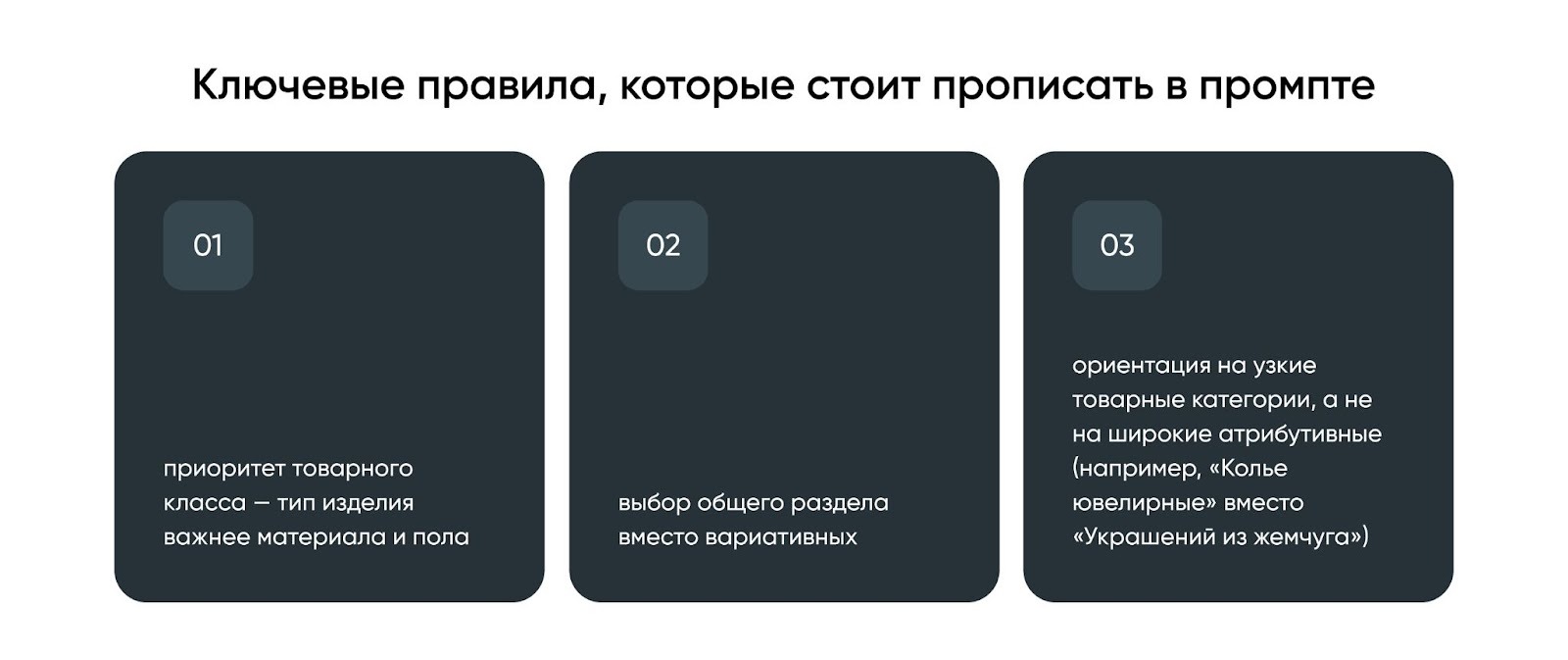

Построение структуры

Теговые страницы нужно привязать к категориям и построить иерархию – тут логика важнее скорости.

Пример: тег «Колье из жемчуга» можно отправить к «украшениям из жемчуга» или к «ювелирным колье». Нам нужна вторая категория: товарный класс важнее материала.

DeepSeek V3.1 – самая точная модель для проработки структуры.

Что получили: цифры и сравнение

Проект, с которым мы работали – топ-10 e-commerce в России. Брали категорию «одежда и обувь». За три месяца с автоматизацией обработали 450 000 кластеров (без ИИ было бы 50 000). Создали 690 000 новых страниц, проработали 19 000 категорий. Общий объем семантики – 6 млн запросов.

Важно: автоматизация выгодна не всегда.

Настройка пайплайна съест около 100 ч и 200 000 ₽. Вложения начинают окупаться от 1000, а кратная экономия получается только от 10 000 кластеров. На масштабах 100 000+ вручную вообще нереально уложиться в разумный срок – здесь однозначно нужно автоматизировать.

Ограничения автоматизации

Использование LLM в SEO не отменяет работу специалистов. Их задача – управлять автоматизацией и включаться на этапах, где без ручного контроля и корректировок масштабирование не имеет смысла.

Вот почему без работы руками не обойтись.

LLM по умолчанию не погружены в бизнес

Они не учитывают колебания спроса, фактический ассортимент и ограничения брендов. Модели могут сгенерировать структуру под отсутствующие товары или «мимо сезона». Поэтому обязательно – проверка 5–10% результата и корректировка промптов под нишу.

API могут падать

В тестах GPT-4o показывал до 32% сбоев API, Qwen3 – порядка 20% потерь данных. Поэтому важно использовать устойчивые модели (Gemini, Claude, DeepSeek), иметь под рукой резервные варианты и логировать все запросы.

Кластеризация – слабое место LLM

Искусственный интеллект пока нестабильно справляется с кластеризацией запросов по интенту. Поэтому нужны проверенные сервисы (Topvisor, Rush Analytics, Key Collector) и грамотные специалисты, которые смогут с ними работать.

Модели не универсальны

Ошибка – использовать одну LLM для всего. Этапы требуют разных приоритетов: для чистки семантики это скорость и цена, для структуры и типизации – максимальная точность, для H1 – баланс качества и времени. Задача специалиста – подобрать модель под задачу.

Промпты тоже не универсальны

Логика группировки зависит от ниши. Для ювелирных сайтов «кольцо с сапфиром» – это категория «Кольца». В одежде цветовые признаки работают как теги. Решает поэтапное тестирование и доработка промптов.

|

Главный принцип автоматизации: не заменять людей, а дать им инструменты для работы с нечеловеческими объемами. |

Теги:

Теги: