SEOnews запускает новый проект для специалистов и клиентов «Энциклопедия интернет-маркетинга». Каждую неделю редакция будет публиковать обучающие материалы, авторами которых станут специалисты ведущих агентств на рынке. В итоге мы планируем выпустить полное, практически полезное и актуальное электронное руководство.

***

Аудит сайта. Оценка внутренних факторов сайта

Комплексный SEO-аудит – это всестороннее исследование сайта и анализ различных факторов, с ним связанных, позволяющее определить текущее состояние веб-ресурса, а также его слабые и сильные стороны. В него входит ряд проверок, которые можно разделить на:

1. Анализ внутренних факторов.

2. Анализ внешних факторов.

3. Анализ поведенческих факторов.

Внутренний анализ сайта (анализ внутренних факторов) – первое, что необходимо сделать, начиная работы по поисковому продвижению. Оптимальным является устранение проблем до индексации сайта поисковыми системами, а также до начала работы с внешними факторами. Правильно исходить из того, что в индекс отдается сайт, близкий к идеальному.

Под анализом внешних факторов подразумевается исследование среды, окружающей сайт (источники ссылок, конкуренты, социальные сигналы и т.д.). Большая часть таких проверок проводится периодически.

Анализ поведенческих факторов – проверка того, как сайт решает задачи пользователей. Выполняется на сайте, который имеет достаточный для статистического анализа объём аудитории. Зачастую это динамические проверки, которые должны проводиться регулярно.

В рамках данного материала рассмотрим оценку внутренних факторов сайта.

Проверка состояния файла Robots.txt

Robots.txt — текстовый файл, расположенный на сайте, предназначенный для роботов поисковых систем, должен быть доступен по адресу site.ru/robots.txt. В этом файле веб-мастер может указать параметры индексирования своего сайта как для всех роботов сразу, так и для каждой поисковой системы по отдельности.

Благодаря настройкам в robots.txt можно исключить индексацию страниц, препятствующих корректному представлению сайта в результатах поиска.

Чаще всего исключаются технические страницы, различные сортировки, версии для печати и т.д.

Проверка robots.txt включает в себя: проверку наличия файла на сайте, поиск возможных ошибок, а также определение полноты директив, запрещающих индексацию документов, не предназначенных для роботов поисковых систем.

Проверка файла Sitemap.xml

Файл Sitemap — это файл, расположенный на сайте и содержащий дополнительную информацию о документах, подлежащих индексированию. С помощью файла Sitemap можно сообщить роботу поисковой системы, какие страницы нужно индексировать, как часто обновляется информация, а также индексирование каких адресов наиболее важно.

Наличие такого файла позволяет в более короткие строки проводить индексацию новых документов на сайте.

Необходимо проверить наличие самого файла (чаще всего он располагается по адресу ***.ru/sitemap.xml), указание ссылки на sitemap.xml в файле robots.txt, полноту покрытия сайта и проверить сам файл в валидаторе: https://webmaster.yandex.ru/sitemaptest.xml

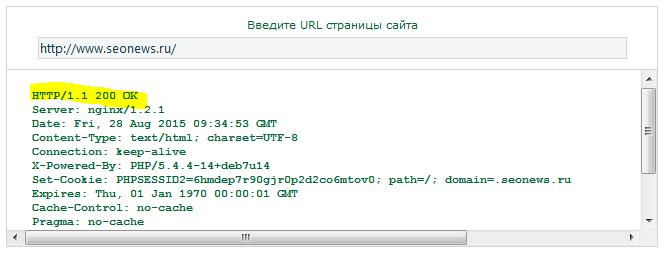

Проверка кодов ответа сервера

Код состояния HTTP (код ответа сервера) — часть первой строки ответа сервера при запросах по протоколу HTTP. Он представляет собой целое число из трех арабских цифр. Первая цифра указывает на класс состояния. За кодом ответа обычно следует отделённая пробелом поясняющая фраза на английском языке, которая разъясняет человеку причину именно такого ответа.

- Для доступных страниц обязателен код ответа 200.

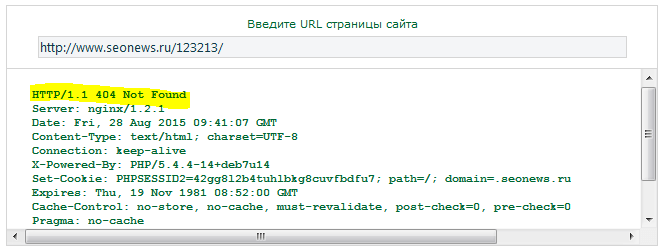

- Для несуществующих страниц верный код ответа – 404.

Получить код ответа можно, например, тут: http://mainspy.ru/otvet_servera. Проверяется главная и несколько внутренних страниц. Все они должны возвращать код ответа 200 OK:

Проверяются несколько вариантов страниц с заведомо неверными адресами. При обращении к таким должен возвращаться код ответа 404:

Нередко встречаются CMS, где страница «Документ не найден» не отдаёт 404 код ответа сервера. Необходимо провести соответствующую доработку CMS.

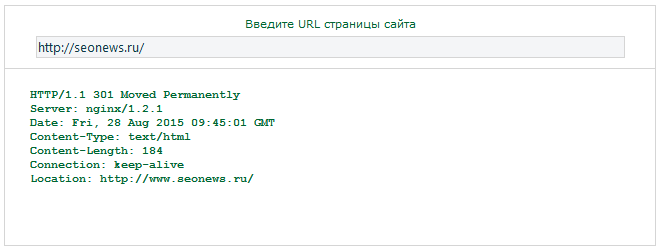

Проверка определения главного зеркала сайта

Зеркалами считаются сайты, являющиеся полными или частичными копиями. Копии определяются по совпадению контента на страницах с одинаковыми адресами (site1.com/page.html и site2.com/page.html). Например, в большинстве случаев хосты site.com и www.site.com являются зеркалами, так как контент страниц, доступных по одинаковым адресам, не отличается.

Сайт должен быть доступен только по одному из вариантов обращения: либо с указанием папки www, либо без этой папки (m.seonews.ru или seonews.ru). Второстепенное зеркало должно отдавать 301 код ответа сервера с перенаправлением на главное зеркало. Если сайт проиндексирован, то рекомендуется оставить ту версию, которую избрал робот поисковой системы.

На данном этапе проверяются коды ответа зеркал сайта (с www, без www, с https, без https). Код ответа 200 должен быть только у одного варианта, все другие должны отдавать 301 код ответа с перенаправлением на главное зеркало:

Анализ способов формирования URL страниц

URL-адреса множества динамических сайтов состоят из доменного имени и перечисления параметров, отвечающих за формирование содержимого страницы (site.ru/catalogue.php?http_id_part=174&http_id_prod=623), часто встречаются псевдостатичные адреса, где параметры заменяются на человекочитаемые фрагменты (site.ru/catalog/9-dzhinsy-briuki).

Некоторые параметры в URL-адресе являются незначимыми, т.е. с ними или без них страница содержит одну и ту же информацию. Это приводит к тому, что информация на сайте начинает дублироваться. Поисковые системы негативно относятся к этой ситуации, так как дублирование контента приводит к росту индексной базы, при этом объём полезной информации остаётся прежним.

Если на сайте есть посещаемость, список всех параметров можно получить в соответствующем разделе Яндекс.Метрики.

Вот так выглядит список параметров среднестатистического сайта на Bitrix.

На картинке выше приведён список из 38 параметров, которые встречаются в адресах страниц сайта. Большинство параметров являются техническими (например, sphrase_id – подсветка слов в результатах поиска, back_url_admin – адрес предыдущей страницы при неверной авторизации) и не предполагается индексация страниц их содержащих.

Если сайт не имеет посещаемости, рекомендуем выгрузить его одной из программ: Xenu, Screaming Frog SEO Spider или NetPeak Spider (далее программы сканирования сайта) и обработать полученный список адресов, выявив все допустимые параметры.

На данном этапе необходимо проанализировать, какой вклад вносит каждый параметр в формирование содержимого страницы. Если добавление параметра не приводит к появлению дополнительного контента, он добавляется в robots.txt для исключения индексации таких адресов.

Поиск малоинформативных страниц

Малоинформативные страницы содержат недостаточное количество информации для того, чтобы быть проиндексированными поисковыми системами или высоко ранжироваться по соответствующим поисковым запросам. Необходимо либо запретить индексацию таких страниц, либо дополнить страницы текстовым контентом.

Производится поиск страниц, которые не содержат никакой полезной информации, кроме, например, меню сайта. Найти страницы можно, воспользовавшись программой сканирования, отсортировав документы по размеру.

Поиск дублирования главной страницы

Часто встречается ситуация, когда главная страница сайта дублируется по внутренним адресам. Например, в CMS Bitrix главная страница дублируется при добавлении к доменному имени index.php. Например: https://m.seonews.ru/index.php - эта страница не закрыта в robots.txt и может быть проиндексирована поисковыми системами:

На данном этапе необходимо найти возможные способы дублирования главной страницы и исключить их индексацию.

Поиск дублирования внутренних страниц по разным адресам

Аналогично главной странице часто встречаются дубликаты внутренних страниц сайта. Приведём несколько возможных примеров.

- Одинаковые по содержанию страницы, которые отличаются только символом “/” в конце URL-адреса.

- Страницы, доступные как по ЧПУ-адресам, так и по адресам с параметрами. Когда равнозначны site.com/company/overview и site.ru/?cat=2.

- Появление одинаковых страниц при удалении части адреса: site.com/company/overview или site.com/overview.

- Дублирование страниц при добавлении имени файла (в частности актуально для Bitrix). Когда равнозначны site.ru/calendar/ и site.ru/calendar/index.php.

- Дублирование за счёт незначимых параметров в URL (описано выше).

Необходимо изучить сайт, с целью установить принципы формирования адресов страниц. Это позволит выявить потенциальные места возникновения дублирования одинаковых страниц по разным адресам.

Программой сканирования сайта можно воспользоваться как из одним из способов поиска дублей контента. В полученной структуре можно найти страницы одинакового размера.

Поиск ошибки характерной для мультиязычных сайтов

Если на сайте есть разные языковые версии, для каждой из них должен быть написан собственный уникальный контент. Необходимо определить, используется ли на сайте мультиязычность, и проверить, какие тексты расположены на других языковых версиях. Если содержимое дублируется, необходимо эти дубли удалить и наполнить разделы соответствующими текстами.

Анализ страницы результатов поиска

Встречается ошибка, когда результаты поиска по сайту открыты для индексации роботами поисковых систем. Страницы не закрыты в robots.txt и отдают код ответа сервера 200. При этом для каждого поискового запроса формируется уникальный url. Таким образом поисковый робот индексирует контент, который прямо запрещён в лицензии поисковых систем.

Необходимо определить, как формируется страница с результатами поиска. Если поисковый запрос содержится в url, такие страницы должны быть закрыты в robots.txt.

Поиск одинаковой (отсутствующей) метаинформации

Тег title (метаинформация) – основной из факторов ранжирования страниц в поисковых системах. Содержимое этого тега выводится в заголовке страницы.

Каждая страница должна иметь уникальный заголовок, релевантный её содержимому. В этом случае сайт потенциально способен привлекать большее количество пользователей за счёт повышения видимости в поисковых системах.

Необходимо выявить принципы формирования метаинформации на сайте. Если существуют правила, из-за которых выводится одинаковая или отсутствующая метаинформация, необходимо внести соответствующие изменения в CMS.

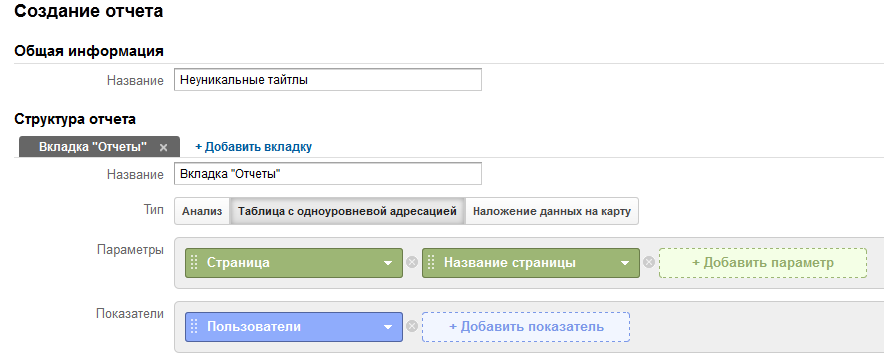

Помимо малоэффективного ручного поиска таких страниц можно воспользоваться программой для сканирования сайта, отсортировав результат по полученным title. Вторым способом является построение пользовательского отчёта в Google Analytics (если на сайте есть посещаемость и открыт доступ к статистике):

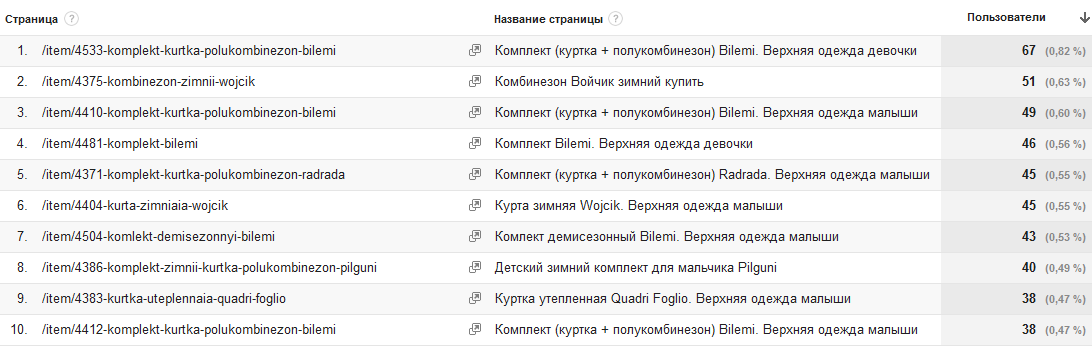

В результате получаем следующую таблицу, где приведена сводка тайтлов всех страниц сайта.

Анализ количества внешних ссылок

Количество внешних ссылок – важный показатель качества сайта. Если сайт ссылается на множество других ресурсов, не соответствующих его тематике, это может послужить причиной для санкции со стороны поисковых систем.

Необходимо определить количество внешних ссылок, внимательно проверить ресурсы-получатели. Рекомендуется по возможности максимально сократить количество прямых исходящих ссылок, которые бы не являлись рекомендацией для пользователя сайта. Внешние ссылки допустимы, но должны дополнять и расширять контент.

Анализ текстового наполнения сайта

При поисковом продвижении принципиально, чтобы на сайте были размещены уникальные тексты, имеющие ценность для целевой аудитории сайта.

Необходимо проверить максимальное количество текстов на сайте на уникальность. Не стоит начинать поисковое продвижение, если на сайте нет оригинального контента, который не продублирован в открытой части Интернета. Существует множество сервисов, которые позволяют проверить как отдельные страницы, так и сайт в целом.

Анализ качества точек входа

Под качеством точек входа понимаются численные характеристики, описывающие первое взаимодействие пользователя с сайтом. Чаще всего это показатель отказов – сколько пользователей посмотрели только одну страницу – и время просмотра страницы.

Необходимо проверить поведенческие характеристики точек входа на сайт. Чрезмерное количество отказов или значения, сильно отличающиеся от средних по сайту, должны насторожить. Необходимо выявить причину такого поведения пользователей и при необходимости внести коррективы.

Поиск разметки микроформатами

Микроформаты – это форматы семантической разметки (X)HTML-страниц, позволяющие сделать контент доступным для обработки роботами. Микроформаты дают возможность явно указать смысловое значение отдельных блоков текста, дополнив существующую HTML-разметку специальными блоками.

Необходимо проверить разметку соответствующими микроформатами контента на сайте (адреса, изображения, видео и т.д.). Внедрение микроформатов позволит улучшить видимость сайта в вертикальных поисках.

Приведённый выше базовый перечень проверок позволит выявить большую часть проблем веб-ресурса, а также позволит корректно проиндексировать сайт в поисковых системах.

Теги:

Теги: