22 августа Яндекс презентовал новый алгоритм ранжирования «Королев». По сути, этот алгоритм продолжит дело, начатое «Палехом». Его работа также основана на нейронных сетях. Но в отличие от предшественника «Королев» научился оценивать страницы исходя из содержания не только заголовка, а всего текста.

Конечно, пока рано делать какие-то выводы. Но мы не удержались и решили узнать у представителей агентств и сервисов, как изменится жизнь SEO-специалистов с запуском нового алгоритма. Плюс – попросили поделиться наблюдениями касательно изменений, произошедших в выдаче накануне запуска алгоритма.

Фактически, с внедрением ряда новых факторов, которые учитывают:

- смысловое соответствия пары запрос-документ (по всему тексту документа, а не только по Title, как ранее в алгоритме «Палех»),

- качество ответа документа на схожие по смыслу поисковые запросы, –

не будет глобальных изменений для SEO-индустрии. Наиболее значимые изменения коснутся «длинного хвоста» запросов, под которые целенаправленно SEO-специалисты мало работают. Их много, они редкие и часто обеспечивают единичные заходы на сайт.

Может быть увеличена значимость ряда факторов, которые и так прорабатываются специалистами, с того момента как LSI стал «модной темой».

Фактически, как ни парадоксально, самые значимые изменения в ТОП-100 были задолго до последнего анонса — 8 августа 2017.

В «Пиксель Тулс» даже подумали, не сломался ли апометр? Нет.

Сегодня с утра — очень тихо. Вчера же был достаточно сильный апдейт, сила изменений по которому по НЧ- и мНЧ-фразам выше, чем по ВЧ.

Вероятно, алгоритм «Королев» был запущен несколько раньше официального анонса. Следим за дальнейшими изменениями по апометру.

Яндекс сообщил о новой технологии поиска «Королев». По заявлению Яндекса, эта технология направлена на то, чтобы поиск осуществлялся по смыслу, а не по словам. Это стало возможным благодаря использованию нейронных сетей. Такой подход позволяет писать информативные и понятные тексты, в которых не обязательно должны присутствовать точные вхождения запроса. Но на самом деле Яндекс делает это уже достаточно давно, просто сейчас поменялся алгоритм. Поэтому эти изменения не должны затронуть современных SEO-специалистов, которые отказались от переспамленных текстов в пользу полезных текстов для людей.

Также для внедрения этой технологии потребовались изменения архитектуры индекса. Поиск по запросу состоит из нескольких этапов. Первый этап являлся фильтрующим, т.е. удаляются из обработки страницы, в которых нет слов из запроса. Но даже после этого остается огромное количество страниц, особенно для запросов с очень частотными словами. При старой архитектуре все найденные страницы невозможно было обработать для ранжирования, т.к. время на обработку одного запроса ограничено, поэтому использовались различные эвристики, чтобы ограничить количество документов для последующего ранжирования. Это приводило к тому, что в выдачу не попадали некоторые хорошие документы. Сейчас Яндекс проделал огромную работу: посчитал офлайн и сохранил для каждого документа некоторую информацию, которую раньше приходилось считать в режиме реального времени, и это позволяет обходить все релевантные запросу документы. В связи с этим в ближайшее время по некоторым запросам в выдачу могут попасть некоторые новые страницы, но затем ситуация нормализуется.

Само по себе наращивание влияния нейросетей на итоговую оценку релевантности документов запросу, наверное, никого удивлять не должно. После «Палеха» многие ждали применения технологий ко всему документу. Вопрос был лишь, когда это случиться. А случилось довольно быстро. «Королев» – это, безусловно, новый этап не только для поиска, но и для SEO. Утверждать, что что-то заметно изменится в поиске уже завтра, я не буду, но уверен, что в ближайшие полгода мы станем свидетелями заметного изменения поиска. В первую очередь работа нейронных сетей может повлиять на низкочастотные запросы. С ростом вычислительных мощностей и временем влияние пользовательских факторов будет усиливаться. Считаю, что SEO-специалистам при работе под Яндекс помимо привычной работы с внутренней оптимизацией всерьез надо заниматься:

- оптимизацией сниппетов;

- юзабилити посадочных страниц;

- наращиванием качественного непоискового трафика.

Уже сейчас влияние поведенческих факторов на выдачу очень велико, и в ближайшей перспективе оно может еще расти. Известные мне кейсы по улучшению поведенческих подтверждают этот тренд.

В нишах, в которых мы работаем, статистически значимых изменений в ТОПах в последние месяцы (уже слышал от коллег истории, что они почувствовали в августе тестирование/раскатку алгоритма) нами не замечено. Мне кажется, что при имеющейся у Яндекса Big Data запуск алгоритма «Королев» должен проходить плавно, а сравнивать топы нужно позже и за значимые периоды времени.

Как заявляет сам Яндекс: «Умение понимать смысл особенно полезно при обработке редких и необычных запросов — когда люди пытаются описать своими словами свойства того или иного объекта и ожидают, что поиск подскажет его название: [картина где небо закручивается] или [ленивая кошка из монголии]».

Поэтому, как и в случае с «Палехом», мы ожидаем, что сильных изменений по коммерческим и популярным информационным запросам не произойдет, так как основные изменения в первую очередь коснутся уникальных информационных запросов.

В информационной выдаче, по уникальным многословным запросам, мы все же ждем изменений. Приоритет в выдаче будет у сайтов, которые раскрывают смысл запроса, а не содержат вхождения ключевых слов.

Проведенный нами срез по позициям и трафику в промежутке с 8 по 23 августа показывает положительную динамику. Проседаний в связи с новым алгоритмом не наблюдается.

«Королев» пройдет мимо поисковой оптимизации. По крайней мере, на данном этапе. Перед поиском стоит задача дать ответы по запросам, по которым нет документов с вхождениями. Поиск эту задачу решает. Hummingbird в Google, «Палех» и «Королев» в Яндексе. Запросы, по которым нет документов, не входят в зону интереса поисковой оптимизации. Именно поэтому там и нет документов.

Мне, как SEO-шнику, интересен другой аспект возможного влияния алгоритмов по поиску смыслов документа на выдачу: насколько можно будет отказаться от текстового спама на посадочной ради добавления всех ключевых фраз из кластера. Если в кластере 20–30 разнородных ключей, то мне сейчас нужно или делать текст длиной в простыню, или извращаться с оформлением посадочной, или спамить ссылочным. Если «Королев» сможет адекватно ранжировать документ с вхождением только основного ключа по микрочастотке из кластера (ладно, не из кластера, а из запросного индекса или любой другой внутренней базы ключей поиска) – это благо и снижение общей спамности документов и сайта в целом. Если все равно нормальные сайты будут обходить полудорвеи, набитые микрочастоткой, значит, «Королев» и ему подобные алгоритмы нужны поиску только для доразбора документов по смыслам по запросам, где документов нет или мало.

И еще один аспект развития таких технологий вызывает вопрос. Насколько это подтолкнет развитие дорвеестроительства. Доры без вхождений, но с глубоким смыслом, понятным только ботам – это будет настоящий прорыв в деле замусоривания выдачи.

Но в целом ощущение, что это революция лозунгов и смыслов, а не выдачи. В самой выдаче мало что меняется в плане методов выхода в ТОП в последние годы.

Новый алгоритм интересен тем, что работает на уровне индексации документов, создавая кэш, который можно назвать «индексом по смыслу». Обрабатывая запрос пользователя таким же алгоритмом, Яндекс имеет возможность производить быстрый поиск похожих по смыслу документов. Маркетологу и SEO-специалисту надо понимать, что примерно по трети запросов (оценка сверху) повысится конкуренция с неоптимизированными сайтами. По сути, Яндекс их будет как бы бустить, даже без прямых вхождений ключевых слов. С другой стороны, если ваш сайт оптимизирован не идеально, возможно именно вы получите прирост низкочастотного трафика. Как специалисту по поиску, идея использовать индекс размеченных н-грам для быстрой оценки соответствия запроса документу по смыслу кажется мне прогрессивной. Я рад, что Яндекс сумел оптимизировать процесс поиска по смыслу до такой степени, что делает это на лету по всем! проиндексированным документам. Замечу, что в краулер statoperator, первая версия которого появилась еще три года назад, изначально была заложена опция для работы с н-грамами на уровне индексации.

Из непосредственных наблюдений: где-то уже неделю наблюдаю изменения в характере трафика с Яндекса на одном крупном проекте. Например, исчезла, или стала гораздо более слабой «болтанка» туда-сюда алгоритмом однорукий бандит. При этом сайт остался как бы на «пике видимости» последней итерации «бандита».

Анонс алгоритма «Королев» был, наверное, самым масштабным за все время с точки зрения шоу. С точки зрения технологий нельзя сказать, что это какой-то новый технологический прорыв. В чем смысл инновации: теперь нейронные сети Яндекса оценивают соответствие запрос-документ не просто с точки зрения вхождения запроса и его вариаций (леммы, частей запроса и т.д.) в текст документа, но и с точки зрения смысла запроса. Нейронная сеть, обученная на больших данных, теперь умеет определять релевантность документа запросу, даже если в документе нет вхождения слов запроса. На самом деле – это не новая технология – она же использовалась в алгоритме «Палех», правда он учитывал лишь заголовки документов. Т.е. настоящая инновация здесь в том, что инженеры Яндекса сумели масштабировать очень ресурсоемкий алгоритм на несколько порядков – теперь алгоритм может оценивать сотни тысяч документов, а не 150 строк текста как раньше.

Как алгоритм повлияет на рынок SEO?

- Глобально – никак. Это всего лишь часть алгоритма, а большинство других факторов как работали, так и будут работать. Данный алгоритм сильнее всего должен затронуть НЧ-запросы и часть СЧ-запросов.

- Придется уделять больше внимания качеству текстов. Теперь, чтобы вывести страницу в ТОП, текст страницы должен содержать как можно больше слов-синонимов и связанных с запросом слов, чтобы пройти по факторам нового алгоритма, т.к. он теперь учитывает именно такие слова, а не просто «прямые вхождения». Здесь нет никакой магии – нейросеть обучается учителями-асессорами и все равно работает с текстами реальных сайтов, находя связанные по смыслу слова. Значит можно провести похожий анализ и сделать экстракцию этих слова их документов ТОПа. Грамотные SEO-специалисты начали это делать уже несколько лет назад. Если простыми словами – тот же LSI, только в профиль.

- Рынок дешевого копирайтинга начнет схлопываться, и это очень хорошо. Задание на написание текста в формате «3 прямых вхождения, 4 разбавленных и длина 2500 символов» будет порождать тексты, которые будут слабо ранжироваться. Теперь нужны тексты-истории. Мы как SEO-специалисты должны рассказать историю про продукт клиента во всех подробностях, описав продукт со всех сторон – при таком подходе будет физически сложно упустить важные тематичные запросу слова. Заметьте, что вебмастера, зарабатывающие на статейных сайтах, уже очень давно пишут тексты-истории даже о юристах по алиментам, с отличной версткой, раскрытием темы и points of interest. Что в результате? У них куча трафика и ТОПы, плюс тотальная победа над сухими сайтами юридических фирм.

Производство контента станет несколько дороже и профессиональнее. SEO-компании либо перестанут писать SEO-бред и построят взрослые контент-редакции внутри, или их клиенты потеряют позиции в поиске. Яндекса вчера толсто на это намекнул.

Рад, что тренд на постоянное улучшение качества Поиска, оздоровления рынка и работы оптимизаторов, который задал Яндекс еще с момента запуска «Минусинска», продолжается.

Предполагаю, что изменения в краткосрочной перспективе не сильно затронут работу с коммерческими сайтами. Данных для обучения, несмотря на технологический прорыв в количестве и обработке, все еще мало. Самое важное, на мой взгляд, учет обратной связи с очень похожими запросами пользователей в оценке качества документа. В перспективе этот фактор(?) должен повлиять на специально созданные отдельные страницы под запросы с единой целью. Моментального эффекта на частотных запросах ждать не стоит, но с классическим распределением низкочастотных на отдельные URL могут появиться дополнительные сложности.

Сильные изменения в выдаче на нашей выборке сайтов не заметил. Думаю, на этот вопрос лучше ответят коллеги с бо́льшим набором данных — Стас Поломарь и Дима Севальнев.

Хочется больше конкретики для SEO-шников — презентация была рассчитана на обычных пользователей. Надеюсь, Михаил Сливинский ответит на технические вопросы в завтрашнем семинаре по поисковым запросам, в 16:00.

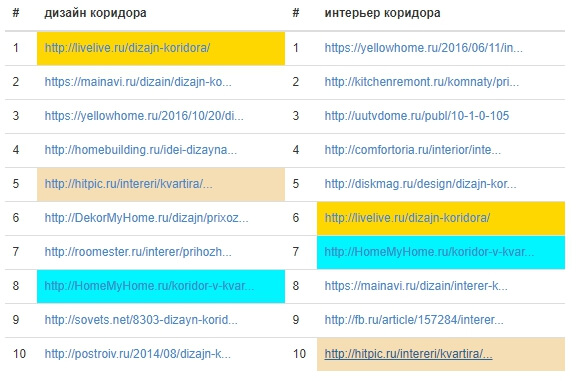

Рассмотрим на практике, у нас есть два очень крупных кластера «дизайн коридора, интерьер коридора», как правило, подобные запросы имеют разную выдачу в Яндексе – , при том, что у них одинаковый интент.

Как сейчас ранжироваться по двум запросам? Нужно делать 2 страницы, которые по факту имеют одинаковый смысл.

«Королев» должен улучшить понимание Яндексом синонимических запросов, что позволит делать меньше материалов, но более высокого качества, а также позволит улучшить качество выдачи по многословным запросам с малым трафиком, под которые оптимизаторы не готовят контент.

В работе SEO-специалистов продолжится изменение в сторону более качественного контента, направленного на удовлетворение человека, а не поисковой системы.

Но смею предположить, что в ближайшее время мы не сможем уйти от «портянок» и SEO-текстов в большинстве ниш.

Ожидаем, что в работе оптимизаторы будут больше использовать LSI при подготовке текстовой оптимизации. Соответственно, будут развиваться SEO-сервисы. Напомню, что подготовка списка SEO-слов, терминов в тематике, смежных запросов для подготовки контента и оптимизации, используется специалистами уже несколько лет. Поэтому серьезных изменений в механике не произойдет, по крайней мере пока.

В итоге, больше внимания уделяем:

- качеству контента;

- интенту запроса;

- мониторингу выдачи.

И, конечно, всегда интересно после запуска нового алгоритма от Яндекса анализировать, что изменилось, и наблюдать, что будет дальше.

Радует, что Яндекс движется в сторону понимания смысла.

Но у медали всегда 2 стороны.

Плюсы:

- Оптимизаторам больше не нужно создавать много одинаковых страниц со схожим смыслом, только из-за того что Яндекс раньше не определял их синонимичность. При том что у Google подобный алгоритм (rank brain) работает с 2015 года и неплохо справляется.

- Проще получить инфотрафик. Теперь не надо подстраивать тексты под каждую словоформу.

Обратная сторона:

- Я опасаюсь, что в итоге алгоритм замкнет весь трафик на самой выдаче. Яндекс будет сам давать ответ на информационные вопросы, не передавая трафик на другие сайты, даже если там информация будет полезнее и лучше. Везде, где ответа не будет, в выдаче останутся только сильные игроки: «Википедия», «Кинопоиск» и т.п.

Раньше маленькие сайты могли использовать упущенные крупными игроками запросы, получить НЧ-трафик, доказать поисковой системе, что их контент тоже достоин ранжирования и понемногу продвигаться к ВЧ-запросам. В новых реалиях, боюсь, эти шансы сведутся на нет. Очень надеюсь, что заблуждаюсь.

Коммерческой выдачи это коснется не сильно. Разве вы будете искать запрос «купить недорого телефон, у которого на задней стороне блестящее надкушенное яблоко»? В коммерческой выдаче смысл не так важен, главное – коммерческая составляющая: цена, условия доставки, представление контента.

Я думаю, проблемы со смыслами могут быть только у узкоспециализированных сайтов в коммерческой тематике. Но остается большой трафик по ремонту чего-либо. Например, по запросу «что делать если автомобиль дергается при переключении передач» – кроме форумов в выдаче появятся услуги ремонта коробки передач. Пока я очень редко такое встречаю.

Было бы хорошо, если бы они алгоритм использовался и для ранжирования объявлений Яндекс.Директа или коммерческих сайтов – понимая смысл проблемы и предлагая её решение. Например, по запросу «купить машину которая поднимает коробки на складе» алгоритм бы показывал объявления по запросу «штабелеры», а не компании по ремонту АКПП или объявления по продаже автомобилей (пример, конечно, утрированный).

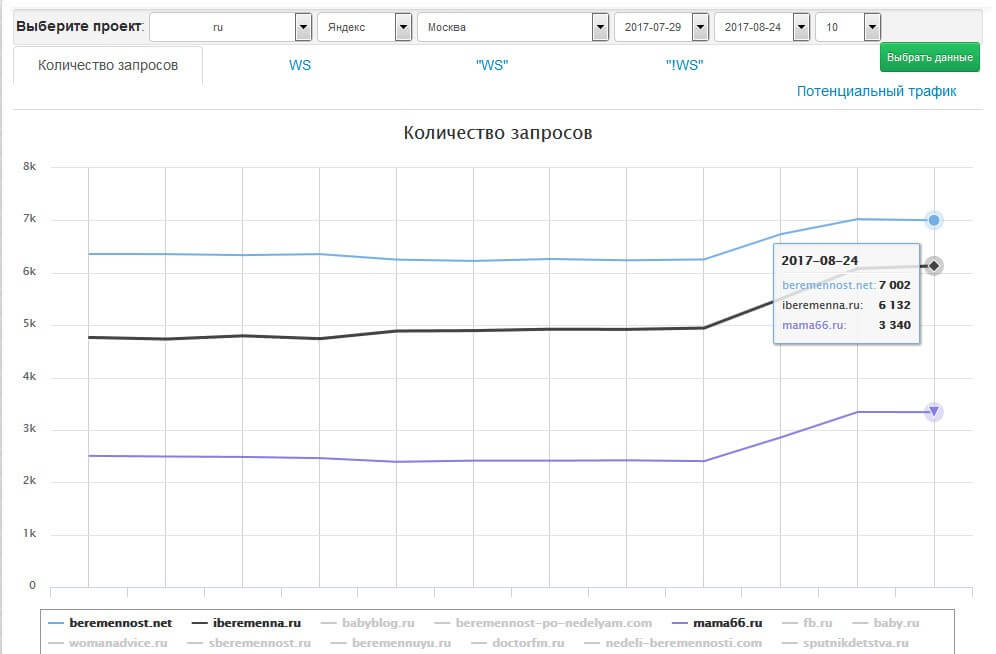

Логично предположить, что «Королев» скажется на ранжировании по информационным запросам сильнее, чем по коммерческим. Несколько вполне обоснованных аргументов в пользу этого тезиса дали мои коллеги выше. Но пока на достаточно большой выборке (несколько сотен тысяч) запросов ощутимых изменений нет. Есть точечные взлеты в информационных тематиках, которые можно притянуть к «Королеву». Например, в тематике "Забота о детях" наблюдается такая картина:

* скриншот сделан в аналитической платформе 4seo.work

В некоторых коммерческих тематиках наблюдается нечто подобное, но пока я не решусь связывать это именно с новым алгоритмом.

Прежние методы анализа (достаточно примитивные по сравнению с нейросетями в Яндексе) будут давать все меньше полезной информации. Но без анализа продвигать сайты, как минимум, тяжело, поэтому вскоре появятся новые, более продвинутые методы.

Однако уже сейчас понятно, что больше всего профита получат сайты, которые хорошо отвечают на большое количество запросов. Понятие «запросный индекс» выходит на новый уровень, и задача анализа сайтов по максимально большому семантическому ядру становится как никогда актуальной.

Новый алгоритм работает на основе нейросети, изначально был обучен на асессорах, небольшой группе реальных пользователей, а после анонса будет обучаться на запросах (и поведении) всех пользователей. Кроме того, смысл каждого документа буде дополняться поисковыми запросами, по которым его находят пользователи. Такой подход должен значительно повысить эффективность работы с запросами, в которых пользователь не знает точно, что он ищет, но может это описать по смыслу или значению. Такие запросы часто приходят из голосового поиска, популярность которого растет, так что Яндекс сделал правильный шаг.

«Королев» со всем не про SEO. Цель SEO – работа с запросами, которые спрашивают много раз и смысл их понятен, а релевантных ответов тысячи. Задача поисковика в коммерческом сегменте – найти лучших кандидатов по коммерческим критериям, а не искать смыслы. Именно поэтому коммерческая выдача не изменится, по крайней мере сколько-либо заметно.

А вот владельцам информационных ресурсов еще раз стоит обратить внимание на качество контента, ориентировать свои публикации не под поисковые запросы, а под интересы пользователей, писать человеческим простым языком.

Дмитрий Севальнев, совладелец и руководитель отдела SEO и рекламы компании

Дмитрий Севальнев, совладелец и руководитель отдела SEO и рекламы компании  Дарья Черникова, аналитик технологий

Дарья Черникова, аналитик технологий  Денис Нарижный, руководитель интернет-агентства

Денис Нарижный, руководитель интернет-агентства  Сергей Никоноров, руководитель направления поискового продвижения

Сергей Никоноров, руководитель направления поискового продвижения  Дмитрий Шахов, директор

Дмитрий Шахов, директор  Станислав Ставский, сооснователь

Станислав Ставский, сооснователь  Олег Шестаков, CTO & Founder в

Олег Шестаков, CTO & Founder в  Константин Солодянников, руководитель SEO в

Константин Солодянников, руководитель SEO в  Игорь Рудник, сооснователь

Игорь Рудник, сооснователь  Владимир Тапханаев, руководитель группы поискового продвижения

Владимир Тапханаев, руководитель группы поискового продвижения  Андрей Ефремов, руководитель отдела SEO

Андрей Ефремов, руководитель отдела SEO  Александр Алаев, директор

Александр Алаев, директор

Теги:

Теги: