Меня зовут Павел Кондрашов, я ведущий менеджер по SEO в i-Media. Мы помогаем компаниям находить клиентов из поиска и делаем так, чтобы сайт приносил продажи. В статье расскажу, как я выявил неспособность Screaming Frog эмулировать ботов Яндекса. Материал будет полезен как новичкам, так и опытным специалистам.

Слишком много пустых тегов

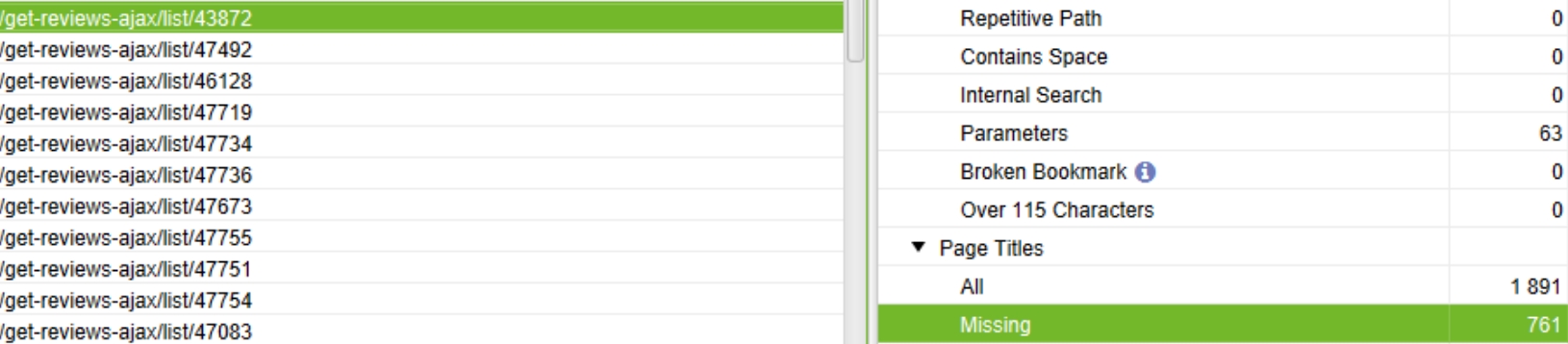

В процессе парсинга сайта клиента я обнаружил необычно большое количество пустых тегов title на страницах, которые должны быть закрыты от индексации. Стал думать, с чем это может быть связано. Подозрение пало на robots.txt.

Из скрина видно, что пустых тегов чуть меньше 50%, что кратно выше нормы

С помощью Вебмастера и служебного файла посмотрел, учитывает ли программа необходимую директиву. Гипотеза не подтвердилась, файл был корректен, но проблема не исчезла.

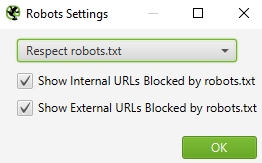

Затем я предположил, что при парсинге у меня было включено игнорирование файла во фроге. Но здесь тоже все было в порядке.

Из скрина видно, что программа учитывает robots при парсинге, а значит проблема не в выбранной настройке

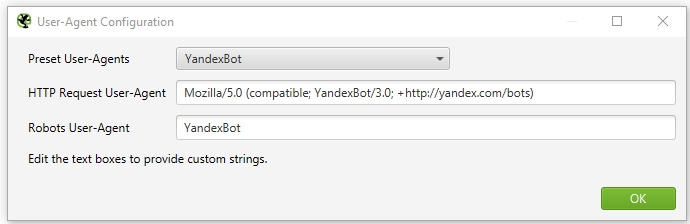

Затем мне пришла идея – сравнить в каком из user-agent в robots.txt сайта расположена закрывающая директива и какого user-agent эмулирует Frog. Оказалось, что в robots.txt, директива стоит только для user-agent Yandex bot, а в Screaming Frog Google bot. Чтобы проверить гипотезу, поменял Google bot на Yandex bot, запустил парсинг, но страницы остались.

Все оказалось куда интереснее

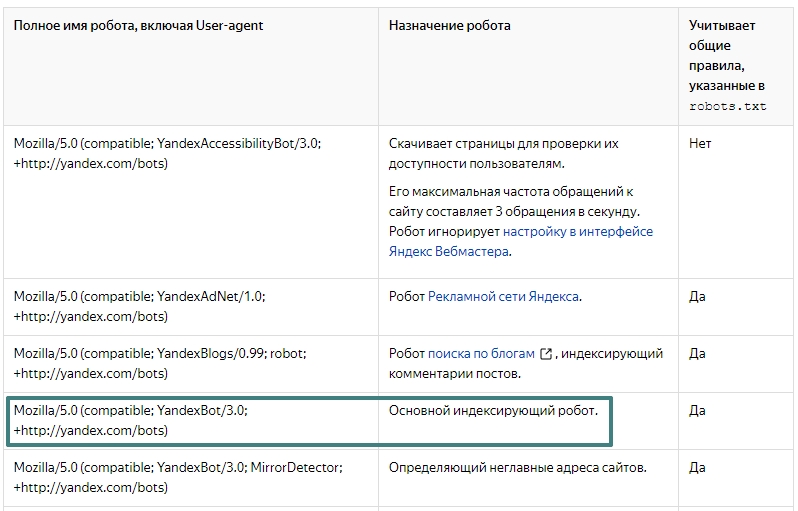

На этом идеи закончились. Я обращался к коллегам, но никто ранее не встречался с такой проблемой и советовали сделать то, что уже проверил и не сработало. Тогда я решил сравнить список ботов, указанных в Яндекс Справке со списком в Screaming Frog. Они были одинаковые. Затем сравнил версии, так как подумал, что во фроге была не последняя. Но нет.

После некоторого времени раздумий появилась гипотеза о неспособности Screaming Frog эмулировать ботов Яндекса. Это бы означало, что самый популярный и известный инструмент SEO-специалиста не такой уж универсальный.

User-agent в Яндекс Справке полностью совпадал с указанным в Screaming Frog

Чтобы убедиться в гипотезе, я добавил кастомный файл robots.txt в Screaming Frog. Он содержал директиву, закрывающую страницу от индексации для всех user-agent. Все заработало, страницы перестали попадать в Screaming Frog.

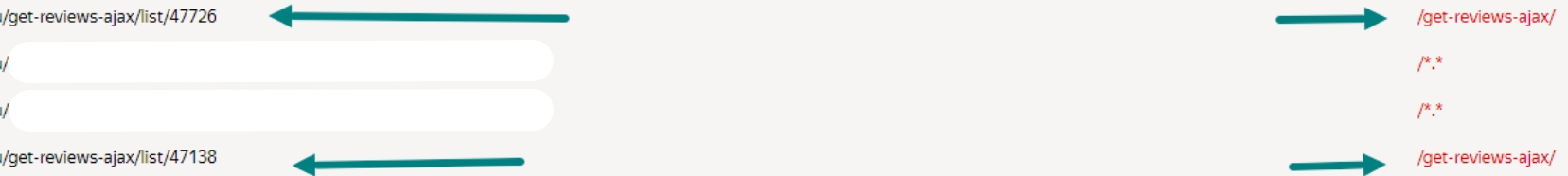

И, наконец-то, страницы пропали

Бот Яндекса 1:0 Screaming Frog

Этот случай выявил неспособность Screaming Frog эмулировать ботов Яндекса, а значит, аналитики и оптимизаторы должны быть внимательны к возможным ограничениям инструментов и проверять полученные данные в Яндекс Мастере. Только так можно обеспечить точность результатов и гарантировать эффективные шаги по улучшению показателей веб-ресурсов.

Теги:

Теги: