Техническая оптимизация – первая и важнейшая часть в SEO. Это фундамент, без которого последующие работы будут неэффективны. Этот этап работы с сайтом состоит из множества задач, часть из которых критично важна. К ним относится и индексация страниц.

Индексация – это процесс, при котором поисковые системы анализируют и сохраняют информацию о веб-страницах в базу данных (индекс). Когда страница проиндексирована, она может появиться в результатах поиска.

В этой статьей SEO-эксперты Ingate Organic разобрали инструменты и способы, которые помогут ускорить индексацию страниц, а также причины, по которым сайт не попадает в поиск.

Что такое индексация

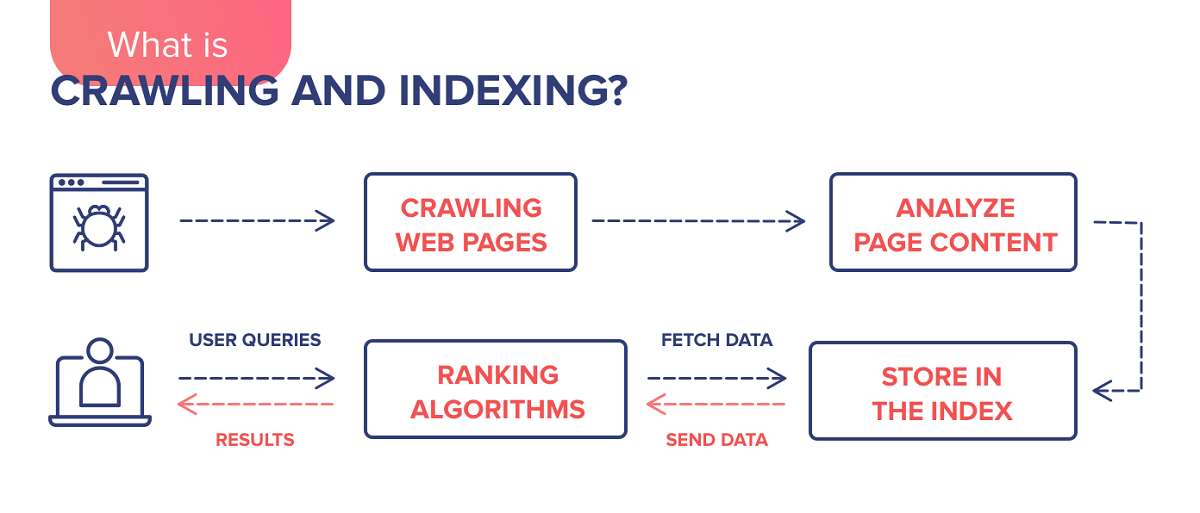

Чтобы лучше понять определение, коротко рассмотрим этапы попадания сайта в органическую выдачу:

Обнаружение сайта. Поисковые роботы (краулеры) начинают свой процесс, найдя ссылки на ваш сайт.

Сканирование контента. Роботы переходят по найденным ссылкам и анализируют содержимое каждой страницы. Они собирают информацию о тексте, изображениях, ссылках и других элементах на странице.

Индексация. После сканирования поисковая система добавляет информацию о сайте в свою базу данных (индекс).

Обновление индекса. Поисковые системы периодически обновляют свои индексы, чтобы отражать изменения на сайте и в интернете в целом. Это включает в себя периодическое повторное сканирование страниц сайта для обновления информации в индексе.

Эти этапы помогают поисковым системам эффективно анализировать и организовывать контент в интернете, чтобы пользователи могли находить нужную информацию.

Необходимый минимум

Итак, как мы выяснили, чтобы страницы попали в индекс, необходимо, чтобы поисковые системы узнали о существовании конкретного сайта и могли просканировать его.

Разберем, что для этого необходимо:

Настройка и создание файла sitemap.xml (карта сайта). Этот файл предназначен для поисковых систем. В нем указываются ссылки на страницы, которые необходимо проиндексировать. По адресу http://site.ru/sitemap.xml нужно создать актуальную карту сайта, учитывая следующие требования:

- Используйте кодировку UTF-8. Робот Яндекса распознает кириллические URL как в закодированном виде, так и в оригинале.

- Рекомендуемое количество ссылок – 50 000. Вы можете разделить Sitemap на несколько отдельных файлов и указать их в файле индекса Sitemap.

- Указывайте ссылки на страницы только того домена, на котором будет расположен файл.

- Разместите файл на том же домене, что и сайт, для которого он составлен.

- При обращении к файлу sitemap.xml сервер должен возвращать HTTP-код 200.

Более подробная информация о требованиях и возможных ошибках указана в Яндекс Справке.

Добавление сайта в Яндекс Вебмастер и Google Search Console. Это бесплатные инструменты для владельцев сайта и веб-мастеров. В них собирается информация об эффективности сайта в поиске, техническом состоянии и ошибках.

Добавить сайт в каждый из сервисов довольно просто. Подробные шаги добавления для каждой поисковой системы описаны в инструкциях:

Далее обязательно добавьте ссылку на Sitemap.xml, созданную ранее, в каждый из инструментов.

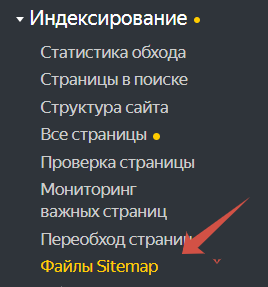

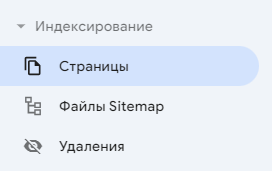

Яндекс Вебмастер: Индексирование – файлы Sitmap.xml – добавить файл (вставляете ссылку).

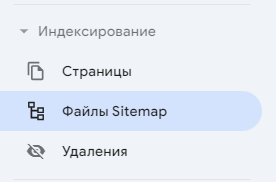

Google Search Console: Индексирование – файлы Sitmap.xml – добавить файл (вставляете ссылку).

Настройка и создание файла Robots.txt. Он предназначен для указания параметров сканирования роботом поисковых систем. Первым делом при посещении вашего сайта поисковые роботы изучают директивы (указания) данного файла и на основе него сканируют сайт. С его помощью можно скрыть страницы результатов поиска, фильтрации, системные файлы, добавить директиву для исключения страниц с get-параметрами.

Главное, чтобы были открыты для сканирования продвигаемые посадочные страницы.

Также следует указать ссылку на актуальный файла sitemap.xml.

Sitemap: https://www.site.ru/sitemap.xml

Важно: Без данного файла поисковые системы все равно проиндексируют страницы. Он нужен, чтобы регламентировать сканирование для корректного отображения в поиске.

Директивы в файле поисковые системы воспринимают как рекомендации, поэтому могут проигнорировать некоторые указания и все равно проиндексировать ту или иную страницу. Например, если на страницу ведет много внутренних ссылок, но при этом она недоступна в файле, ПС включат их в индекс.

Что может мешать быстрой индексации

Долгая загрузка или отсутствие доступа к странице. Если при обращении к сайту поисковые системы не смогут получить содержание и просканировать страницу, они не добавят ее в базу данных, следовательно, и участвовать в ранжировании она не будет.

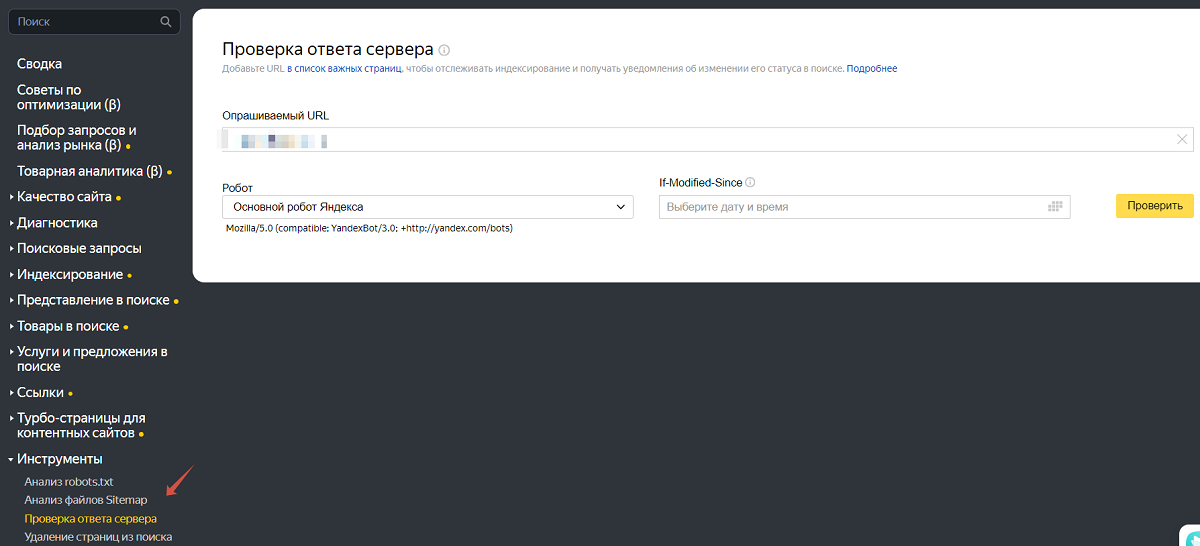

Чтобы избежать подобных проблем, надо настроить быструю загрузку сайта (и обеспечить быстрый ответ сервера – не более 200-300 мс). Проверить скорость ответа сервера можно в Яндекс Вебмастере:

Проверить скорость загрузки можно с помощью PageSpeed.

В случае критических ошибок с доступностью сайта в панели вебмастера появится соответствующее уведомление.

Некорректно настроенный атрибут rel canonical. Тег rel="canonical" используется для предоставления рекомендации поисковым системам относительно канонического (предпочтительного) URL-адреса страницы. Если для продвигаемой страницы, которая должна участвовать в поиске, в данном теге указана другая страница, необходимо поправить на корректную.

Проверку отдельной страницы можно осуществить с помощью сервиса.

Запрет на индексацию в meta-robots/ X-Robots-Tag. Необходимо регулярно проверять, нет ли запрета на индексирование для отдельных страниц. Подобные проблемы могут возникнуть из-за некорректной настройки и работы с CMS или ошибок разработчика.

Метатег robots и заголовки HTTP X-Robots-Tag используются для управления индексацией страниц поисковыми системами. Они предоставляют инструкции поисковым роботам о том, следует ли индексировать страницу или нет. Вот как они работают:

Метатег роботов (Meta Robots):

- Это HTML-тег, который помещается в секцию каждой страницы вашего сайта.

- Он содержит директивы для поисковых роботов, указывающие, как они должны обрабатывать страницу.

- Например, директива "noindex" указывает поисковым роботам не индексировать содержимое страницы, а "nofollow" просит не переходить по ссылкам на этой странице.

- Пример использования: < meta name="robots" content="noindex, nofollow" >.

Заголовок HTTP X-Robots-Tag:

- Это HTTP-заголовок, который отправляется вместе с ответом сервера при запросе к странице.

- Он также предоставляет инструкции поисковым роботам относительно индексации страницы.

- По аналогии с метатегом роботов он может содержать директивы, такие как "noindex", "nofollow" и другие.

- Пример использования: X-Robots-Tag: noindex, nofollow.

Оба этих метода позволяют контролировать индексацию ваших страниц поисковыми системами. Их использование зависит от ваших предпочтений и требований сайта.

Важно: не путайте метатег robots и файл robotos.txt. Если вы хотите закрыть отдельную страницу от индексации и исключить ее из индекса, пользуйтесь метатегом, но не двумя инструментами одновременно.

Например, у вас есть страница, которая не должна индексироваться. Для этого вы добавляете метатег < meta name="robots" content="noindex, nofollow" >, но при этом в файле robots.txt закрыли доступ к сканированию. В данном случае поисковые роботы не смогут получить информацию о странице, а следовательно, и учесть директиву метатега. И страница останется в индексе.

Проверить, не закрыта ли страница, можно с помощью сервиса.

Неуникальный контент/дубли продвигаемых страниц. Если вы скопировали чужую статью, добавили на свой сайт и ждете на нее трафик, скорее всего поисковые системы проигнорируют данную страницу, так как она не несет никакой ценности для пользователей.

То же самое касается дублирующегося контента в рамках одного сайта: поисковые системы могут выбрать для индексации одну из ваших дублирующихся страниц, даже если она не актуальна. А может и вовсе не индексировать ни одну из страниц, так как подобные ошибки свидетельствуют о том, что сайт недостаточно качественный.

Как ускорить индексацию с помощью инструментов

Подобные инструменты могут понадобится случаях, если:

- Страницы долго не индексируются, но ПС о них знают.

- Вы создали новые страницы или обновили имеющиеся и хотите, чтобы поисковые системы узнали об этом быстрее.

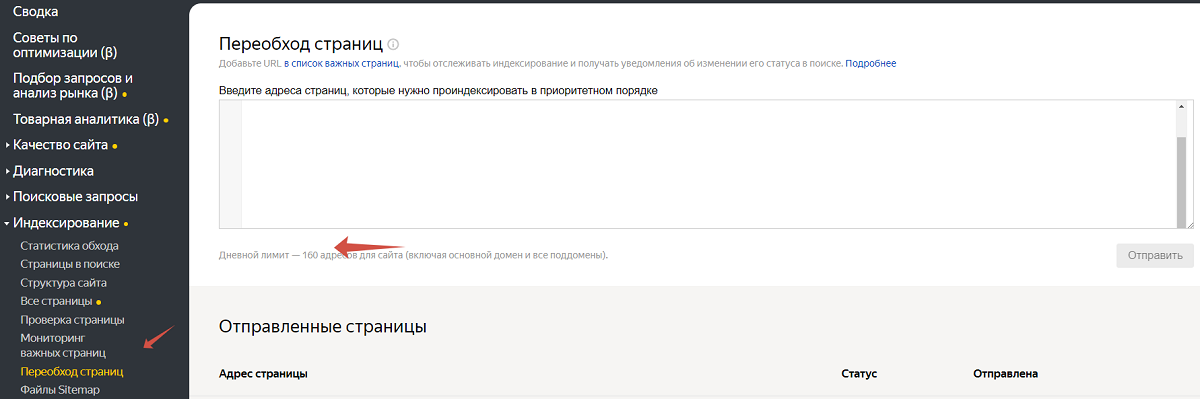

Для Яндекса есть инструмент в Яндекс Вебмастере: Индексирование – Переход страниц:

Дневной лимит зависит от показателя ИКС – минимум 30 страниц в день для любого сайта.

Index Now. Данный протокол позволяет автоматически сообщать поисковым системам об изменениях на сайте: появлении новых страниц, обновлении или удалении уже проиндексированных страниц. Подробнее о настройке и принципе работы можно узнать в справке Яндекса.

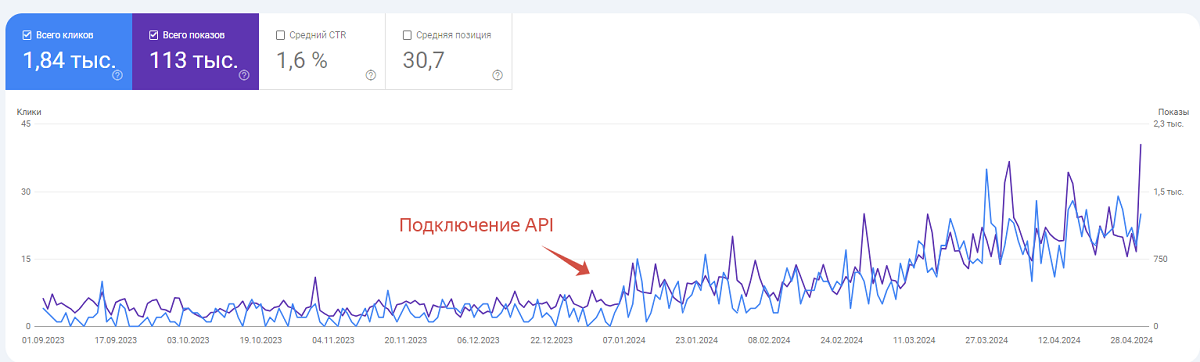

Google Indexing API – инструмент Google, который позволяет отправлять за сутки 200 URL-адресов.

- Установите node.js на вашем компьютере.

- Создайте сервисный аккаунт в консоли Google Cloud Platform.

- Получите закрытый JSON-ключ для вашего сервисного аккаунта.

- Скачайте необходимый скрипт и вставьте ключ в соответствующее место, заменив содержимое service_account.

- Привяжите скрипт к Google Search Console, установив для client_email роль "Владелец".

- Перейдите по ссылке, выберите созданный сервисный аккаунт и активируйте Index API.

- Откройте файл urls в папке со скриптом и добавьте URL-адреса. Помните, что в день можно отправлять не более 200 ссылок.

- Запустите PowerShell.

- Введите команду node index js.

По сравнению с Яндексом, Google дольше индексирует страницы, поэтому рекомендуем пользоваться API постоянно. Вот пример, как быстрая индексация влияет на увеличение видимости сайта:

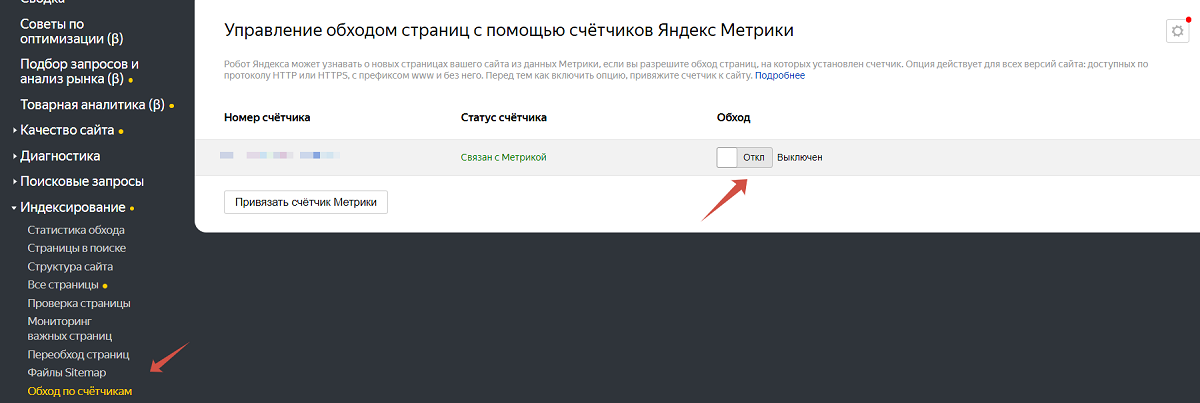

Переобход по счетчику Яндекс Метрики. Это еще один способ ускорить индексацию страниц. Роботы поиска Яндекса могут получать сигналы из Яндекс Метрики о появлении новых страниц на вашем сайте, даже если они еще не внесены в ваш sitemap.xml.

Как проверить, какие страницы сайта индексируются

В данном случае нам потребуются установленные ранее сервисы. Смотреть статистику необходимо отдельно в каждой поисковой системе:

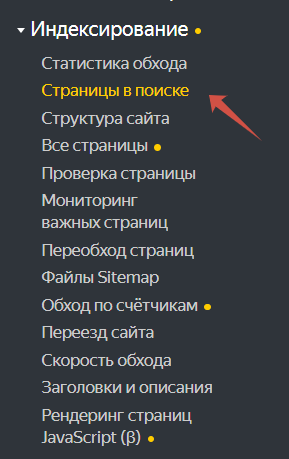

1. Проверка индексации в Яндексе: переходим в Яндекс Вебмастер – Индексирование (в левом меню) – Страницы в поиске.

В отчете вы также можете посмотреть информацию, какие страницы были удалены и почему, а также историю индексации страниц всего сайта.

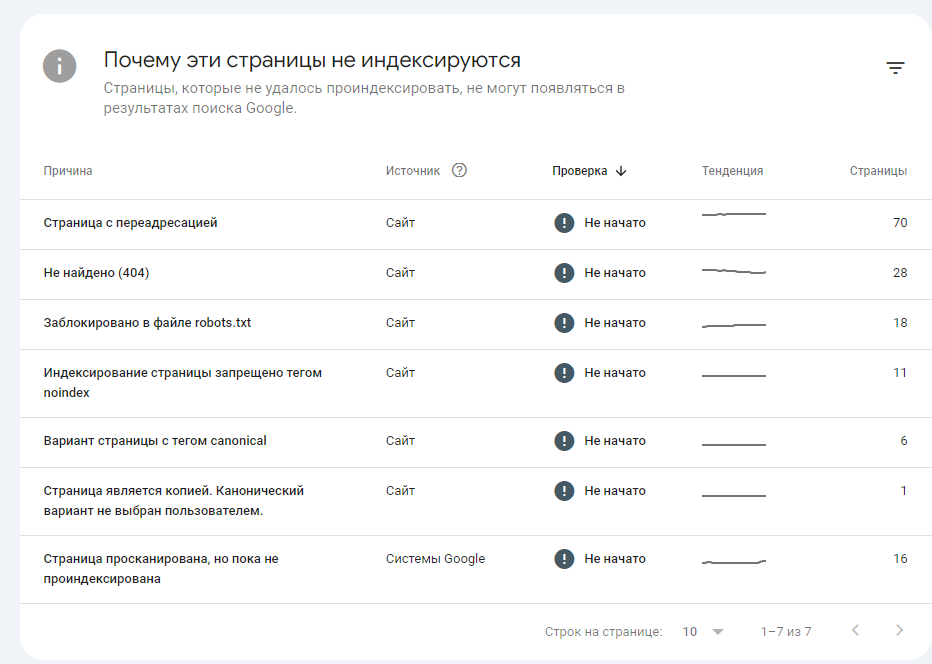

2. Проверка в Google: переходим в Google Search Console – Индексирование – Страницы:

В отчете вы увидите, какие страницы в индексе, какие нет, а также причины, по которым страница не в поиске:

3. Если вас интересует индексация отдельных страниц, можно использовать платные сервисы, например Арсенкин, PR-CY. Для получения информации соберите URL-адреса страниц, добавьте в инструмент список и выберите поисковые системы.

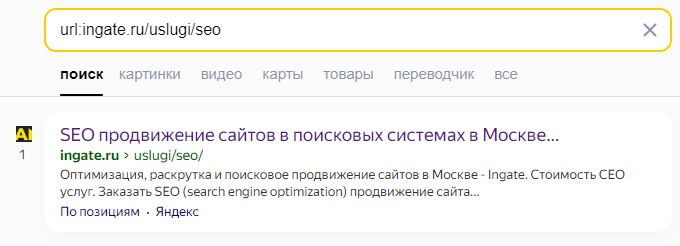

4. Проверку можно осуществить и вручную, но только для одной страницы единоразово. Используйте оператор “url”. Например, “url:ingate.ru/uslugi/seo.” – найдет в индексе соответствующую страницу:

Выводы

Чтобы ускорить индексацию сайта, необходимо на базовом уровне обеспечить доступность сайта, исправить ошибки внутренней оптимизации, а также использовать дополнительные инструменты.

Попадание в индекс сайта или отдельных его страниц очень важно для поискового продвижения. Но не менее важно, чтобы проиндексированные страницы были эффективными с точки зрения бизнеса: приносили трафик, лиды и клиентов. Поэтому важно подходить к поисковому продвижению комплексно, а ускорение индексации – лишь малая часть всех работ.

Теги:

Теги: