Владельцы сайтов интернет-магазинов регулярно сталкиваются с тем, что при индексации страницы пагинации воспринимаются поисковыми системами как дубли. Чтобы избежать этого, программисты и SEO-специалисты должны внимательно следить за настройками страниц — причем не только в файле robots.txt, но и в программном коде.

Запуск сайта и проблемы с выдачей

Вводная: наша компания получила задачу на оптимизацию и продвижение небольшого сайта-витрины — заказ товаров осуществляется не при помощи корзины, а через форму обратной связи с клиентами. Работа планировалась по региону, поэтому серьезных проблем с конкуренцией не ожидалось.

Пока сайт находился в разработке, он был закрыт для индексации строчкой Disallow: / в файле robots.txt. Когда программисты и дизайнеры «отшлифовали» сайт, его наполнили и оптимизировали. После этого строчку Disallow: / убрали.

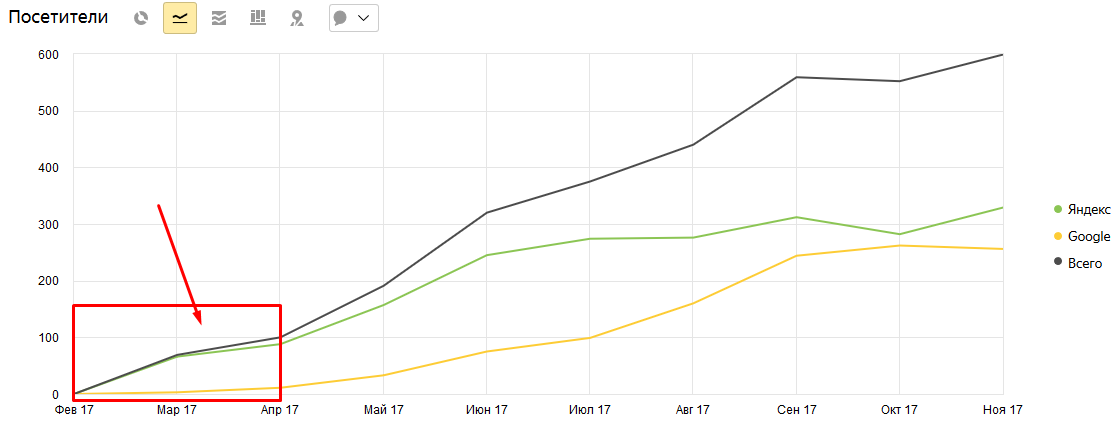

Все понимали, что ресурс молодой, и мгновенной волны трафика не ожидали. Однако и через месяц посещаемость была очень низкой, а в выдаче ресурс не вошел даже в сотню по Google и Яндексу по большинству запросов. Видимость была у главной и общих страниц — «О нас», «Контакты» и другие. Конверсию приносила только «Главная».

На этом этапе стало понятно, что где-то допущена ошибка.

Что пошло не так

При разработке сайта программистам поставили задачу — добавить на страницы пагинации строку < meta name="robots" content="noindex, follow"/ >. При помощи этой строчки получается избежать проблем с дублями страниц категорий и избавить сайт от необходимости конкурировать с самим собой. Она дает поисковикам указание не индексировать информацию на страницах, но выполнять переходы по ссылкам, которые на ней есть.

Чтобы избежать дублей, используют и другие методы. В разных ситуациях оптимизаторы отдают предпочтение тегу canonical или даже создают для каждой страницы пагинации уникальные метатеги и тексты описаний.

При разборе ситуации выяснилось, что строку вписали в код на страницах не только пагинации, но и самих категорий, поэтому для индексации они тоже оказались невидимыми — ни позиций, ни трафика.

Программисты все исправили, и уже спустя пару недель появились первые результаты по видимости и притоку трафика.

На графике рамкой выделен промежуток до исправления ошибок:

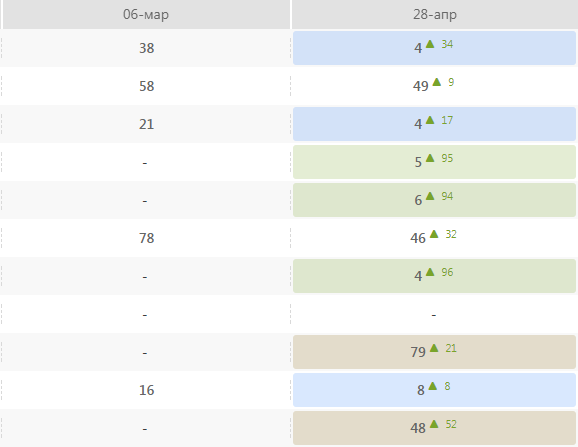

Разница позиций — до и после исправления:

Вывод: проверяйте индексацию не только в robots.txt, но и непосредственно в коде страниц. Результаты продвижения могут быть плохими не из-за неправильной оптимизации, а банально потому, что некоторые страницы робот даже не увидел.

Также вам может быть интересно Редирект: избавляемся от зеркал и возвращаем позиции

Теги:

Теги: