Для эффективного процесса SEO-продвижения необходима быстрая и корректная индексация страниц сайта. В этой статье мы рассмотрим, как ограничивать индексацию определенных страниц или всего сайта.

Какие страницы необходимо закрывать от индексации

Важно обеспечить, чтобы в результатах поиска присутствовали только целевые страницы, соответствующие запросам пользователей. Для этого необходимо аккуратно подходить к индексации содержимого, исключая из нее следующие категории:

- Страницы административной части сайта, содержащие информацию, не предназначенную для публичного доступа.

- Страницы с личными данными пользователей.

- Дублирующиеся страницы.

- Страницы с устаревшей информацией.

- Версии для печати, RSS-ленты, медиаконтент и страницы поиска.

- Страницы с нерелевантным контентом.

- Страницы, содержащие информацию, ориентированную на ограниченную аудиторию, например, корпоративные ресурсы для внутреннего использования сотрудниками компании.

- Сайты-аффилиаты.

Основные способы закрыть сайт или страницы от индексации

1. Закрытие от индексации через robots.txt

Основной способ закрыть страницы от индексации – использование файла robots.txt. В этом файле можно указать роботам с помощью специальных директив, какие страницы сайта они не должны индексировать.

Примеры использования robots.txt:

- Закрыть для всех поисковых ботов:

User-agent: *

Disallow: /

- Закрыть индексацию для конкретного робота:

User-agent: Yandex

Disallow: /

- Закрыть полностью раздел или категорию:

User-agent: *

Disallow: /category/

- Закрыть все, кроме указанного раздела:

User-agent: *

Disallow: /

Allow: /category

- Для запрета индексации изображений:

Usеr-Аgеnt: *

DіsаІІоw: *.jрg (*.gіf или *.рng)

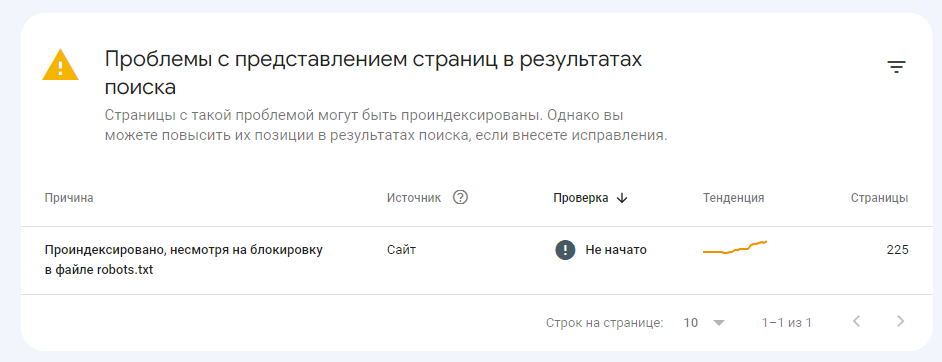

Стоит учитывать, что запрет индексации через robots.txt не всегда учитывается Google и поэтому иногда стоит рассмотреть более «хардовые» варианты.

2. Закрытие от индексации с помощью мета-тега noindex

Мета-тег noindex является одним из эффективных способов предотвращения индексации страниц поисковыми роботами. Этот тег позволяет веб-мастерам контролировать, какие страницы должны быть проиндексированы поисковыми системами, а какие нет.

Что такое мета-тег noindex?

Мета-тег noindex – это специальный HTML-тег, который можно добавить в < head > каждой страницы вашего сайта. Этот тег дает указание поисковым роботам не индексировать содержимое страницы. Таким образом, страница не будет отображаться в результатах поиска.

Пример использования мета-тега noindex

Предположим, у вас есть страница на сайте, которую вы хотите исключить из поисковой выдачи. Для этого добавьте на эту страницу мета-тег noindex следующим образом:

< !DOCTYPE html >

< html >

< head >

< meta charset="UTF-8" >

< meta name="robots" content="noindex" >

< title >Моя страница< /title >

< /head >

< body >

< h1 >Содержимое страницы< /h1 >

< p >Текст вашей страницы здесь...< /p >

< /body >

< /html >

После добавления данного кода на страницу, она не будет проиндексирована поисковыми роботами.

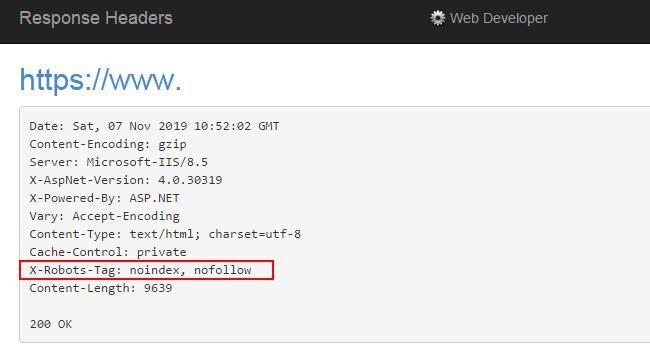

3. С помощью HTTP-заголовка X-Robots-Tag

HTTP-заголовок X-Robots-Tag – это мощный инструмент, который позволяет веб-мастерам контролировать индексацию своего сайта поисковыми роботами. Далее мы расскажем, как использовать этот заголовок для закрытия от индексации отдельных страниц на сайте.

Что такое HTTP-заголовок X-Robots-Tag?

HTTP-заголовок X-Robots-Tag является частью протокола HTTP и используется для передачи инструкций поисковым роботам относительно индексации и сканирования страниц.

Пример использования HTTP-заголовка X-Robots-Tag

Предположим, у вас есть страница на сайте, которую вы хотите исключить из поисковой выдачи. Для этого добавьте следующий код в файл .htaccess:

< IfModule mod_headers.c >

Header set X-Robots-Tag "noindex, nofollow"

< /IfModule >

Основные директивы X-Robots Tag:

1. noindex

noindex указывает поисковым системам не индексировать данную страницу. Это означает, что страница не будет показываться в результатах поиска. Пример использования:

X-Robots-Tag: noindex

2. nofollow

nofollow указывает поисковым роботам не следовать по ссылкам на данной странице. Это позволяет контролировать передачу силы ссылок на странице. Пример использования:

X-Robots-Tag: nofollow

3. noarchive

noarchive запрещает поисковым системам кэшировать содержимое страницы. Это означает, что страница не будет доступна в кэше поисковых систем. Пример использования:

X-Robots-Tag: noarchive

4. nosnippet

nosnippet указывает поисковым системам не выводить сниппет (краткое описание) страницы в результатах поиска. Пример использования:

X-Robots-Tag: nosnippet

5. noimageindex

Директива noimageindex предотвращает индексацию изображений на странице поисковыми системами. Пример использования:

X-Robots-Tag: noimageindex

4. Через htaccess с помощью команды SetEnvIfNoCase User-Agent "^Googlebot (Yandex)" search_bot

Одним из методов закрытия страниц от индексации является использование директивы SetEnvIfNoCase User-Agent в файле .htaccess. Давайте рассмотрим, как это можно сделать.

Что такое SetEnvIfNoCase User-Agent?

SetEnvIfNoCase User-Agent — это директива в файле .htaccess, которая позволяет задавать условия на основе User-Agent (идентификатора поискового робота) и применять к ним определенные действия. Это позволяет контролировать поведение поисковых роботов на сайте, включая индексацию страниц.

Пример использования SetEnvIfNoCase User-Agent

Предположим, у вас есть страница "example-page.html", которую вы хотите исключить из индексации только для поискового робота Googlebot. Для этого добавьте следующий код в файл .htaccess:

< IfModule mod_setenvif.c >

SetEnvIfNoCase User-Agent "^Googlebot" search_bot

< Files "example-page.html" >

Order Allow,Deny

Allow from all

Deny from env=search_bot

< /Files >

< /IfModule >

Теперь страница "example-page.html" будет скрыта от индексации только для Googlebot.

Как закрыть от индексации сайт на Wordpress

Отдельно стоит рассмотреть, как можно запретить индексацию сайта, сделанного на Wordpress. Помимо общепринятых вариантов, рассмотренных выше есть еще несколько способов как это сделать в данной CMS:

Закрытие сайта во время разработки

Если вы работаете над новым сайтом или проводите обновления на существующем, вы можете временно закрыть его от индексации, чтобы избежать индексации незавершенных страниц. Для этого можно воспользоваться плагинами, такими как "Under Construction" или "Maintenance Mode".

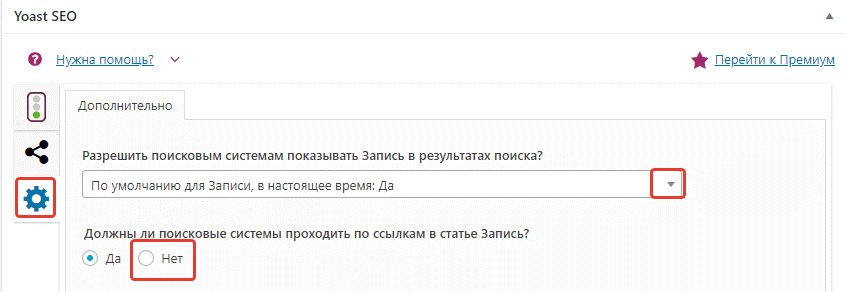

Использование плагинов

На WordPress существует множество плагинов, которые облегчают процесс закрытия сайта или страниц от индексации. Например, плагин Yoast SEO позволяет легко управлять индексацией отдельных страниц.

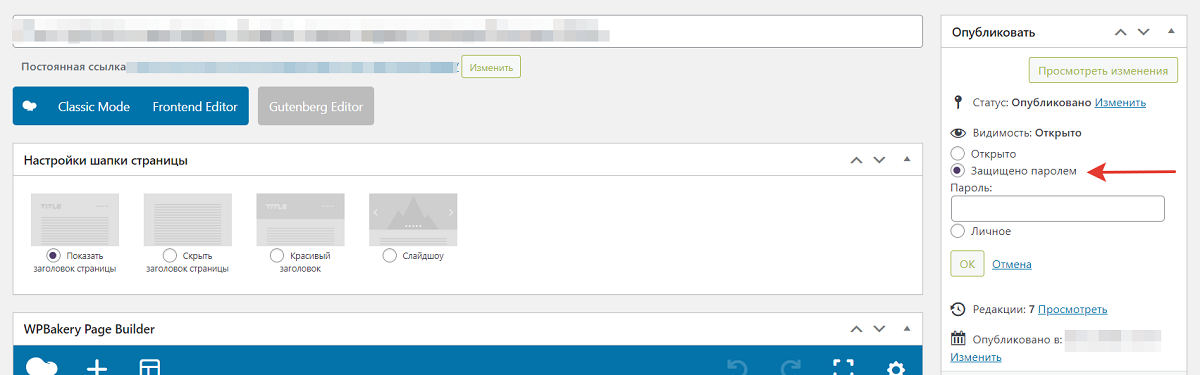

Использование парольной защиты

Для более надежной защиты от индексации вы можете добавить парольную защиту к сайту или определенным страницам. В WordPress это можно сделать через функцию "Защита паролем" при публикации страницы.

Заключение

Закрытие сайта или отдельных страниц от индексации является важным шагом для защиты конфиденциальной информации и контроля видимости вашего контента в поисковых системах. Используйте описанные способы с умом и следите за индексацией вашего сайта, чтобы обеспечить его безопасность и эффективность в поисковых результатах.

Теги:

Теги: