Роботы поисковых систем используют файл robots.txt для определения того, какие страницы сайта они могут сканировать. Небольшие ошибки в этом файле могут привести к проблемам с индексацией и ранжированием в поисковых системах. В этой статье рассмотрим основные ошибки в robots.txt и способы их исправления.

Что такое robots.txt

Robots.txt – это текстовый файл, который веб-мастера размещают на своем сайте для управления поведением поисковых роботов, таких как Googlebot. Данный файл указывает поисковым роботам, какие страницы сайта они могут сканировать и индексировать, а какие – нет.

Файл robots.txt содержит инструкции для поисковых роботов в виде директив, таких как:

- User-agent (указание агента – поискового робота).

- Disallow (запрет доступа к определенным разделам сайта).

- Allow (разрешение индексирования к определенным разделам сайта).

С помощью robots.txt веб-мастера могут контролировать доступ поисковых роботов к различным разделам сайта, блокировать нежелательные страницы или директории, а также указывать местоположение карты сайта и другие параметры.

Этот файл является важным инструментом для SEO-оптимизации, поскольку позволяет улучшить индексацию и ранжирование сайта в поисковых системах. Однако неправильная настройка или ошибки в файле robots.txt могут привести к проблемам с индексацией и видимостью сайта в поисковой выдаче. Поэтому важно внимательно настраивать и регулярно проверять этот файл для оптимальной работы сайта в поисковых системах.

Основные ошибки в robots.txt

Ошибка №1: Неправильное использование символов-джокеров

Один из наиболее распространенных типов ошибок в файле robots.txt – это неправильное использование символа-джокера.

Выделяют два типа символов подстановки:

- Звездочка (*)

- Доллар ($)

Символ подстановки звездочка (*) означает любое количество символов. Например, вы хотите закрыть от индексации все страницы с вхождением в URL-адрес – «example». Это можно сделать с помощью директивы:

User-agent: *

Disallow: *example*

Символ подстановки доллара ($) обозначает конец URL и позволяет добавлять правила к последней части URL, например, файловое расширение.

Пример использования:

User-agent: *

Disallow: /example/$

Данная директива запрещает индексацию папки example, но не запрещает сканирование папок /example/folder-1/ или /example/folder-2/.

Как видно из примеров описанных выше, некорректное использование символов-джокеров может негативно сказаться на индексации сайта и привести к падению позиций.

Ошибка №2: Запрет сканирования скриптов и стилей

Одной из распространенных ошибок в файле robots.txt является блокировка скриптов и страниц стилей с помощью директивы Disallow:

Disallow: *.js

Disallow: *css

Хотя такой подход может быть применен для предотвращения индексации нежелательных ресурсов, это может оказаться вредным для SEO-продвижения вашего сайта. Блокировка скриптов и CSS-файлов может повлиять на корректное отображение и функционирование вашего сайта в поисковых результатах и для пользователей.

Если же вам нужна блокировка определенных JS-скриптов или CSS-файлов, вставьте исключение с помощью директивы Allow, которое даст поисковым роботам доступ только к нужным материалам.

Ошибка № 3. Не указана ссылка на файл sitemap.xml

Файл sitemap.xml дает роботам информацию о структуре сайта и его главных страницах. Данный файл оказывает значительное влияние на процесс индексации сайта. Поэтому важно указывать путь к XML-карте сайта в robots.txt. Важность директивы Sitemap в robots.txt можно понять в том числе потому, что поисковые роботы Google сканируют ее в первую очередь.

Директива Sitemap выглядит так:

Sitemap: https://site.ru/sitemap.xml

Если вы хотите улучшить процесс индексирования сайта, обязательно дополните файл robots.txt директивой Sitemap.

Ошибка № 4. Противоречивые директивы Allow и Disallow

Частой ошибкой в настройке robots.txt является указание противоречивых директив, сначала разрешающих сканирование папки или страницы, а затем запрещающих.

Как проверять корректность работы robots.txt

Для проверки корректности работы robots.txt файлов можно воспользоваться сервисами, такими как:

- Google Search Console,

- Yandex.Webmaster.

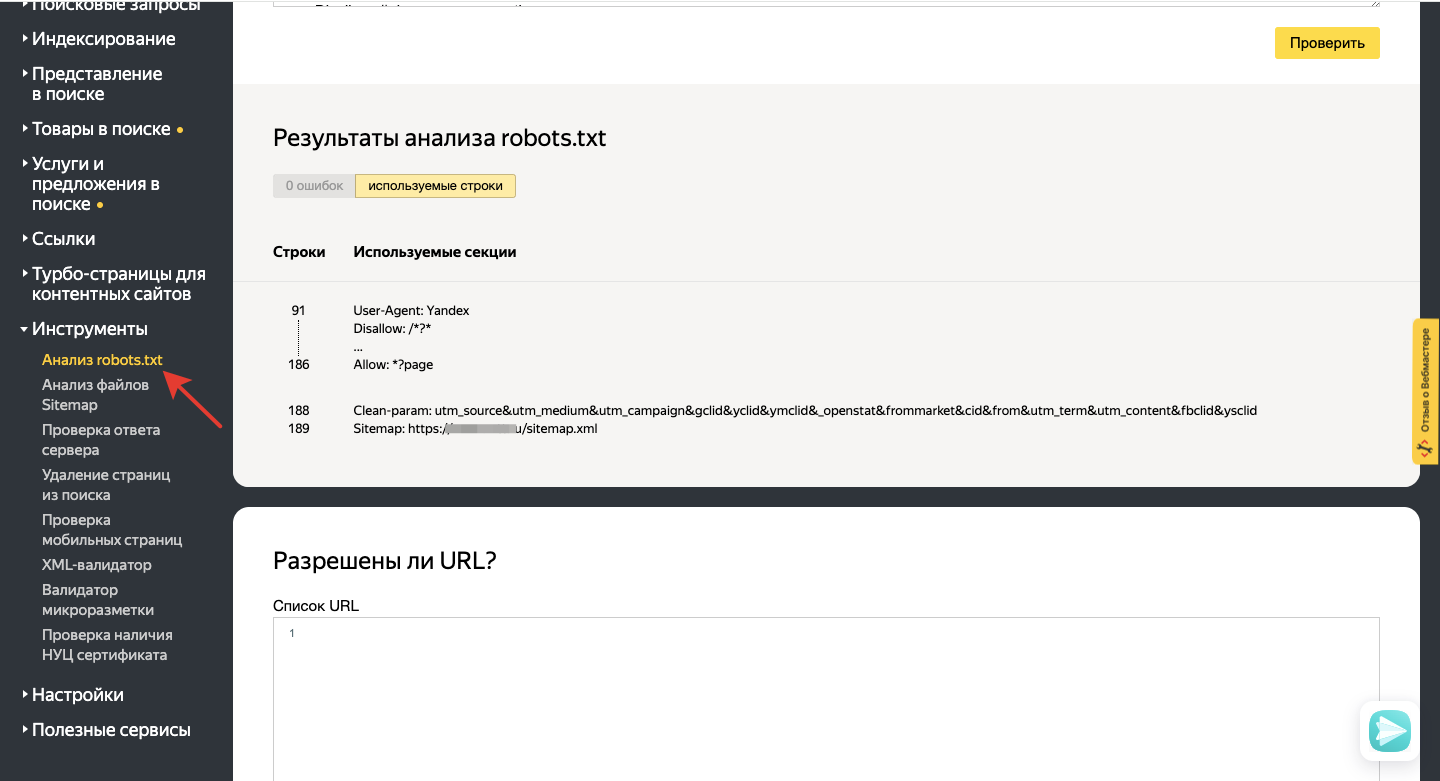

В Яндекс Вебмастере функционал проверки robots.txt находится на вкладке «Инструменты»:

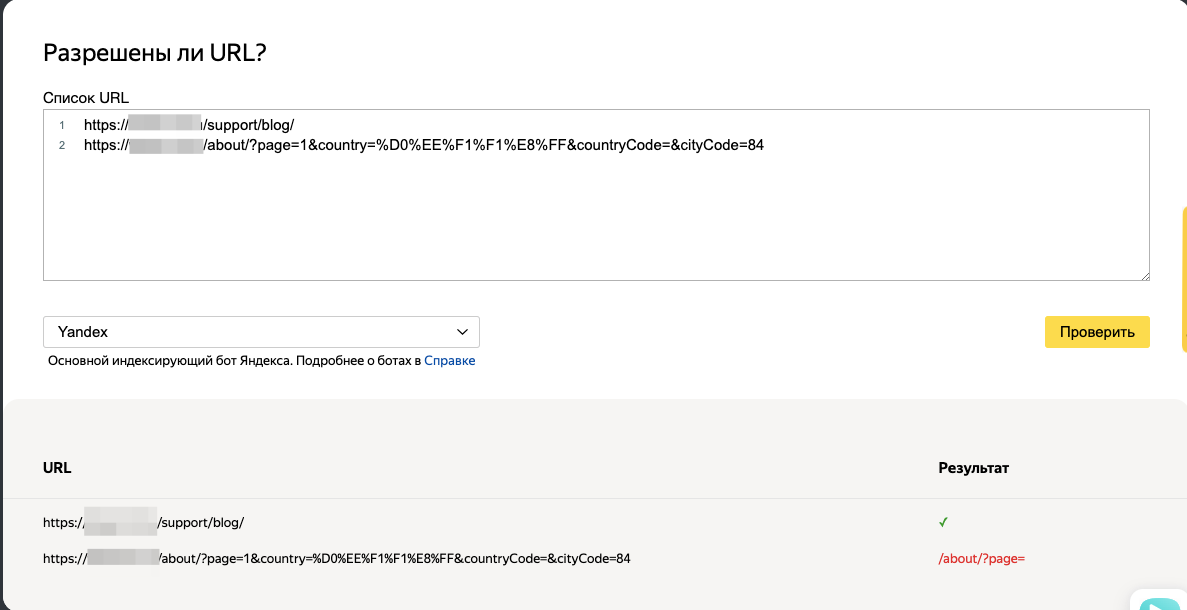

В поле «Разрешены ли URL?» вбиваете URL-адрес, который хотите проверить на возможность или запрет индексации, и смотрите статус.

В Google Search Console нет подобного инструмента, как в Яндекс Вебмастере, чтобы проверить возможность сканирования нескольких страниц.

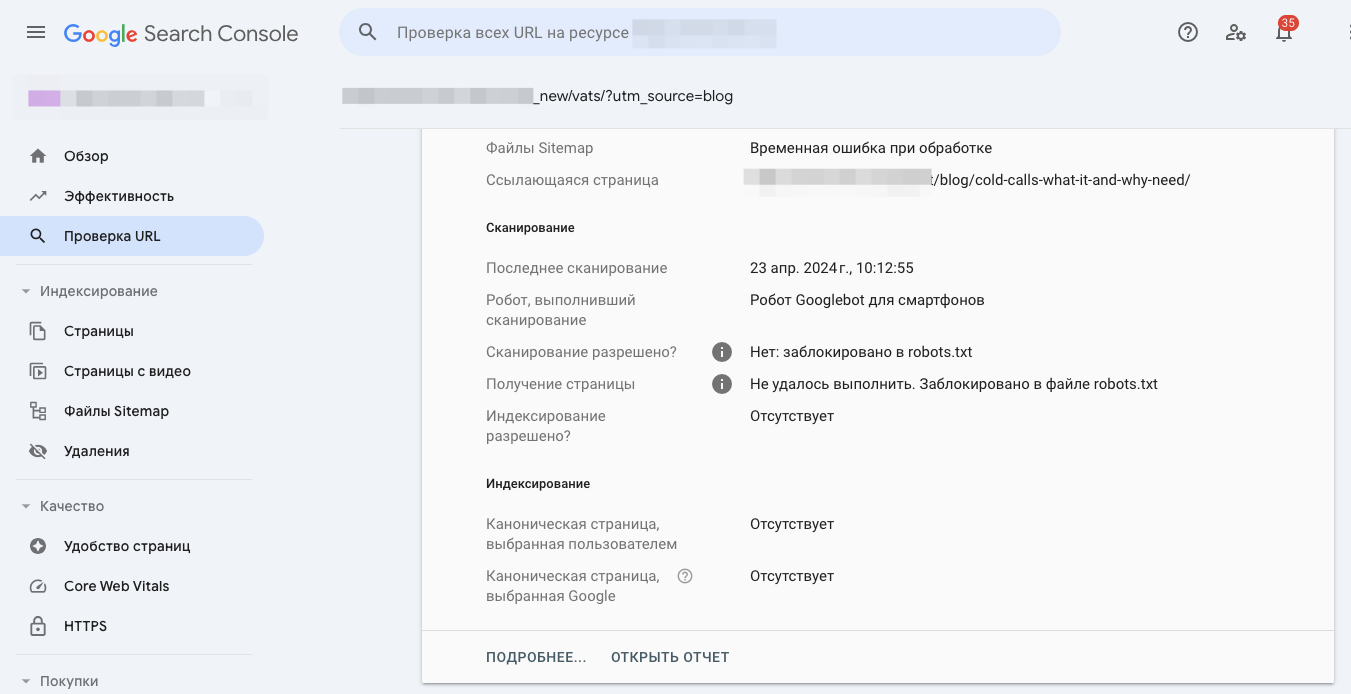

Для проверки разрешения на индексирование страницы вбивается URL-адрес в поле «Проверка всех URL..»:

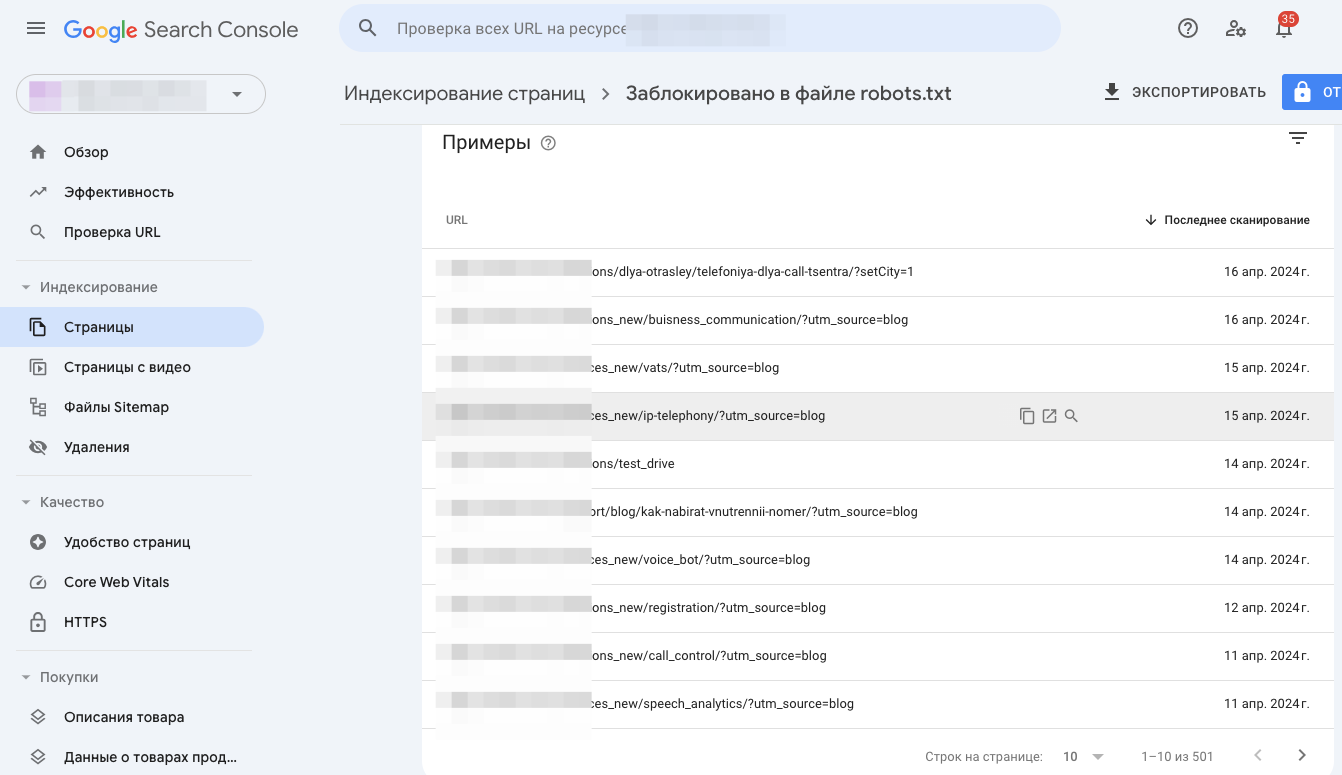

Но зато в Google Search Console в разделе «Индексирование страниц» есть функционал «Заблокировано в файле robots.txt», где можно посмотреть страницы, которые не попали в индекс из-за запрета в robots.txt.

Помните, что индексация сайта – это процесс, который может негативно сказаться на позициях сайта, а настройка robots.txt является фундаментом настройки индексации. Чтобы ваш сайт не только индексировался, но и занимал топ-10 в поисковой выдаче, обращайтесь в маркетинговое агентство для бизнеса «СЕО-Импульс»!

Теги:

Теги: