Google: не используйте robots.txt, чтобы заблокировать индексацию URL с параметрами

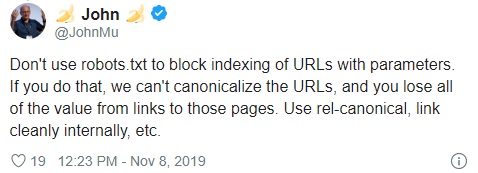

Сотрудник Google Джон Мюллер сообщил, что не нужно «использовать robots.txt, чтобы заблокировать индексацию URL с параметрами». По его словам, такой способ блокировки не позволит Google каноникализировать URL, и приведет к тому, что «вы потеряете всю ценность от ссылок на эти страницы».

Вместо robots.txt Джон Мюллер рекомендует к таких случаях использовать rel=canonical, размещение внутренних ссылок и т.п.

Он добавил, что блокировка URL с параметрами с помощью robots.txt не даст Google увидеть rel=canonical. Поисковик будет обрабатывать URL, заблокированные robots.txt, так же, как и другие роботизированные страницы. В результате Google не будет знать, что находится на этой странице, а, значит, может проиндексировать URL без содержимого.

Напомним, ранее Джон Мюллер сообщал, что ранжирование файлов robots.txt или sitemap по обычным запросам является признаком плохого сайта.

Источник: Seroundtable

Теги:

Теги: