20 Февраля 2018 в 15:38

Google: rel=canonical – более значимый сигнал, чем канонические страницы в Sitemap

3

8716

Google обновил справочный документ, который посвящен консолидации повторяющихся URL. Теперь в нем содержится информация о том, как поисковая система расценивает различные виды каноникализации страниц.

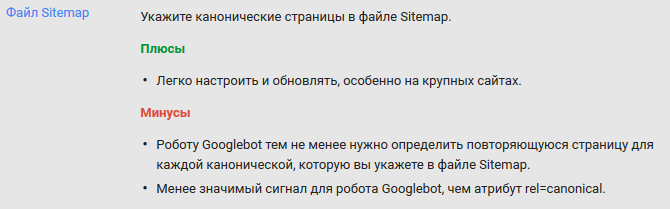

Теперь Google официально подтвердил, что канонические страницы в файлах Sitemap для Googlebot считаются менее сильным сигналом, чем атрибут rel=canonical.

Дженнифер Слэгг из The SEM Post объяснила, почему канонические страницы, указанные в файле Sitemap являются более слабым сигналом. Причины следующие:

- Многие генераторы файлов Sitemap, используемые сайтами, по умолчанию включают в карту каждый URL на сайте, даже в том случае, если отдельные страницы содержат атрибут rel=canonical.

- Некоторые вебмастера не обновляют файл Sitemap так же часто, как свои сайты. Это приводит к тому, что в них могут содержаться устаревшие данные.

- Даже если файл Sitemap сделан правильно, Googlebot все равно должен будет определить повторяющуюся страницу для каждой канонической, которая будет в нем указана. Этот процесс не всегда проходит гладко.

Google советует использовать атрибут rel=canonical для каноникализации страниц.

Источник: The SEM Post

Теги:

Теги: