OpenAI представила новую AI-модель GPT-4

Компания OpenAI представила новую AI-модель GPT-4. Модель уже доступна пользователям OpenAI через ChatGPT Plus, разработчики могут записаться в лист ожидания для доступа к API.

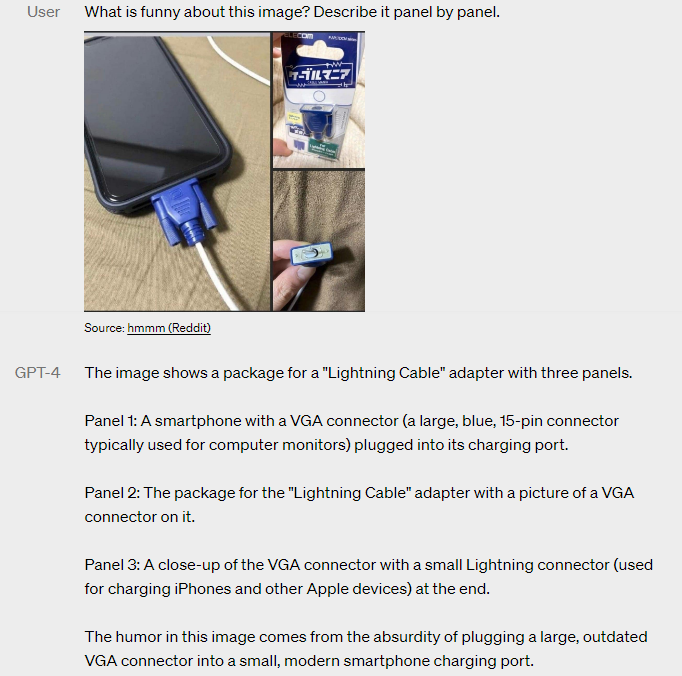

Главное отличие GPT-4 от предыдущей версии – она основана на мультимодальных моделях и может работать с медиаконтентом. Например, GPT-4 может использовать изображения в качестве вводных данных и комбинировать их с текстом. Нейросеть понимает, что изображено на фотографиях, рисунках и схемах при решении задачи, может объяснять данные, представленные в виде диаграмм. Пример ответа GPT-4: пользователь просит нейросеть рассказать, что смешного на картинке, и GPT-4 дает пошаговое объяснение.

Тем не менее нейросеть GPT-4 не идеальна и может ошибаться в своих ответах, выдавая несуществующие факты, но по сравнению с GPT-3.5 более креативна и дает на 40% более точные ответы. Также разработчики на 82% уменьшили склонность нейросети к запрещенному контенту.

Источник: OpenAI

Теги:

Теги: