17 Августа 2007 в 02:34

Robots.txt меняются к лучшему

0

2837

Google Webmaster Central Blog о внесении изменений в работу инструмента, анализирующего файлы robots.txt . Благодаря обновлению функционала, теперь распознаются все форматы карт сайта и соответствующие URL`ы. Инструмент будет проверять состояние URL`а карты сайта и представлять данные о соответствующих URL`ах.

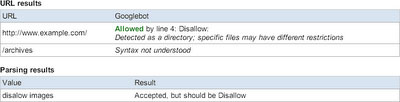

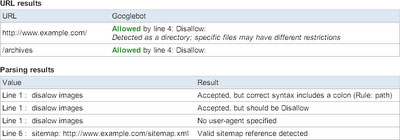

В дополнение, появилась функция, которая позволяет запретить индексацию картинок сайта, бот проиндексирует весь сайт, кроме папки с изображениями. Помимо этого, Google расширил предоставляемую отчетность, теперь она включает данные о всех случавшихся проблемах, а не о первой, как было раньше.

Так выглядела отчетность раньше.

Так выглядела отчетность раньше.

Так она выглядит теперь.

Так она выглядит теперь.

Напомним, некоторое время назад Google внес изменения в стандарте REP (Robots Exclusion Protocol), протоколе исключения роботов, используемый файлами Robots.txt для googlebot. Были представлены новые META-теги роботов: unavailable_after и X-Robots-Tag, сообщается в официальном блоге компании.

Теги:

Теги: