10 Июня 2016 в 15:05

Яндекс рассказал об изменениях в обработке robots.txt

0

6275

Поисковые роботы Яндекса перестали учитывать пустую директиву Allow как запрещающий сигнал в robots.txt.

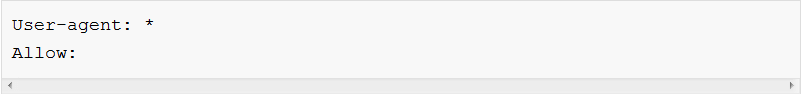

Часто встречающаяся ситуация – когда индексирующий робот не может получить доступ к сайтам из-за установленного по ошибке в robots.txt запрета на посещение всех страниц. Эти ошибки могут быть связаны с использованием пустой директивы Allow:

Раньше робот интерпретировал это правило как полностью запрещающее, и это делало сайт недоступным для визита роботов. Когда же владельцы сайтов намеренно хотели запретить посещение сайтов, они обычно четко прописывали команду запрета.

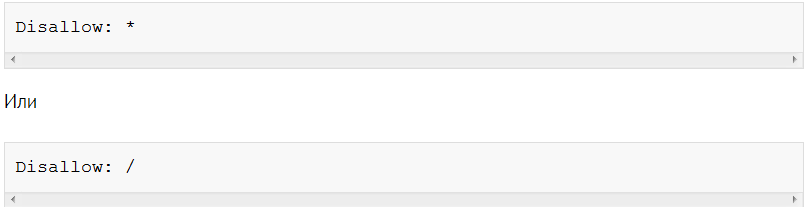

Поэтому команда Яндекса решила изменить обработку роботом такой директивы - сейчас она игнорируется при обнаружении в robots.txt. Если на сайте намеренно используются пустое правило Allow в robots.txt, то для того, чтобы робот корректно учитывал запрет, правило нужно изменить на директиву Disallow:

Проверить, что разрешено, а что – нет, можно в Яндекс.Вебмастере. Особое внимание следует обратить на то, чтобы отсутствовали пустые значения, целью которых является запрет на индексирование.

Источник:

Теги:

Теги: