Компания «Ашманов и партнеры» проводит две ежегодные конференции: в декабре проходит Optimization для специалистов по SEO и руководителей отделов интернет-маркетинга, а в марте — eTarget для специалистов по маркетингу, бренд-менеджеров и директоров департаментов рекламы, маркетинга и PR.

Традиционно на мероприятиях компания разыгрывает поисковый аудит, выдержки из которого публикуются на SEOnews. В прошлом году был опубликован SEO-аудит сайта сети центров дополнительного образования — вы можете прочитать первую и вторую часть кейса.

На декабрьской конференции Optimization 2016 организаторы разыграли среди участников мероприятия поисковый аудит. В этом году приз достался производственно-строительной организации «ГлавФундамент», которая занимается производством винтовых свай, проектированием и строительством фундаментов.

Полный аудит занимает 155 страниц, поэтому с читателями SEOnews мы также, как и в прошлый раз, поделимся сокращенной версией, разделенной на две статьи.

В первой части аудита мы публикуем рекомендации по улучшению индексации сайта поисковыми системами. В следующем выпуске выйдут рекомендации по текстовой коррекции страниц и улучшению эргономики сайта.

Семантическое ядро, которое было создано для проведения поискового аудита проекта, состоит сейчас из 924 релевантных бизнесу запросов общей популярностью по Москве в 18 521 обращение в месяц (декабрь 2016, по данным SeoRate.ru). Из этих запросов:

- в ТОП-10 Яндекса по Москве сайт уже сейчас находится по 209 запросам;

- в ТОПе поисковой системы Google по Москве – по 258 запросам.

На момент проведения измерений к аудиту число эффективных показов сайта http://glavfundament.ru/ по данным www.SeoRate.ru составило 953 показа в месяц. Видимость сайта по совокупности поисковых систем пока равна 5,19%. В целом это не слишком хороший результат, учитывая, что общая видимость основных конкурентов составляет сейчас ~64% и ~36% соответственно.

Корректная индексация — первый этап работы над продвижением сайта, поэтому данная стадия является базисом для дальнейшей эффективной работы по поисковому продвижению. Приведенные рекомендации следует внедрить в первую очередь. Для удобства владельца сайта и читателей SEOnews мы расположили их в том порядке, в котором их необходимо реализовать.

Обеспечение стабильного доступа к сайту

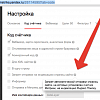

За последний год было зафиксировано несколько продолжительных сбоев в работе сайта, на что указывают данные мониторинга в Яндекс.Метрике.

Скриншот из отчета системы:

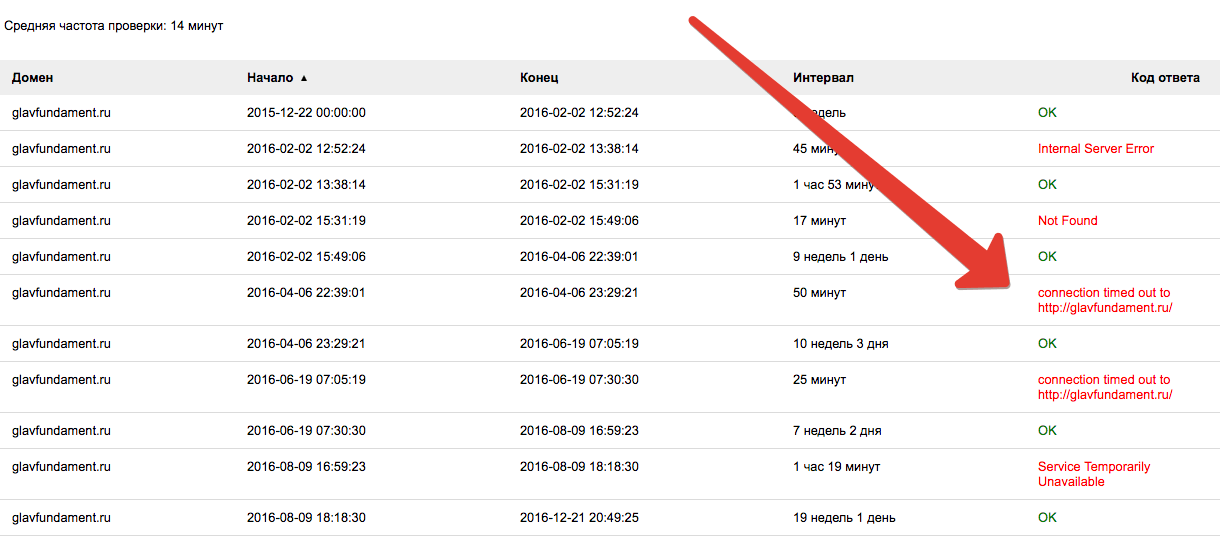

Также проблема обнаруживается при ручном сканировании страниц сайта в несколько потоков при неравномерной нагрузке по количеству запрашиваемых страниц, имитирующей реальных пользователей. Это видно на иллюстрации ниже:

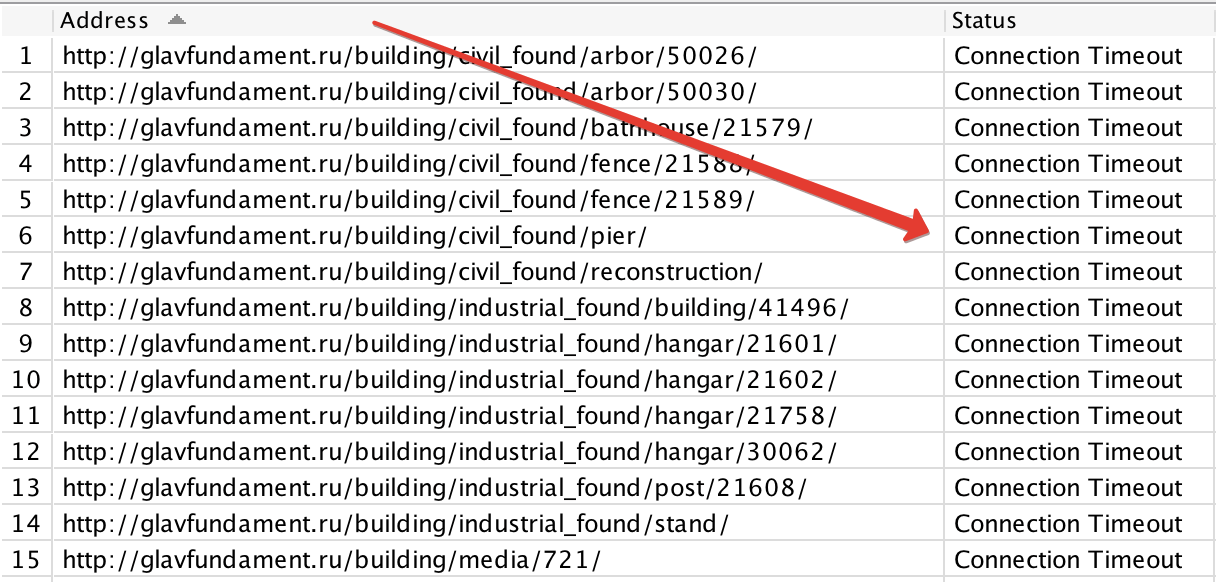

Настройка корректной передачи ошибки 404

Сейчас механизм передачи кода 404 чаще всего не срабатывает: этот код не передается при обращении к несуществующим страницам сайта, например, этим (цветом выделены модифицированные участки URL – в таком виде их нет на сайте, то есть это несуществующие адреса):

http://glavfundament.ru/proect/proect_news/18386/1255/1112/

http://glavfundament.ru/contacts/naberezhnye-chelny/GET404

http://glavfundament.ru/building/civil_found/pier/21594/999

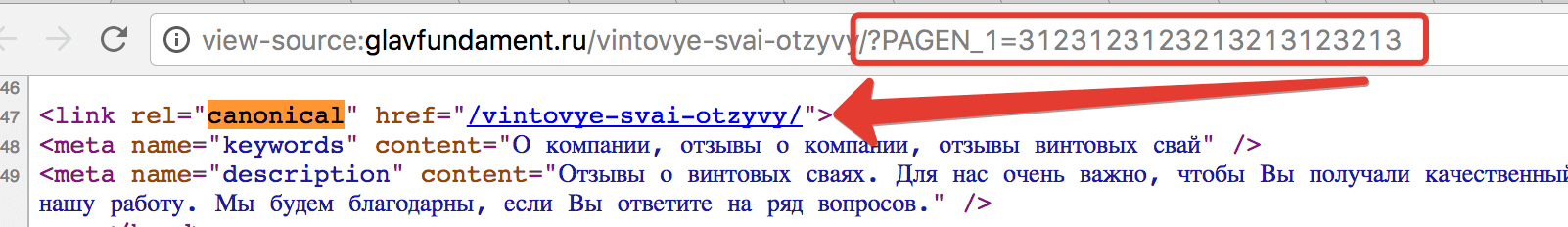

http://glavfundament.ru/vintovye-svai-otzyvy/?PAGEN_1=3123123123213213123213

http://glavfundament.ru/?login&admin

Ответы сервера:

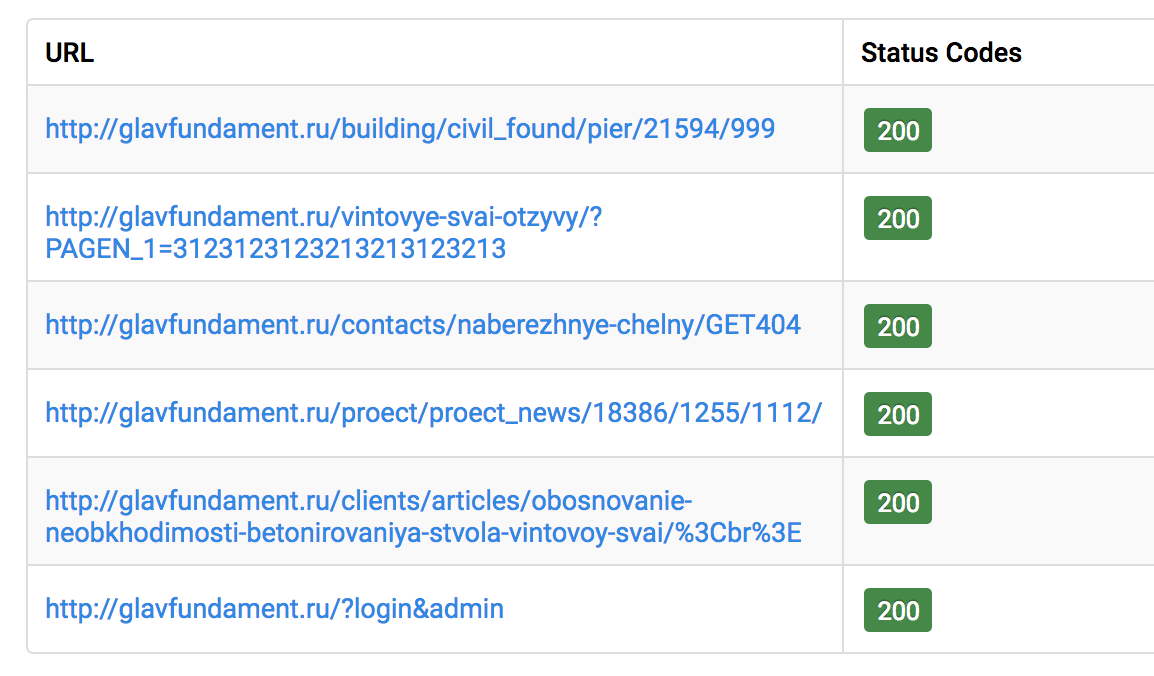

Сейчас все описанные выше несуществующие страницы передают в итоге код ответа 200 (OK), вместо 404 (не существует) или 410 (удалено навсегда), что может привести к нарушению индексации сайта, даже несмотря на наличие канонических страниц, указываемых в коде несуществующих страниц и ведущих на тот уровень вложенности, где расположен действующий URL. Например:

Рекомендуется внести в программное обеспечение сайта необходимые изменения, чтобы в случае обращения к несуществующим страницам или страницам с адресами, указанными с подобными ошибками сервер отвечал корректно, кодом 404 (не существует) или 410 (документ удален навсегда), без перенаправлений.

При этом в случае служебных страниц, например, http://glavfundament.ru/bitrix/admin/#authorize, которая явно не нуждается в представлении в поиске, содержимое можно отображать любое: для пользователя такие страницы будут работать как обычно, но при этом код ответа в http-заголовке таких страниц будет говорить о том, что их не существует – 404 или 410. Это не только обеспечит чистоту индекса, но и улучшит показатель безопасности сайта, так как любое программное обеспечение, направленное на разведку сайта, не сможет скачать данные со страниц, передающих указанные коды.

Устранение угрозы дублирования страниц сайта и нейтрализация некачественных страниц, не предназначенных для представления в поиске

Чтобы нормализовать индексацию сайта и оптимизировать его ранжирование, требуется выполнить приведенные далее рекомендации по нейтрализации угрозы дублей и некачественных страниц.

Оптимизация файла robots.txt

Данный файл позволяет определить для поисковых систем основной адрес сайта, а также обеспечивает корректную индексацию важных страниц с помощью указания адреса карты сайта. В файле robots.txt возможно указать задержку в индексации при чрезмерной нагрузке на сайт со стороны поисковых роботов. Помимо этого он используется для указания страниц и рубрик сайта, индексировать которые не следует – они будут удалены из выдачи.

Сейчас файл расположен по адресу http://glavfundament.ru/robots.txt. Некоторые директивы являются излишними, поскольку закрывают от индексирования страницы, которые в текущем представлении сайта не нуждаются в дополнительной настройке для сканирования.

1. Указания на разрешение сканирования ресурсов .js и .css – данные файлы расположены во внешнем хранилище (CDN: http://glavfundament.ru.js.1c-bitrix-cdn.ru/), к которому не применяются правила локального файла Robots.txt

Allow: /bitrix/templates/glavfundament/*.css

Allow: /bitrix/templates/glavfundament/js/

Allow: /bitrix/templates/glavfundament/css/

Allow: /bitrix/templates/glavfundament/img/

Allow: /bitrix/templates/glavfundament/fonts/

Allow: /bitrix/templates/main_template/*.css

Allow: /bitrix/templates/main_template/js/

Allow: /bitrix/templates/main_template/css/

Allow: /bitrix/templates/main_template/img/

Allow: /bitrix/templates/main_template/fonts/

Allow: /bitrix/cache/css/

Allow: /bitrix/cache/js/

Allow: /bitrix/css/

Allow: /bitrix/js/

2. Директива Allow: /bitrix/images/ также является лишней, так как сканирование по данному адресу не запрещено никакими прочими правилами.

3. Набор директив ниже не является необходимым для данного сайта, так как в его адресной структуре отсутствуют ссылки на указанные в правилах каталоги.

Disallow: /bitrix/

Disallow: /scripts/

Disallow: /_auth/

4. Директивы, запрещающие индексирование страниц с определенными параметрами, также могут быть отброшены, так как в данное время в ссылочной структуре сайта отсутствуют страницы, в которых используются указанные в правилах фрагменты URL.

Disallow: *SORT=*

Disallow: *VIEW_MODE=*

...

Disallow: *clear_cache=*

Disallow: *undefined

Disallow: *start_frame_cache_email-href

5. Прочие директивы, запрещающие сканирование в определенных каталогах.

Disallow: /mainpagetest/

Disallow: /price/various_types_svai/test

Disallow: /coupon/

Disallow: /testing/

Disallow: /project_house/

Вероятно, тестовые страницы, которые в данное время транслируют код ответа 404, и не нуждаются в дополнительной настройке индексации.

Также отметим, что поиск Google может игнорировать директивы файла robots.txt в случае, если на закрытую от индексации страницу ведут внешние ссылки. Поэтому все тестовые работы рекомендуется проводить на отдельном адресе, защищенном от сканирования путем паролирования директории.

...

Disallow: /price/41/

Disallow: /price/42/

Disallow: /price/43/

Disallow: /price/44/

Disallow: /price/45/

Disallow: /price/calct_test_page4

Disallow: /price/index-test

Указанные в директивах страницы отсутствуют в ссылочной структуре сайта, хотя при обращении к ним транслируется код 200. После настройки корректной работы механизма передачи ошибки 404 данные URL должны будут отдавать код 404 и также перестанут нуждаться в упоминании внутри robots.txt, так что их можно будет удалить из файла.

Дополнительно, независимо от настройки ошибки 404, из файла robots.txt необходимо удалить правило:

Disallow: /building/project_house/

На эту страницу будут продвигаться запросы, связанные с готовыми домами на свайном фундаменте.

Ниже представлен конечный файл robots.txt после удаления избыточных правил: им можно заменить существующий robots.txt после окончания настройки работы механизма передачи ошибки 404:

User-Agent: *

Disallow: /search/

Disallow: /go/

Disallow: /register

Disallow: /clients/reminder_client #страницы нет в структуре, если вы не используете эту страницу рекомендуется настроить код 404 или 410 при обращении к адресу, а затем удалить директиву из Robots.txt

Disallow: /learning/

Disallow: /proect/znat #страницы нет в структуре, если вы не используете эту страницу рекомендуется настроить код 404 или 410 при обращении к адресу, а затем удалить директиву из robots.txt

Disallow: /forum/ #страницы нет в структуре, если вы не используете эту страницу рекомендуется настроить код 404 или 410 при обращении к адресу, а затем удалить директиву из robots.txt

Disallow: /club/ #страницы нет в структуре, если вы не используете эту страницу рекомендуется настроить код 404 или 410 при обращении к адресу, а затем удалить директиву из robots.txt

Disallow: /press-center/company_news/

Disallow: /press-center/exhibition/

Disallow: *PAGEN_1=*

User-Agent: Yandex

Disallow: /search/

Disallow: /go/

Disallow: /register

Disallow: /clients/reminder_client

Disallow: /learning/

Disallow: /proect/znat

Disallow: /forum/

Disallow: /club/

Disallow: /press-center/company_news/

Disallow: /press-center/exhibition/

Disallow: *PAGEN_1=*

Sitemap: http://glavfundament.ru/sitemap.xml

Host: glavfundament.ru

При следующем обходе поисковых роботов обсуждаемые страницы, в случае если они станут транслировать корректный код ответа (404 или 410), будут исключены из основного поискового индекса.

Кроме этого, для борьбы с избыточной индексацией рекомендуется установить запрет на сканирование страниц средствами Яндекс.Метрики.

Приведение адресов страниц к единообразному окончанию и настройка переадресации при обращении к URL без знака “/” в конце строки

Сейчас большая часть страниц в ссылочной структуре рассматриваемого сайта содержит в конце строки адреса знак “/”, например:

http:\/\/glavfundament\.ru\/clients\/typesvai\/1214\/

http:\/\/glavfundament\.ru\/clients\/treaties\/21225\/

http:\/\/glavfundament\.ru\/clients\/articles\/vintovye-svai-s-litym-nakonechnikom\/

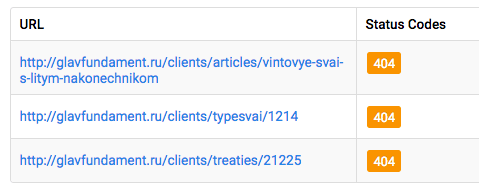

При этом если знак «/» будет пропущен в результате ошибки во внутренней или внешней ссылке на сайт, страницы ответят кодом 404:

В то же время в некоторых других URL знак “/” в конце пропущен, например, здесь:

http:\/\/glavfundament\.ru\/press-center\/events

http:\/\/glavfundament\.ru\/produce\/technology\/otech

http:\/\/glavfundament\.ru\/building\/building_stages\/threading

Если ссылки на эти страницы будут указаны с ошибкой (добавлением знака “/”), то две из трех страниц передадут код ответа 404. Такого адреса нет, что формально верно, однако может существенно снизить полноту и скорость индексации ресурса, так как внешние ссылки на сайт могут содержать большое количество ошибок в окончании URL страниц.

Требуется внести в ссылочную структуру сайта необходимые изменения, чтобы:

1. Все HTML-страницы сайта имели постоянный единственный верный адрес со знаком “/” в конце строки.

2. Программное обеспечение сайта было настроено на передачу кода 301 и серверного перенаправления при обращении к URL без знака “/” в конце строки на URL по умолчанию, то есть со знаком “/” в конце строки, как это показано выше.

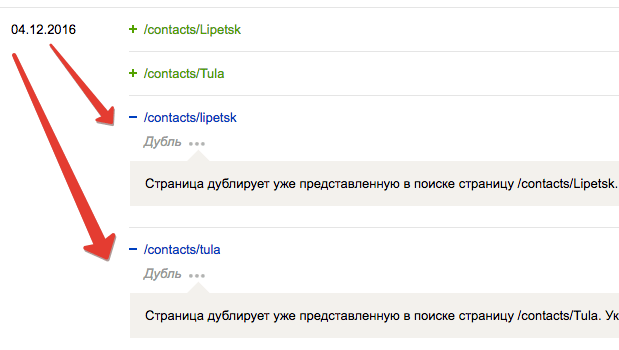

Коррекция поведения сервера при обращении к адресам страниц, выполненных в верхнем регистре

Сейчас большинство страниц в ссылочной структуре рассматриваемого сайта имеют URL адреса, выполненные в нижнем регистре, например:

http:\/\/glavfundament\.ru\/building\/civil_found\/house\/59868\/

http:\/\/glavfundament\.ru\/building\/industrial_found\/hangar\/48992\/

http:\/\/glavfundament\.ru\/building\/civil_found\/pier\/21531\/

Все эти адреса включены в ссылочную структуру сайта и передают код ответа с сервера 200 (ОК), что позволяет поисковым системам сканировать их и представлять в выдаче.

Однако в адресном поле сайта также встречаются URL, содержащие символы в верхнем регистре. И если перевести эти же URL в общепринятый нижний регистр, то две из трех указанных выше страниц снова будут доступны для сканирования и представления в выдаче, но условно по новому адресу. Коды ответов сервера:

Таким образом на этапе сканирования сайта поиск Яндекса фиксирует проблему дублирования страниц, что может привести к снижению эффективности поискового продвижения сайта.

Чтобы решить эту проблему, рекомендуется перевести все адреса страниц в ссылочной структуре сайта к одному виду: представлять их в классическом, нижнем регистре.

После того как все адреса будут приведены к единообразному виду (всегда в нижнем регистре), потребуется настроить правила для организации постоянных серверных редиректов с кодом ответа 301 для всех страниц, к которым обратились с ошибкой в адресе (в наше случае это HTML-страницы со знаками в верхнем регистре в URL).

Устранение угрозы дублей со стороны копий сайта, расположенных на других адресах

Для того чтобы копии http://glavfundament.ru/, расположенные сейчас по адресам:

http://static.243.202.76.144.clients.your-server.de./

http://static.243.202.76.144.clients.your-server.de/

не помешали поисковому продвижению основного выбранного сайта, необходимо сообщить поисковым системам, что данные адреса являются синонимами адреса http://glavfundament.ru/. Для этого потребуется сделать следующее:

Для поиска Яндекса нужно обеспечить по адресам сайтов-копий (http://static.243.202.76.144.clients.your-server.de./robots.txt; http://static.243.202.76.144.clients.your-server.de/robots.txt; http://144.76.202.243/robots.txt) наличие точной копии файла инструкций robots.txt расположенного по адресу http://glavfundament.ru/robots.txt.

Для поиска Google необходимо канонизировать все страницы сайтов-копий (http://static.243.202.76.144.clients.your-server.de./; http://static.243.202.76.144.clients.your-server.de/; http://144.76.202.243/) с их аналогами на http://glavfundament.ru/.

Таким образом, например, страница http://static.243.202.76.144.clients.your-server.de./ должна содержать тег с указанием на страницу http://glavfundament.ru/

link rel="canonical" href="http://glavfundament.ru/"

Подробнее про канонизацию можно прочитать: https:\/\/yandex\.ru\/support\/webmaster\/controlling-robot\/html\.xml#canonical и https://support.google.com/webmasters/answer/139066?hl=ru.

Коррекция XML-карты сайта

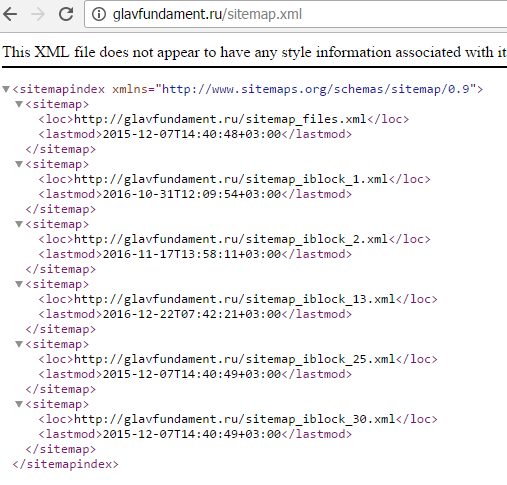

В данный момент на http://glavfundament.ru/ имеется XML-карта, индексный файл которой расположен по адресу http://glavfundament.ru/sitemap.xml.

Однако эта карта не является оптимальной.

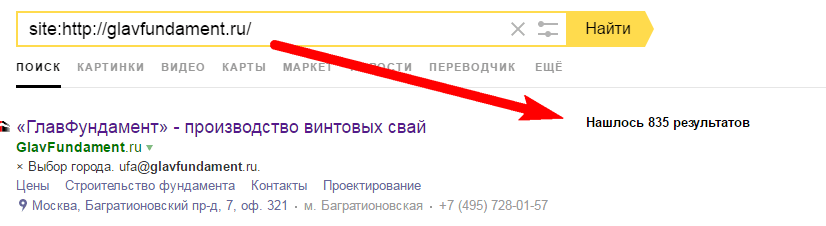

1. XML-карта разделена на 6 файлов, что осложняет контроль и анализ:

Нет никакой необходимости разделять на несколько файлов карту сайта, содержащего менее 50 тысяч адресов страниц. По данным сканирования, к аудиту сейчас на сайте http://glavfundament.ru/ расположено около ~450 ценных адресов страниц (~900, если считать документы *.pdf и *.doc/docx):

Чтобы можно было сравнить число и состав URL в карте сайта с имеющимися в поисковых выдачах, рекомендуется собрать карту в один XML-файл.

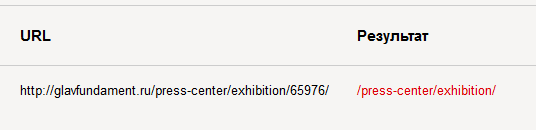

2. Текущая версия карты содержит записи, указывающие на страницы сайта с редиректами, например:

http:\/\/glavfundament\.ru\/building\/industrial_found\/building

http:\/\/glavfundament\.ru\/building\/civil_found\/reconstruction

http://glavfundament.ru/contacts

В карте:

Коды ответов с сервера:

Редиректы почти всегда негативно сказываются на показателях индексации, что может привести к снижению эффективности продвижения. Важно следить, чтобы в карте сайта не было ссылок на страницы с редиректами. Вместо них необходимо поместить конечные адреса перенаправляемых страниц.

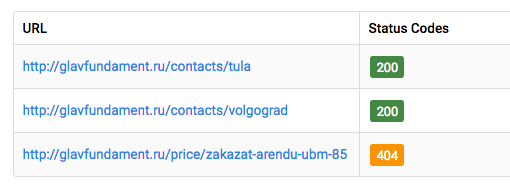

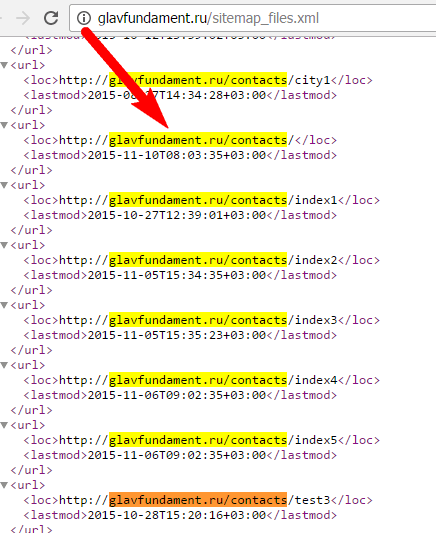

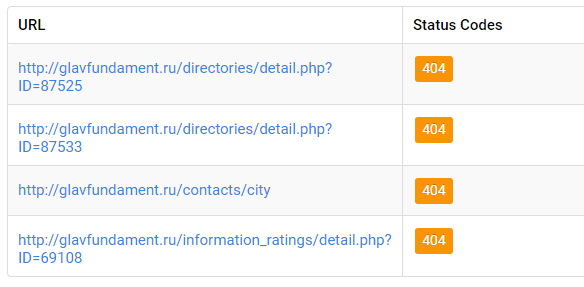

3. Карта содержит битые ссылки (с ошибкой 404), например:

http:\/\/glavfundament\.ru\/contacts\/city

http:\/\/glavfundament\.ru\/directories\/detail\.php?ID=87525

http:\/\/glavfundament\.ru\/directories\/detail\.php?ID=87525

http:\/\/glavfundament\.ru\/information_ratings\/detail\.php?ID=69108

В карте:

Коды ответов сервера:

Страницы 404 также снижают параметры индексации. Если число таких страниц становится значительным, автоматические алгоритмы поисковых систем могут сделать неверный вывод о том, что сейчас на сайте ведутся какие-то технические работы или он заброшен — в таком случае его позиции в выдаче будут понижены. Требуется следить за тем, чтобы карта сайта не содержала ссылок на страницы 404.

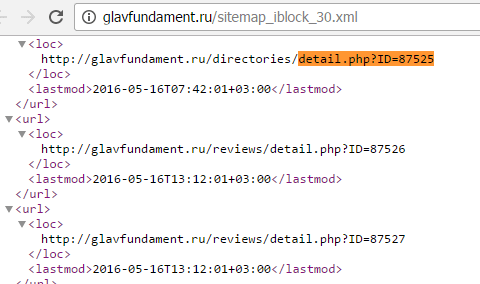

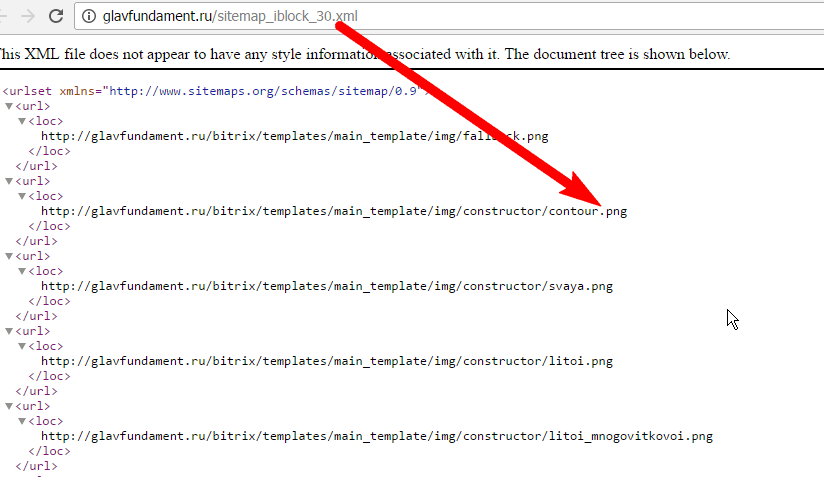

4. В файл карты http://glavfundament.ru/sitemap_iblock_30.xml включены ссылки на файлы изображений, но с нарушением правил синтаксиса разметки:

Как видно на рисунке выше, файлы изображений размечены в файле как обычные ссылки на страницы. Однако, согласно стандарту для графических файлов, в карте должен использоваться отдельный синтаксис разметки. Подробнее об этом читайте по ссылке https://support.google.com/webmasters/answer/178636?hl=ru.

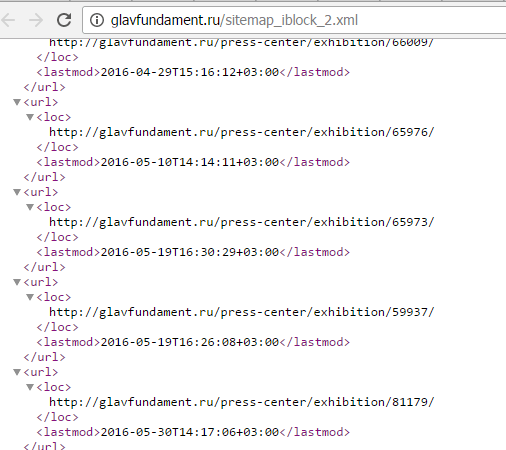

5. Файл http:\/\/glavfundament\.ru\/sitemap_iblock_2\.xml полностью состоит из ссылок на страницы, запрещенные к индексации через файл robots.txt.

В карте красный цвет означает закрытое для сканирования состояние URL.

Для достижения наиболее полной индексации сайта нужно исправить текущую XML-карту таким образом, чтоб она состояла из двух файлов: для указания адресов HTML-страниц и для указания адресов изображений с сайта.

Оба файла карты должны включать в свой состав регулярно обновляемые (например, с помощью php-скрипта, привязанного к задаче cron) записи обо всех ценных HTML-страницах сайта и изображениях с сайта, которые необходимо представить к индексации поисковыми роботами и которые по вашему мнению могут принести пользу посетителям поисковых систем.

Отметим, что XML-карта сайта не должна иметь в своем составе ссылки на:

- дубли страниц;

- служебные страницы или страницы, находящиеся «в разработке», в том числе тестовые;

- несуществующие страницы (404, 410);

- страницы с редиректами (30*);

- неканонические версии страницы;

- страницы с бессмысленно сгенерированным содержимым;

- страницы, запрещенные к индексации через файл инструкций robots.txt.

С примерами карты и дополнительной информацией об XML-формате можно ознакомиться по официальному адресу стандарта: http://www.sitemaps.org/ru/protocol.html.

Также о требуемом формате карты сайта можно узнать дополнительно на сайте Google по адресу: http://www.google.com/support/webmasters/bin/answer.py?hl=ru&answer=156184.

Дополнительные рекомендации

В этой статье мы рассмотрели наиболее критичные ошибки, обнаруженные на сайте. Их исправления необходимо внести в первую очередь. В статью не вошли некоторые рекомендации с пометкой «важно»:

- оптимизация дополнительной навигации сайта («хлебных крошек»);

- перевод домена на работу по защищенному протоколу HTTPS;

- оптимизация раздела «Контакты»;

- скорость сайта для персональных компьютеров и мобильных устройств;

- устранение редиректов и страниц 404 в структуре сайта;

- оптимизация кода;

- оптимизация файлов формата, отличного от HTML;

- оптимизация распределения ссылочного веса.

В следующей статье мы поделимся текстовыми рекомендациями, которые помогут обеспечить создаваемым страницам релевантность с поисковыми запросами из семантического ядра. Мы также представим результаты юзабилити-аудита, в ходе которого мы обнаружили наиболее значимые проблемы в эргономике сайта для пользователей.

Теги:

Теги: