SEO-специалист Александр Ожгибесов на онлайн-конференции «SEO без воды 2» рассказал о влиянии структуры сайта и семантики на SEO и контекстную рекламу в 2020 году.

Предлагаем посмотреть видеозапись этого выступления. Под видео вы найдете текстовую расшифровку доклада.

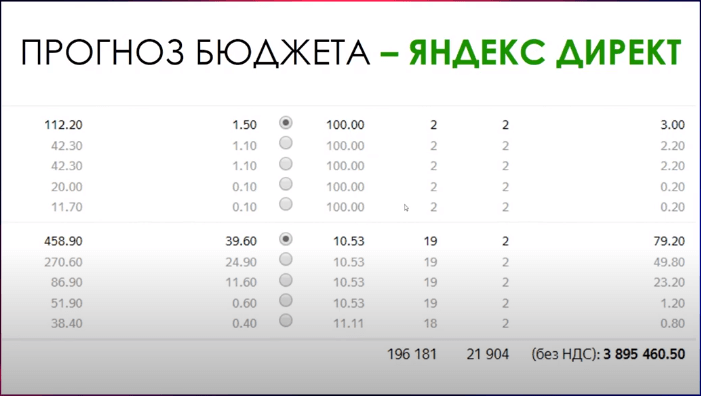

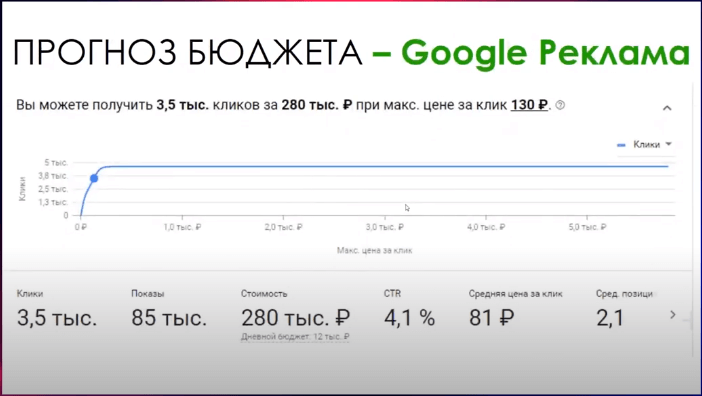

Семантика и структура влияют как на технические параметры, так и на стоимость бюджета. Чтобы определить, работать с SEO или с контекстной рекламой, необходимо подготовить семантику и оценить стоимость прогнозируемого результата.

Если вы уверены в успешности ниши, но нет семантического ядра и вы не знаете, как собрать его самостоятельно, можно посмотреть бесплатный курс. Если вы в нише не уверены, хотите протестировать, но не готовы тратить огромное количество времени и ресурсов, можно подсмотреть данные у конкурентов.

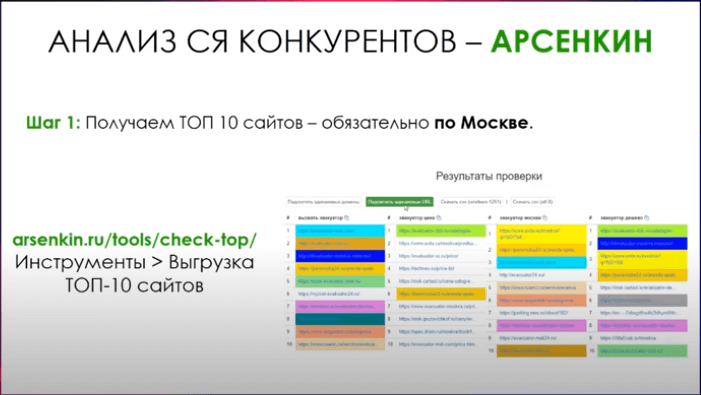

Нужно выбирать интересующие запросы (это маркерные запросы), самые популярные с точки зрения частотности. Взять поисковую выдачу (например, через https://arsenkin.ru/tools/) и собрать сайты.

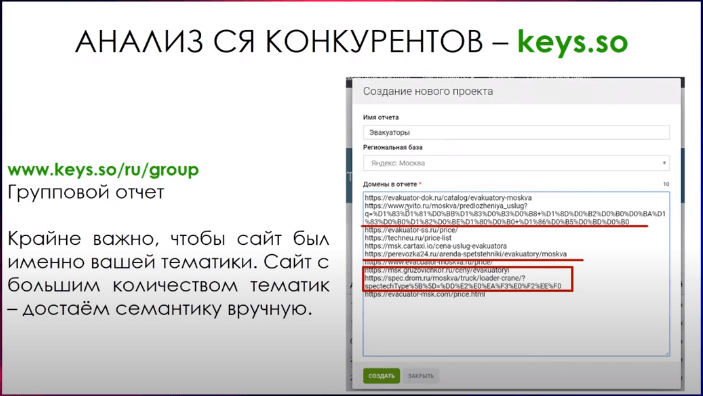

После этого зайти в групповой отчет keys.so и вставить запросы туда, чтобы собрать данные по семантике.

В нише эвакуаторов получилось почти 12 тысяч запросов. Если убрать запросы, которые встречаются менее трех раз (ключ встречается на трех сайтах) и ограничить частоту по Вордстату, то запросов станет меньше. Это позволит получить более или менее полную для использования семантику. Конечно, это не замена классического подбора семантического ядра, но для работы этого вполне достаточно.

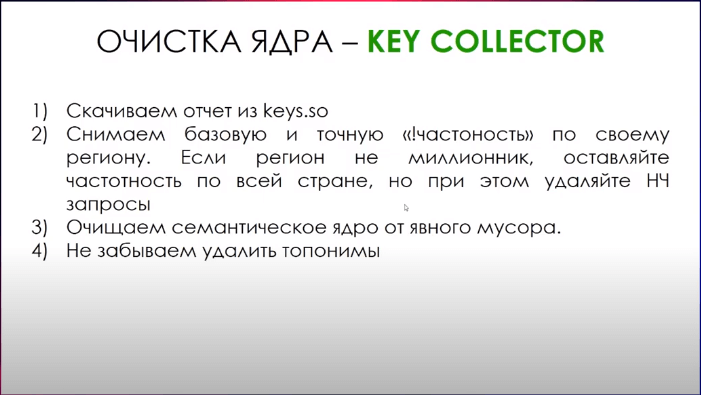

Дальше нужно забрать эти данные, снять необходимые частотности, очистить ядро от мусора (неявные дубли, топонимы и т.п.).

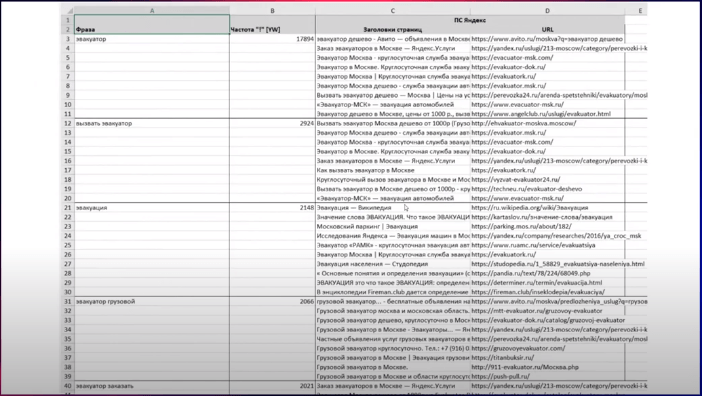

Затем необходимо собрать данные по поисковой выдаче. Лучше использовать Яндекс (много агрегаторов) или Google в зависимости от ниши.

После сбора данных результаты нужно импортировать в Key Collector, а затем в Excel, используя инструмент «Экспортирование». После экспорта будут доступны данные частотности, сниппеты, URL-ы.

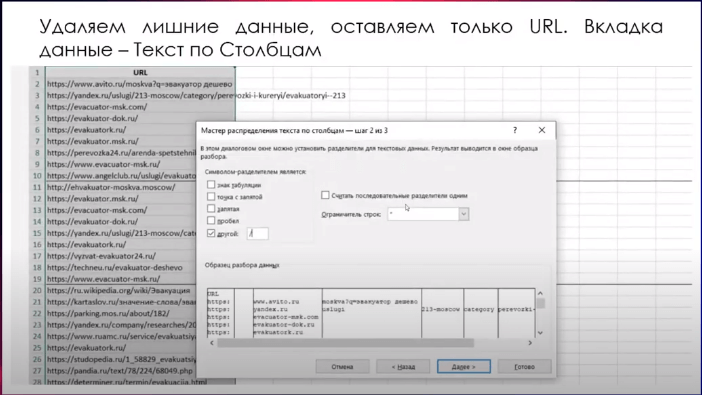

Из URL-ов нужно получить домены. Для этого достаточно воспользоваться распределением по столбцам (инструмент Excel), разделитель – это слеш (/).

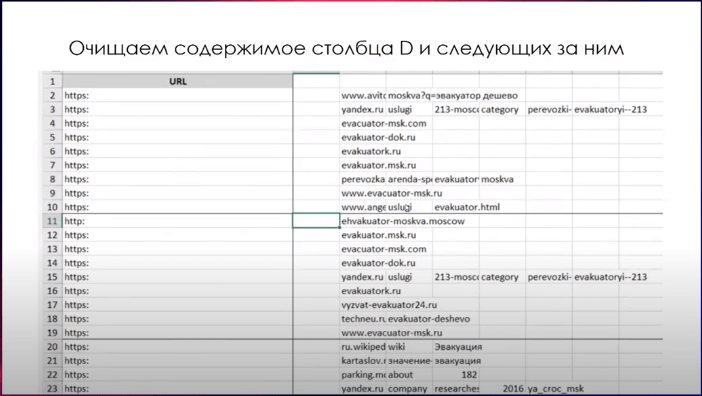

Получаем таблицу и убираем все, что не относится к домену.

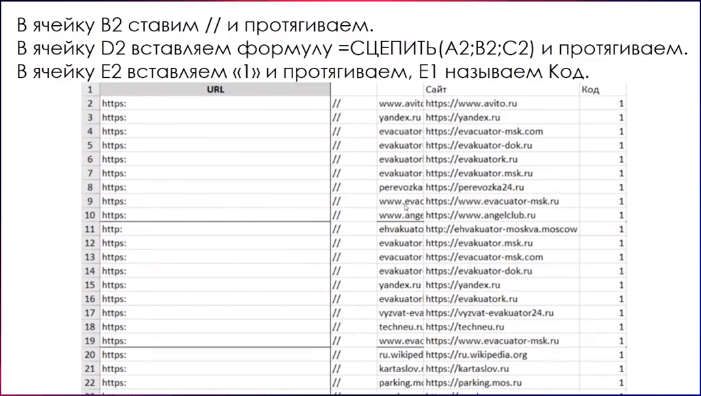

Простейшими действиями цепляем из протокола и названия сайта сам домен.

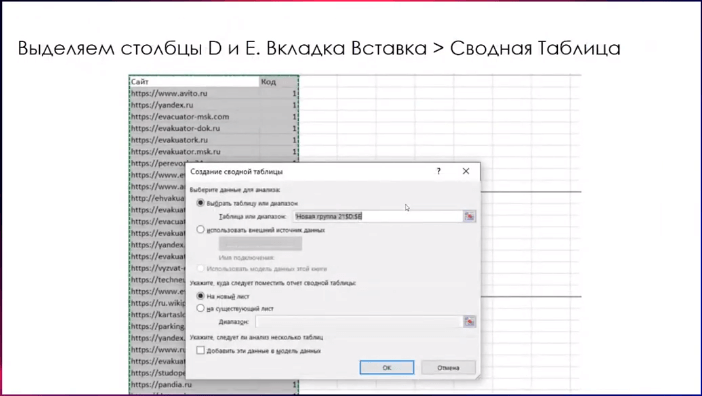

Проставляем код, чтобы построить сводную таблицу.

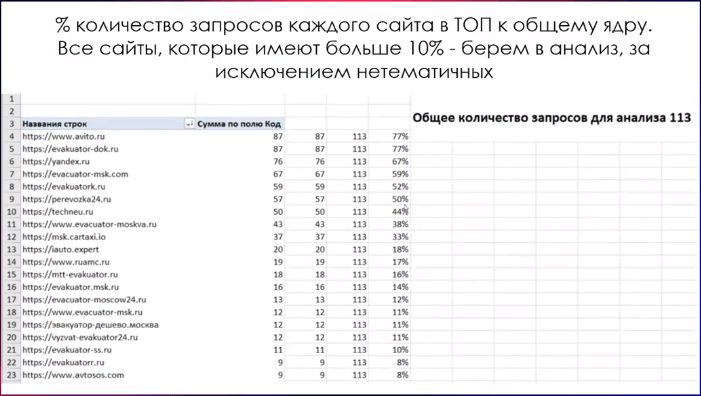

Выделяем все полученные данные и строим сводную таблицу. Получаем сайты, которые ранжируются. Убираем нетематические сайты, например, Яндекс.Услуги, которые не подходят для анализа.

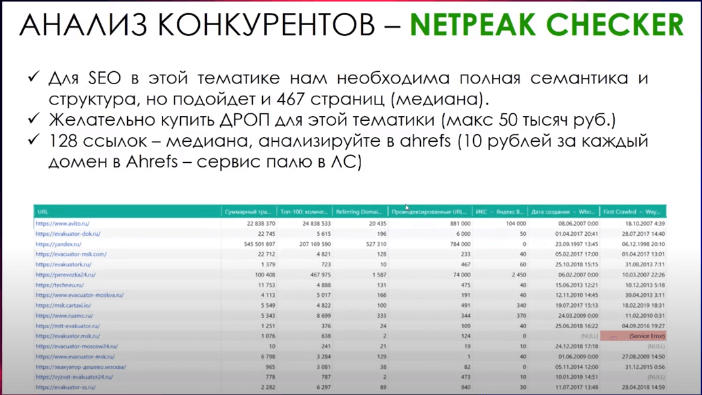

Затем необходимо проанализировать конкурентов, для этого можно использовать программу Netpeak Checker. Рассматривая выдачу по Москве, так как она – одна из самых конкурентных, получаем значение в 467 необходимых страниц в этой тематике (включая информационные).

Также можно использовать Checktrust, но на анализ необходимо будет выделить бюджет. Данные сервиса позволят понять, какое количество ссылочного используется в нише и нужно ли вам его использовать. Например, во многих нишах применяется текстовое ранжирование, ссылки не используются совсем.

Формирование цен в SEO

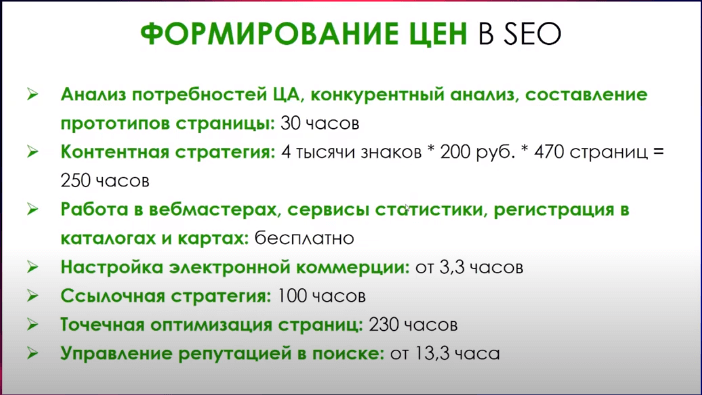

На основании данных, полученных в рамках анализа, формируем оценку.

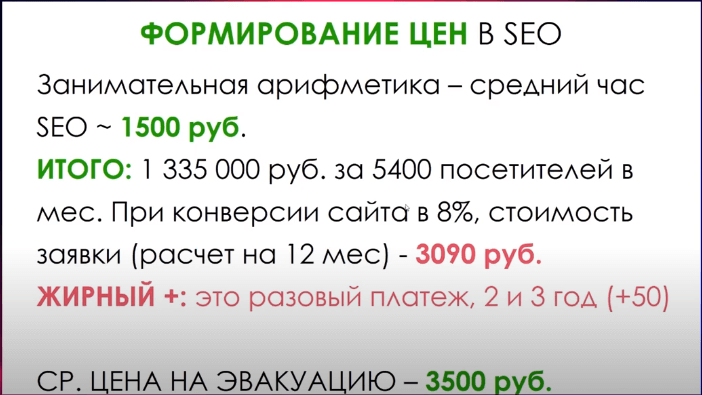

Учитывая, что стоимость часа в агентстве среднего типа составляет 1500 рублей, вы потратите больше 1 млн рублей. Если конверсия в услугах 8%, то стоимость заявки получается 3 000 рублей. Плюс в том, что это – разовый платеж. Средняя цена на эвакуацию на рынке – 3500 руб. Получается не очень выгодно.

Описанный выше подход позволяет достаточно быстро оценить информацию по рынку и сделать прогнозы по контексту.

В Google тоже есть поставщик рекламы, соответственно, можно также быстро оценить данные.

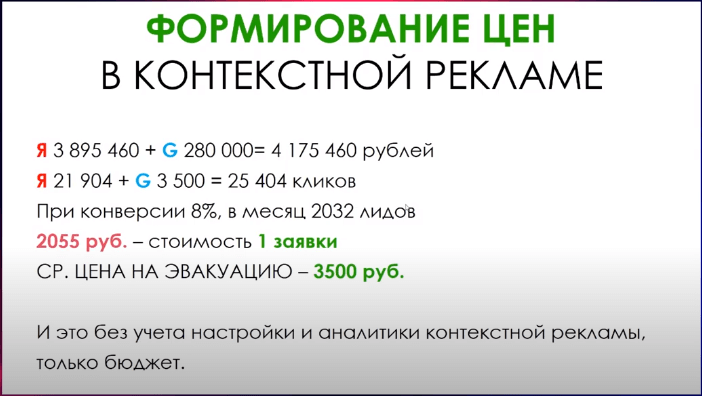

Средняя стоимость заявки составляет 2000 рублей. При этом нужно учитывать траты на настройку аналитики контекстной рекламы, а также постоянный рост стоимости контекста.

Получается, на первых порах, например для эвакуации, гораздо выгоднее использовать контекст. За 15 минут можно посчитать стоимость, имея готовую семантику.

В чем плюс SEO

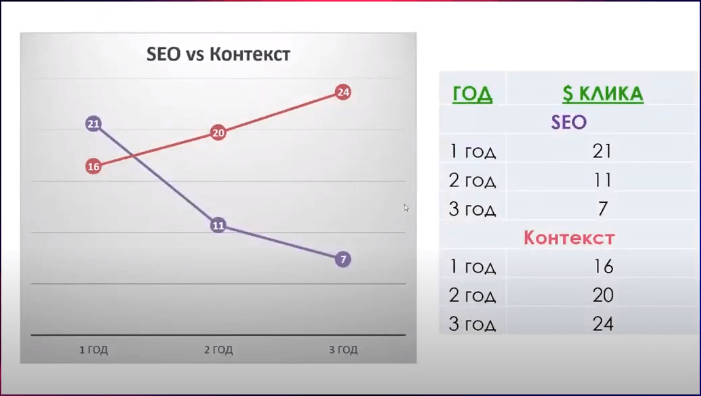

Если посчитать, как будет распределяться цена клика и стоимость одного лида, то в перспективе (если рассматривать SEO как инвестицию) она будет снижаться.

О важности структуры сайта

Рассмотрим структуру сайта на примере. Возьмем ресурс по эвакуаторам из Орла, который замыкает на себе часть основных запросов. Семантика неполная.

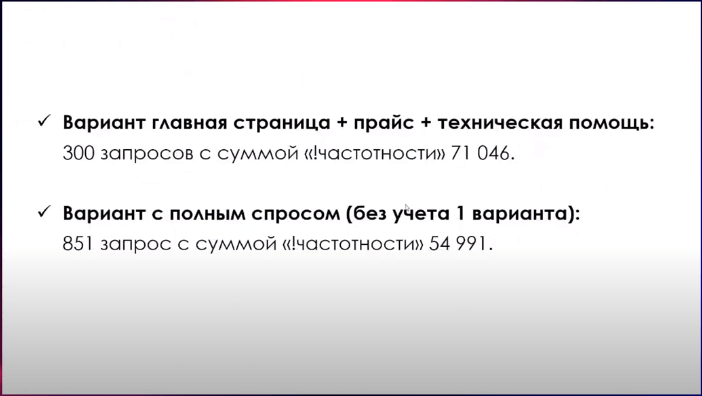

В сумме ничего плохого не происходит. Если человек пытается ранжировать сайт по 300 запросам с суммой частотности 71046, то все ок. Но в варианте с полным спросом по количеству 850 запросов (в 2,5 раза больше), сумма частотности гораздо меньше – 54 991. С точки зрения владельца бизнеса непонятная ситуация: зачем под меньший спрос делать больше страниц и вкладывать в это деньги.

В чем проблема? Если мы берем тему полноты семантики, то прослеживается четкая корреляция – сайты, которые внедряют по максимальному количеству запросов в топ-50, получают максимум запросов в топ-10.

Есть сайт, у которого объем семантики в 3 раза меньше, чем у первых двух, но объем запросов в топе всего 159. Если смотреть на все сайты, то мы увидим корреляцию в отношении семантики, структуры сайта к получаемому трафику.

Чем больше структура и семантика сайта на входе, тем выше корреляция.

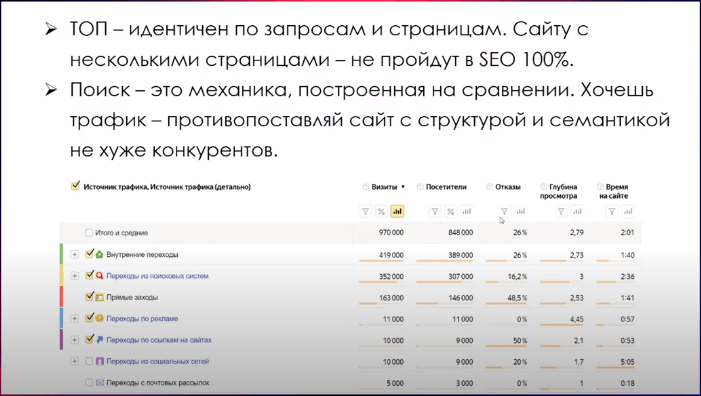

Важно понимать, что поиск – это механика, построенная на сравнении (структура, текстовый анализ, вопросы ссылочного продвижения). SEO является основным источником трафика для больших порталов.

Контекст

С контекстом все прекрасно. В нише предметной съемки за 2400 переходов бизнесу нужно будет платить 105 000 рублей. Это узкая область, которая в основном занимается съемкой для магазинов.

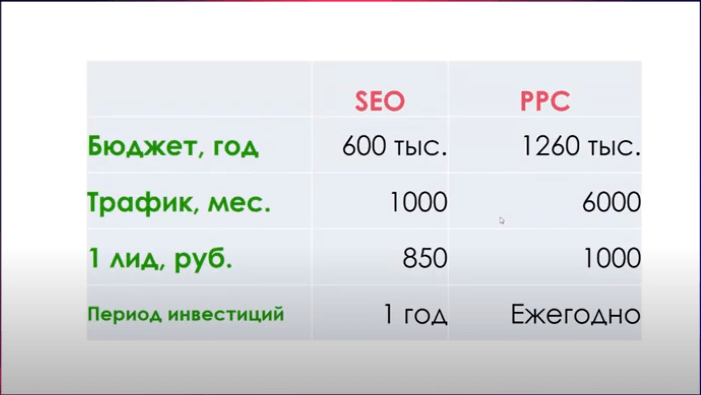

Если брать расчет по SEO и контексту, в рамках расчета на год стоимость лида и стоимость трафика получаются дешевле из SEO.

SEO получается выгоднее даже при меньшем количестве трафика.

Контекстная реклама будет выигрывать с точки зрения заявок, но будет постоянно расти в стоимости.

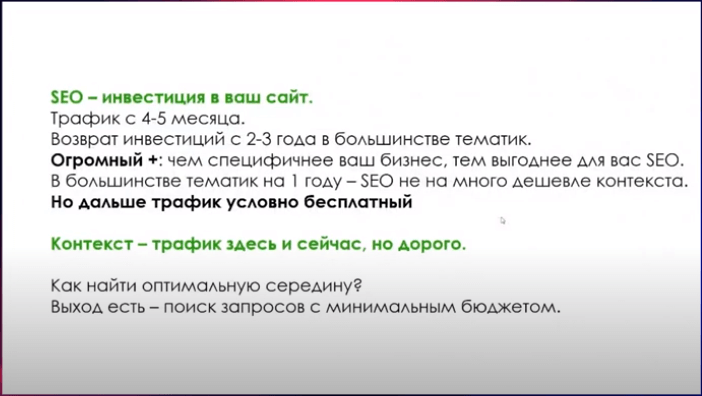

Начиная с нуля, с семантики, структуры, написания контента, проектирования сайта, вы получите трафик на 4–5 месяце. Возврат инвестиций можно ожидать 2–3 года. Чем специфичнее бизнес, тем меньше на выдаче агрегаций и больше бонусов по SEO.

В контексте вы получите трафик достаточно быстро, но нужно помнить о конверсии. Любой пользователь, перешедший на сайт, будет дальше вас сравнивать с конкурентами.

Пример того, как семантика влияет на стоимость продвижения

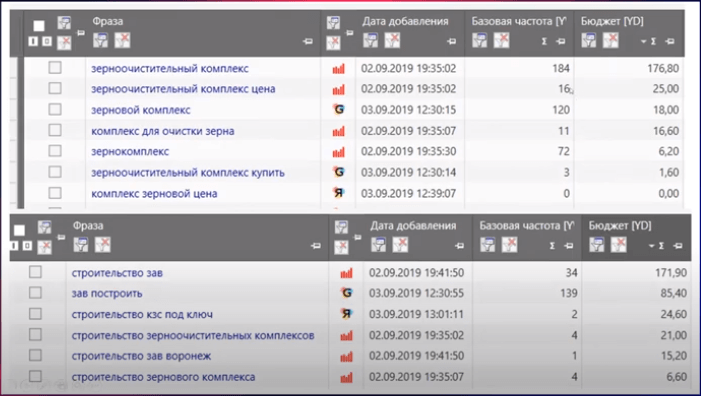

Оцениваем общий спрос и смотрим на бюджеты. Если человек берет запрос «зернохранилище цена» и пытается продвигаться по этому запросу в Яндекс.Директе, он за спрос в 11 человек по базовой частотности заплатит 224 рублей.

Можно поработать с синонимами и получить запросы, которые по сумме бюджета и трафика выигрывают. Ниже пример того, что можно получить, используя только один запрос в контекстной рекламе.

Определение приоритетной поисковой системы

Есть обучающее видео, в котором объясняется, почему важно скорить запросы.

Если вы подходите к вопросу продвижения с умом, смотрите на запросы с учетом конкурентов, то можете понимать, как изменяется поисковая выдача. Исходя из этого, можно выбрать приоритетную поисковую систему и приоритетные кластеры для ранжирования.

Важно учитывать: если в Яндексе, например, у вас 50% агрегаторов и маркетплейсов, то вы ничего не заберете по трафику. В таком случае лучше отдать предпочтение Google даже несмотря на то, что там начинающим специалистам продвигаться сложнее.

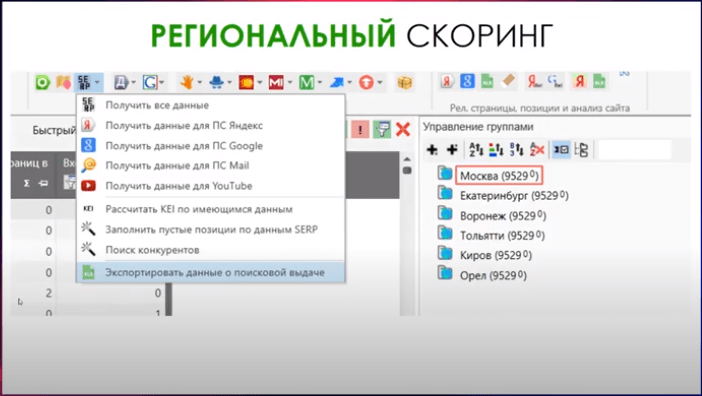

Региональный скоринг

Например, есть семантическое ядро на 9500 запросов. Берем 6 регионов и снимаем по ним данные поисковых систем.

После этого экспортируем данные: включаем режим «Мультигрупп» в Key Collector, фильтруем данные по группе «Источник». Получаем данные исключительно с привязкой к Москве, выгружаем их в Excel, используя данные по топ-10.

Повторяем процесс по каждому городу. Итого: по каждому городу есть данные выдачи.

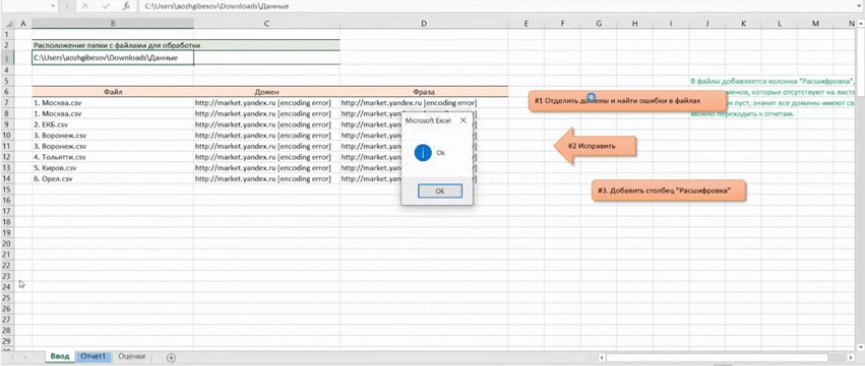

Скачиваем макрос. Выбираем в нем расположение папки, в которой сохранили эти данные, нажимаем «Отделить домены и найти ошибки в файлах», чтобы сразу исправить ошибки, если они были в процессе парсинга.

По этим запросам в файлах не собрались данные о поисковой выдаче. Убираем encoding error с помощью замены и нажимаем кнопку «Исправить». Нажимаем «Добавить столбец Расшифровка». По каждому файлу получаются данные по расшифровке. Видим, для какой выдачи какой домен был использован.

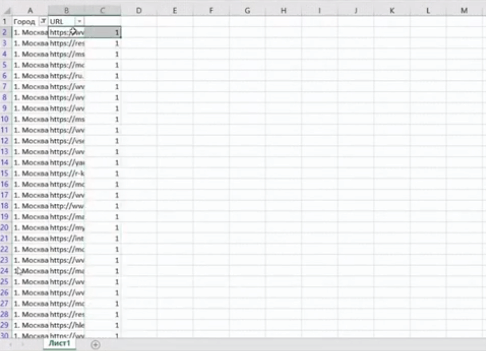

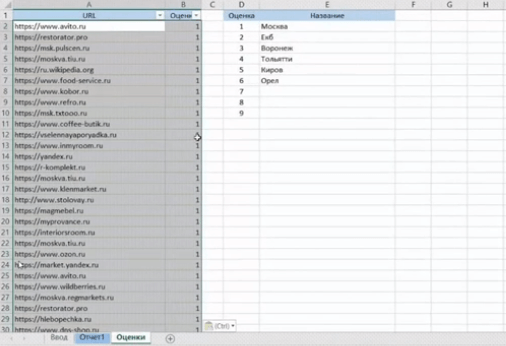

Дальше открываем новый файл Excel, вставляем туда скопированные данные и делаем фильтр только по Москве. Получаем данные URL-ов, которые ранжируются по московской выдаче. Проставляем оценку (в данном случае Москва – это 1), и копируем все эти значения.

После этого возвращаемся в файл макроса, переходим на лист оценки и вставляем данные.

Далее опять нажимаем «Добавить расшифровку» и повторяем процесс для всех файлов.

После того как полностью распознали все данные для всех городов, получится пустой лист без доменов.

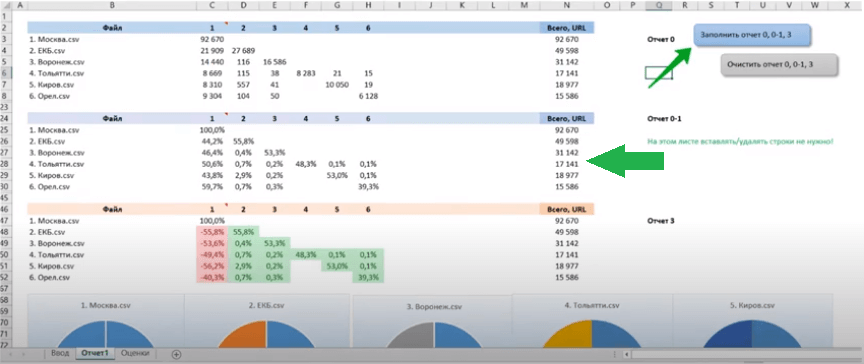

Нажимаем «Заполнить отчет» и видим статистику. Интересно количество URL-ов по выдаче. Количество запросов было одинаковое, но количество URL-ов, которое ранжируется, абсолютно разное, так как региональная выдача сильно отличается объемом, сайтов там гораздо меньше.

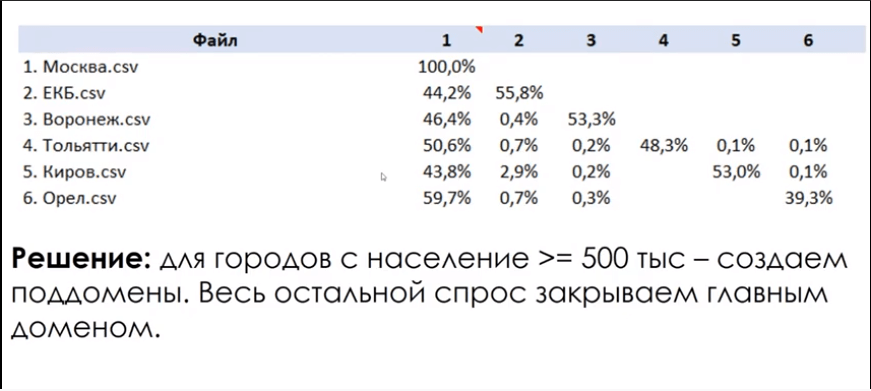

Начинаем считать данные. По Москве, естественно, 100%. Если посмотреть Екатеринбург (столбец 2), выдача там состоит из 55,8% региональных сайтов и 44,2% московских. Регионы идут по уменьшению населения.

Дальше нужно посмотреть сделанные вами оценки. В результате получится решение, которое используют ваши конкуренты на продвижение в выдаче. В основном это поддомены. По этим данным можно сделать вывод, что для городов с населением свыше 500 тысяч человек нужно создавать поддомены, весь остальной спрос можно закрывать главным доменом.

Этот метод позволяет сэкономить большое количество денег на администрировании и уникализации.

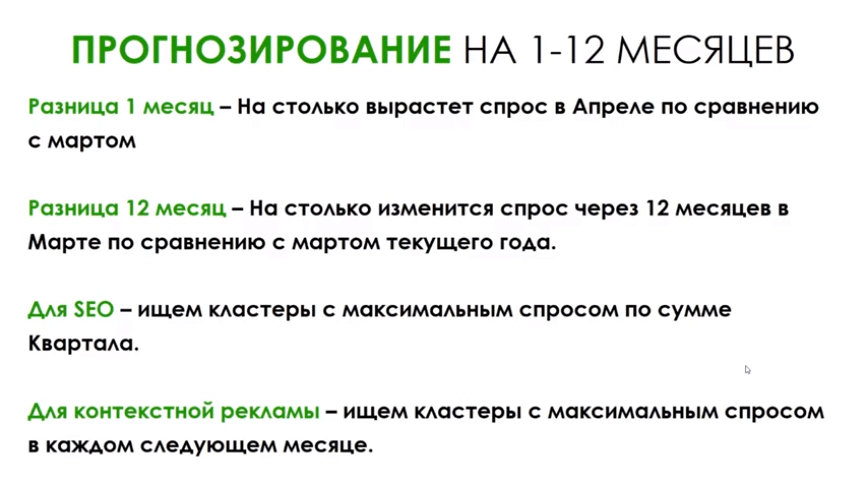

Прогнозирование на 1–12 месяцев

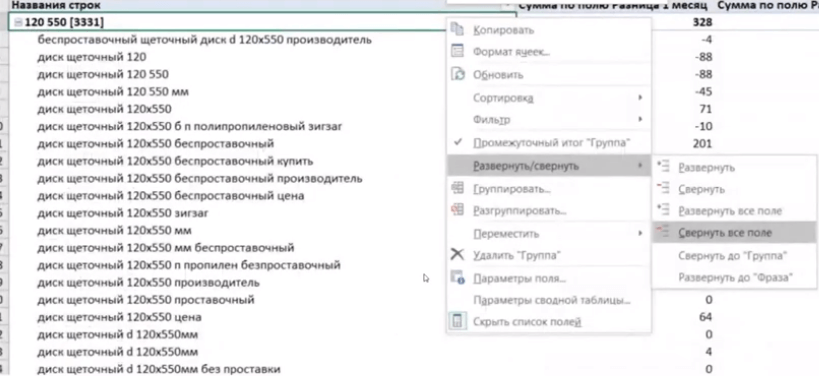

Если есть данные на 1–12 месяцев по трафику, можно понять, какие запросы нужно продвигать. Строим сводную таблицу по данным: Фраза, Группа, Разница с текущим месяцем.

На выходе будет текущее значение, сумма по разнице на 1 месяц и сумма по полю на 12 месяцев. Например, если сегодня сентябрь, то сразу видим, что в следующем месяце группа «Фронтальные погрузчики» получит разницу по трафику в 42 тысячи, то есть спрос растет. Такие данные позволяют искать максимальный спрос.

Общие данные частотностей Вордстата по сезонности позволяют прогнозировать хоть на 20 месяцев вперед. Можно это использовать.

Таблицу можно скачать и получать прогноз по трафику на 1–12 месяцев, вставляя данные сезонности.

Читайте также: «SEO без воды 2: арбитраж лидов 2020».

Теги:

Теги: