В конце октября прошла 18-я конференция по поисковому маркетингу Optimization 2019. SEOnews с радостью делится обзорами с этого мероприятия. В рамках секции «Современные исследования в SEO» выступил Юрий Хаит (Bitkey Digital Agency) с докладом «Ошибки текстовых анализаторов».

При массовой работе с посадочными страницами специалисты понимают, если стоит задача проработать 30-50 страниц на одном сайте, это не получится сделать целиком вручную (т.к. бюджет ограничен). Это нужно автоматизировать.

Многие SEO-специалисты обращаются к текстовым анализаторам, которые дают данные по вхождениям разных ключей на страницах сайтов-конкурентов. Но использование таких анализаторов в итоге может привести к не самым приятным результатам.

Как работают анализаторы

Что у нас есть:

- Кластер запросов, который кластеризован по харду с точностью 3. Это значит, что, как минимум, три документа в выдаче (в данном случае Яндекса) одновременно находятся в ТОПе по всем этим запросам.

- Кластер находится целиком в ТОПе.

- Он достаточно низкочастотный, чтобы на него могли сильно повлиять поведенческие и ссылочные факторы.

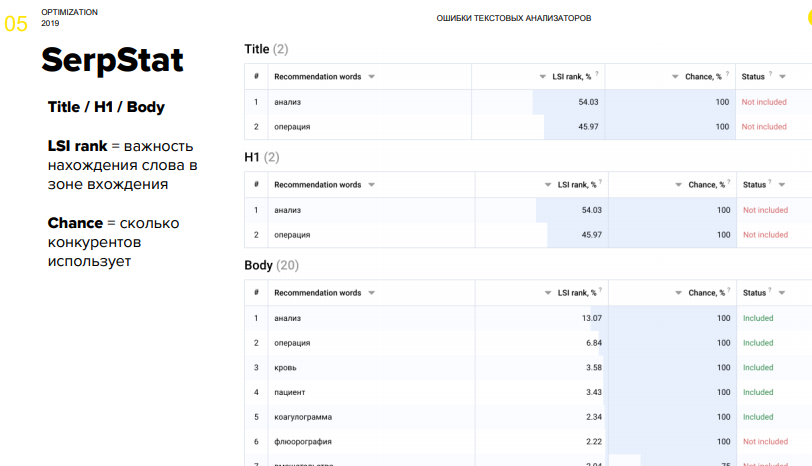

Первый текстовый анализатор, который рассмотрел Юрий – это простой текстовый анализатор, который есть в сервисе SerpStat. Стоит отметить, что им нельзя воспользоваться, если в самом SerpStat не сделать кластеризацию (но ее качество невысокое), и в итоге приходится собирать кластеры вручную.

SerpStat

Итак, SerpStat дает рекомендации исходя из определенных параметров, учитываются зоны вхождения ключа Title, H1, тело документа, внутри которого разбивки уже нет (что справедливо только при оптимизации под Google).

Плюс сервиса в том, что для одной страницы можно отправить хоть тысячу запросов.

Минусы: он анализирует неизвестные сайты (непонятно, он берет ТОП-10 или ТОП-20, какие документы он отсекает при анализе), дает рекомендации по изменению для запросов, которые в большинстве случаев уже находятся в ТОП-1.

Just Magic

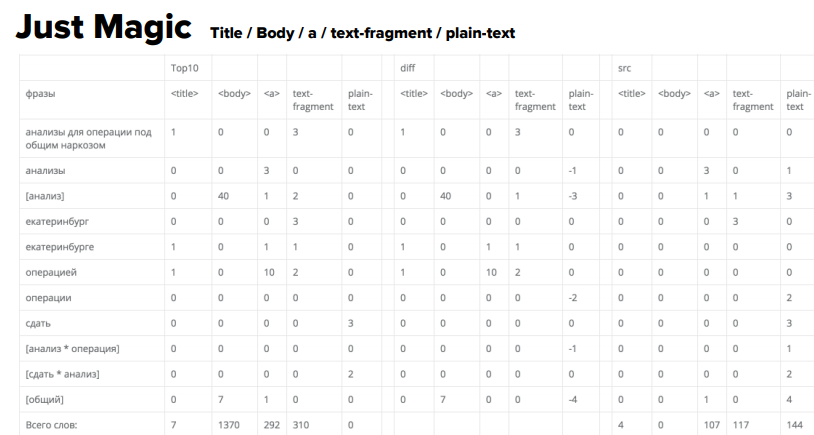

Следующий сервис Just Magic:

- дает больше всего данных по длинным запросам (более 2х слов);

- позволяет анализировать, в том числе, разбавленные вхождения;

- анализирует большее количество вхождения зон ключа. Здесь уже, по крайней мере, появились анкоры исходящих ссылок, но почему-то исчез H1. Зато появилась разбивка на текстовые фрагменты и plain-текст;

- можно на входе фильтровать те документы, по которым проводить анализ.

И вот появляется рекомендация добавить слово «анализ» 40 раз и «операция» 10 раз. Самое интересное, поскольку ранее вручную уже проанализировали те документы, которые находятся в ТОПе, известно, что нигде такого количества вхождений нет. И числа эти 40 и 10 не являются ни средними значениями, ни медианами. Откуда они взяты, непонятно.

RushAnalytics

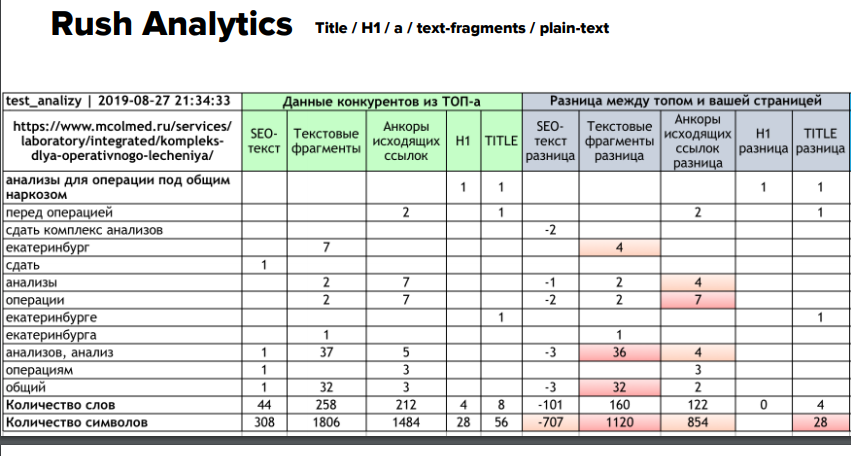

Следующий сервис – RushAnalytics. Кластер тот же самый. Слова уже другие, здесь нет разбавленных вхождений как таковых. Но опять появляется рекомендации, похожие на предыдущий сервис – добавить «анализы» в разных словоформах 36 раз.

Интересно, что тут специально сравнивали с Just Magic: отдают выдачу эти два сервиса одну и ту же, зафильтрованы одни и те же домены, но рекомендации разные.

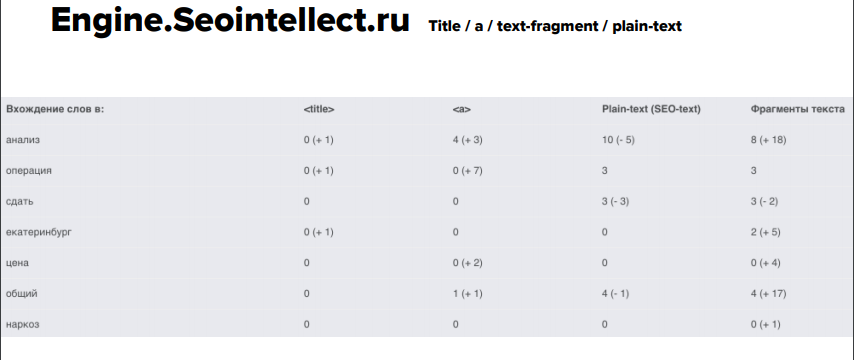

Engine.Seointellect

Еще одним анализатором – Engine.Seointellect – на практике особо не смогли воспользоваться, т.к. он дает разобщенные данные, не в том виде как предыдущие сервисы. Поэтому в дальнейшем в анализе его будет не очень много.

Сводная таблица по тому, какие зоны вхождения ключевых слов используют эти анализаторы:

Самое интересное, что все эти зоны вхождения актуальны, просто для разных типов страниц.

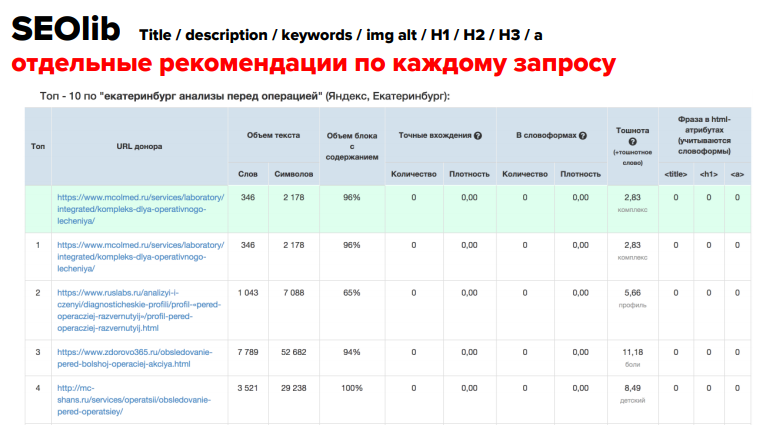

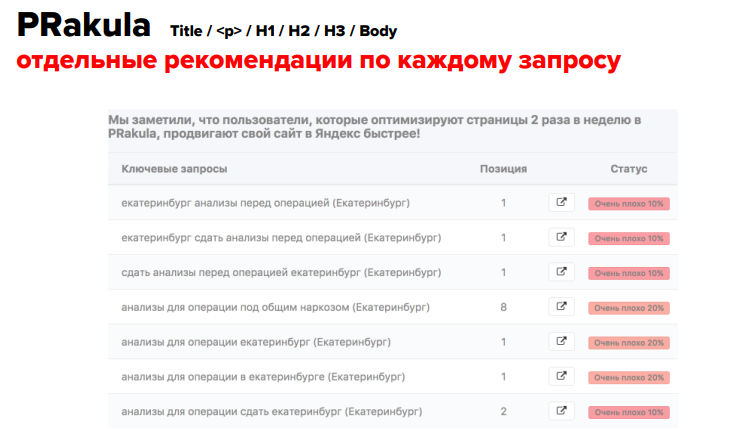

SeoLib и PRakula

В рамках исследования рассмотрели еще два сервиса – SeoLib и PRakula.

Минус SeoLib – он дает рекомендации отдельно по каждому запросу. Т.е. мы берем ТОП выдачи по одному запросу, смотрим и делаем выводы для этого конкретного запроса. Это очень неудобно, использовать на практике можно, только если у нас есть кластеры из одного запроса, т.е. просто запрос на страницу и все. Также у SeoLib не очень удобная настройка фильтрации конкурентов: можно выбрать ТОП-10 и 20 либо подать список вручную. Получается, нельзя взять ТОП и выбрать сайты, по которым мы провели кластеризацию и которые имеют тот же тип документа.

Но зато этот сервис анализирует огромное количество зон вхождения ключа: можно померить не только заголовок H1, H2, H3 и т.д., но и alt картинок.

Еще один сервис – PRakula. Позволяет оптимизировать одну страницу только под один ключ и выдает в итоге некорректные данные.

Эксперимент

Что решили сделать, увидев на примере кластера, что анализаторы дают не совсем корректные значения:

- взяли 1243 страниц-кластеров в ТОПе и 1757 страниц, которые не попали в ТОП после проработки с помощью текстовых анализаторов (всего 86 455 запросов);

- замерили расхождения автоматического анализа и «ручного парсинга» и сделали выводы;

- исключили влияние ссылочных и поведенческих факторов.

И посмотрели насколько ошибаются анализаторы на этих конкретных кластерах.

Полученные результаты:

1. Некорректно определена зона вхождения ключа: проблемы начинаются в текстовых фрагментах, в анкорах исходящих ссылок, в alt изображений. SerpStat смешивает это все в единую зону, плюс неизвестно, с какими сайтами он сравнивает, поэтому у него стоит знак вопроса.

2. Рандомные документы при парсинге: если на сайте конкурента стоит защита от парсинга, анализатор будет искать случайные сайты для анализа. В итоге получаются некорректные данные.

3. Сколько было получено неверных рекомендаций и сколько рекомендаций не привели к результату: как видим, практически у всех сервисов более 50% случаев некорректных рекомендаций, а процент страниц, которые после внедрения рекомендаций, позиции не поменяли, также впечатляющий – до 30-40%.

Что делать?

Как добиваться результатов несмотря на ошибки анализаторов:

- Есть множество сервисов и программ, которые позволяют парсить, к этому прибавляем Excel и ручной анализ.

- Необходимо сравнение по типу документа помимо кластеризации по топам (листинги с листингами, статьи со статьями, товары с товарами).

- Анализировать важность «текстовых» до проведения анализа. Для Google вообще как будто нет разницы между text-fragments / a / plaintext.

В сухом остатке:

- Зоны вхождения ключей неизменны: TITLE, H1, Plain Text + Text Fragments + BODY (если речь идет о листингах).

- Текстовые анализаторы можно использовать, но для каждого нужно делать «прогоны» документов конкурентов – все 100% должны быть спаршены. Плюс необходим выбор типа документа для сравнения.

- Очень много конкурентов с плохими текстовыми в ТОПе. Важно отсекать домены с огромным количеством входящих ссылок на URL, а не агрегаторы (если у вас, например, магазин).

- Текстовый анализ – это долго (по 3-4 часа на страницу). Имеет смысл для «жирных» по семантике листингов. (SUM “WS” > 500).

Презентацию доклада Юрия Хаита вы найдете по ссылке.

Интересное с Optimization 2019:

1. Optimization 2019: Как создать контент-стратегию для SEO и пиара за 9 шагов

2. Optimization 2019: Пять трендов поискового маркетинга от Сайруса Шепарда

3. Optimization 2019: Современные проблемы SEO-специалистов

4. SEO-тренды: как пробиться в ТОП в 2020 году

5. Исследование факторов ранжирования в Яндексе и Google в 2019 году

Теги:

Теги: