30 октября состоялась ежегодная конференция по поисковому маркетингу Optimization 2019.

В рамках секции о текстовых факторах выступил Алексей Чекушин, основатель Just-Magic.org. Он рассказал о «Технологии текстового контента»: как поиск ранжирует тексты и умеет ли понимать смысл, как работают «Палех», «Королев» и BERT и что делать с новыми технологиями.

Поисковые системы заявляют: «Пишите тексты для людей и не делайте SEO-тексты». По словам Алексея, если бы мы жили в вакуумном мире, где развита обработка естественного языка (Natural Language Processing, NLP), такое заявление было бы на 100% верно. Потому что обработка естественного языка не требует дополнительных технических навыков, просто пишите хороший текст. Но до такого уровня поиск еще не дошел лет на 5–10 точно и плавно к этому движется. Если раньше важны были только ключевые вхождения (keywords), то сейчас поиск находится на середине пути к пониманию естественного языка, а значит, без технической оптимизации текстов обойтись пока невозможно.

Как поиск оценивает тексты:

- Факторы ранжирования

- Текстовые факторы (classic);

- New-gen текстовые факторы;

- Поведенческие факторы.

- Антиспам

С какими величинами работает поиск? Факторы «классические»

Мешок слов – процесс, когда все слова из текста просто вытряхнули, перемешали и пересчитали. На этом этапе уничтожается вся информация о связности текста. При этом 97% слов просто выбрасываются, потому что не могут рассматриваться.

Биграммы – пары слов. Они сообщают, какие слова идут друг за другом.

При этом теряется информация о расположении слов и о словах, не содержащихся в запросе. Синонимы есть, но это очень маленькое расширение, которое, по словам докладчика, слабо работает. Даже примитивные синонимы, как, например, «мобильные телефоны» и «сотовые телефоны», могут оказаться не взаимными. Синоним с точки зрения поиска – это вектор, и он может быть не двунаправленным, даже если для нас – это очевидные синонимы.

Какие сложности при работе с ними?

- Машинное обучение. Если раньше был простой алгоритм – «спамить побольше», то с появлением машинного обучения стало необходимо влезать в диапазоны по ключевым словам. Эти диапазоны непонятны, и оптимизация сводится к чисто техническому угадыванию.

- Попытки технического угадывания натыкаются на большое разнообразие результатов в выдаче.

- Влияние других факторов, большинство их которых отсечь невозможно.

- Другие текстовые (текст не ограничивается вхождениями).

Что с этим делать

Используем текстовые анализаторы, которые показывают данные по вхождениям разных ключей на страницах сайтов-конкурентов.

Что поменялось с появлением новых алгоритмов? Стал отличаться принцип работы:

- Оптимизаторам стало менее важно точно затачивать страницы по ключевым вхождениям.

- Стал важен отбор запросов для анализа группы. «Палех» и «Королев» изменили правило ранжирования группировок.

- Теперь оптимизироваться может НЕ текст.

Новое поколение текстовых факторов

- DSSM – «Палех»/«Королев»;

- BERT.

Насколько два алгоритма близки к NLP (Natural Language Processing)?

Что такое Палех/Королев

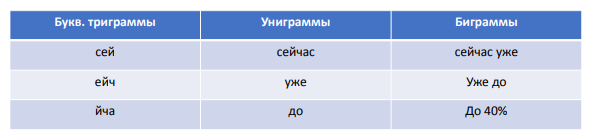

DSSM – deep structured semantic model. И «Палех», и «Королев» – это один алгоритм, который работает с разными зонами. Чем он оперирует:

- буквенными триграммами,

- словами,

- парами слов.

Вроде бы то же самое? Но есть принципиальная разница:

- В оценку идут все слова, а не только содержащиеся в запросе. Если раньше при сборе «мешка слов» 97% слов выбрасывали, то теперь оценивается все. Несмотря на то, что все еще теряется информация о том, как структурирован текст, все равно используется значительно больше данных.

- Модель специально натренирована на нахождение вхождения НЕ слов и биграмм одного запроса.

- Анализируется «важный» контент страницы («Королев»). А какая часть страницы и контента является важной – известно только нейросетям Яндекса.

Поиск продвинулся на 1 шаг: теперь не теряется информация о словах, не содержащихся в запросе. Но это еще не Natural Language Processing (NLP).

Как это выглядит. Сейчас уже до 40% всех запросов уникальны, то есть не повторяются хотя бы дважды в течение всего периода наблюдений. Пример входных данных:

В анализ идут буквенные триграммы (часть слова), униграммы (1 слово), биграммы (2 слова, идущих подряд).

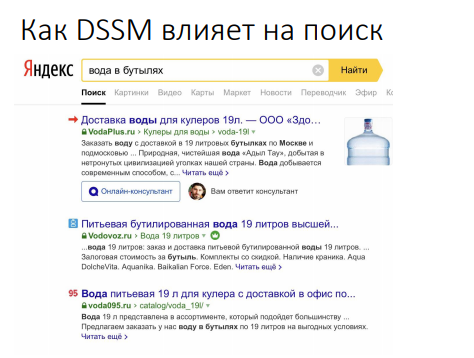

Как это выглядит в поиске. Например, вводим не очень частотный запрос, открывается картина, которую SEO-специалисты в высококонкурентных тематиках видеть не привыкли:

В запросе содержится слово «бутыль», а в выдаче «бутилированный» и «бутылка» – это не совсем синонимы. Но имеются повторяющиеся паттерны в title, которые можно выделять визуально или автоматически и использовать.

По словам Алексея, были случаи, когда добавление всего одного слова в title, не содержащегося в запросе и не являющегося синонимом, позволяло (на «Палехе») вытаскивать запросы из ТОП 15 в ТОП 3. Алгоритм анонсировали давно, но работать он начал только зимой 2018–2019 года.

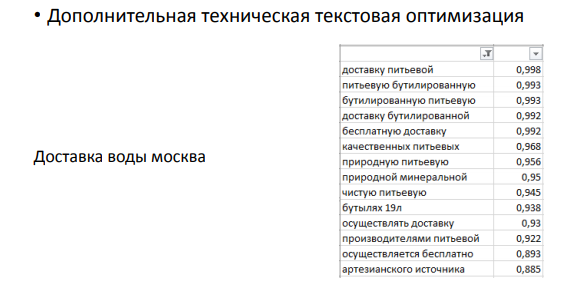

Как с этим работать. Используем методику автоматического выделения. Берем выдачу «доставка воды москва» и выделяем определенные текстовые паттерны, используя алгоритмы, которые определяют тематическую близость. Получаем биграммы, которые в запросе вообще не содержатся.

Практика показывает, что добавление в title, тексты и другой контент страницы слов, не содержащихся в запросе, но релевантных тематике, положительно сказывается на ранжировании.

Как «Палех»/«Королев» влияют на оптимизацию

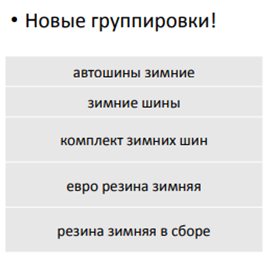

Поменялись группировки. Кто продвигает под Яндекс, знает, что группировки слов – это самое важное при работе с контентом. Если ошибся на этапе группировки, то остальное можно не оптимизировать. Поменять что-либо практически невозможно.

- Стало меньше одинаковых слов в запросах одного кластера. Раньше такого разброса в конкурентных(!) тематиках не было.

- Больше кластеры, больше НЧ на странице.

- Гораздо сложнее стало деоптимизировать страницу. Если запрос повело не туда, раньше нужно было просто убрать ключевики. А теперь, поскольку поиск оперирует словами, которые не связаны с ключевиком, деоптимизировать стало вообще сложно, проще смириться с этим.

Это важный момент, который поменял регламент по оптимизации.

Что такое BERT

Это следующий шаг по сравнению с «Палехом»/«Королевом». Алгоритм BERT от Google был анонсирован в 2018 году, запущен в октябре 2019. Пока охватывает только английский язык и 10% запросов.

- BERT – Bidirectional Encoder Representations from Transformers Bidirectional – алгоритм «читает» текст как слева-направо, так и справа-налево.

- Пытается «угадать» слово по контексту.

- Имеет большое число применений (Q/A, проверка гипотез). Если «Палех»/«Королев» – это просто соответствие запроса документу, то BERT может из куска текста, где содержится ответ, выделить сам ответ. Или может проверить гипотезу и т.д.

Помимо самого токена (вхождения), BERT использует сегмент (предложение) и абсолютную позицию, которая выходит за рамки сегмента.

Этот алгоритм уже полностью использует всю информацию, которая есть в тексте. Учитывает не только все слова, не содержащиеся в запросе, но и позволяет не терять информацию о расположении слов.

Тем не менее для решения задачи Q/A ему надо заранее дать ответ на этот вопрос в тексте. Сам его составить он пока не может.

Это еще не Natural Language Processing (понимание текста). Как повлияет BERT на поиск и как под него оптимизировать? «Пока неизвестно», – заключил Алексей.

Презентацию доклада Алексея Чекушина вы найдете по ссылке

Интересное с Optimization 2019:

1. Ошибки текстовых анализаторов

2. Как создать контент-стратегию для SEO и пиара за 9 шагов

3. Пять трендов поискового маркетинга от Сайруса Шепарда

4. Современные проблемы SEO-специалистов

5. SEO-тренды: как пробиться в ТОП в 2020 году

6. Исследование факторов ранжирования в Яндексе и Google в 2019 году

Теги:

Теги: