Диагностика проблем с сайтом. Проверкa индексации сaйтa и других его составляющих на наличие проблем

1. Вступление

На многих SEO-форумах большой популярностью пользуются вопросы из серии «А что случилось с моим сайтом?», «Почему у меня выпали страницы?», «Что случилось с позициями?». Ответить на вопросы иногда бывает легко, иногда сложно; бывает, что ситуация, описываемая пользователем,типична и легко диагностируется, иногда, наоборот, симптомы не вписываются в обычные рамки процесса продвижения.

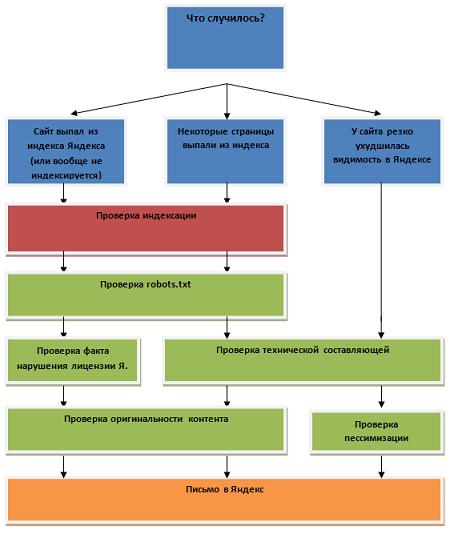

Мы представим в данном мастер-классе алгоритм диагностики, который поможет выявить основные проблемы с сайтами. Сразу оговорюсь- мы будем рассматривать именно внештатные ситуации, когда выпадают страницы из индекса поисковой системы, или даже весь сайт, а не те случаи, когда проседают некоторые запросы — последнее относится больше к задаче по анализу апдейта, а про это был отдельный мастер-класс

Определение ситуации

Чем расписывать все по пунктам, классифицировать, лучше представим все наглядно.Ниже изображен алгоритм, который поможет вам грамотно провести диагностику сайта. На рисунке четко определена последовательность действий, которые в большинстве ситуаций помогут дать ответ на вопрос "Что случилось сайтом?«.После рисунка идет подробное описание процедур проверки различных факторов, а также даны рекомендации, как действовать, когда были обнаружены различные ошибки.

2. Проверка индексации сайта

В первую очередь, нам нужно четко удостовериться в том, что страница или даже весь сайт выпали из индекса. Можно это сделать несколькими способами, благо, язык запросов Яндекса достаточно богат такими операторами.

Самый простой способ проверки — использовать «расширенный поиск». В поле «находятся на сайте» вводим адрес искомого сайта. Можно вводить с www, можно без www — разницы нет.

![]()

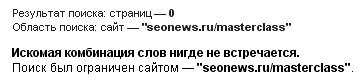

Если нас интересует конкретная страница, то тогда могут возникнуть определенные сложности при проверке — например, мы хотим проверить, проиндексирована ли страница m.seonews.ru/masterclasses/, т.е. разводящая страница. Мы получаем в результатах поиска 551 страницу — не будем же мы просматривать все позиции, чтобы обнаружить там искомую страницу.Как вариант — в этом случае мы можем задать запрос, заключив урл страницы в кавычки и убрав слеш, т.е. «m.seonews.ru/masterclass». В этом случае уже нужно проводить проверку как с www, так и без www, т.к. мы ищем по точному вхождению. Вот что у нас получилось бы, если бы мы ошиблись -

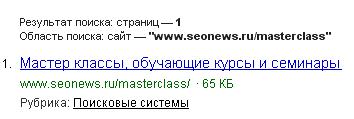

А вот так будет правильнее —

Аналогичного эффекта мы добьемся, если воспользуемся запросом url="m.seonews.ru/masterclass".В этом случае будет найдена только одна страница. Если добавить в конец *, т.е. url="m.seonews.ru/masterclass*«,то будут найдены все страницы, адрес которых содержит

3. Проверка robots.txt

Проверка robots.txt (проверка индексации сайта) — обязательная процедура в ходе диагностики проблем с сайтом. И это действительно очень важный пункт.

В ходе проверки ошибок нам нужно как раз убедиться, а не запрещены ли к индексации выпавшие в ходе последнего апдейта страницы? Или, может, даже весь сайт закрыт от поисковых систем? Как бы ни казалось это банальным — проверка robots.txt — но это нужно сделать, ведь всякое может случиться: вдруг клиент что-нибудь напортачил, или другой сотрудник вашей фирмы делал, например, доработки, закрыл от индексации некоторые страницы, а открыть потом забыл. Поэтому очень тщательно проверяем правильность составления robots.txt. При проверке полезно воспользоваться , вводя в поле «Имя сервера:» адрес конкретной проверяемой страницы.

Кстати, стоит тут вспомнить один случай из жизни. В robots.txt была запрещена для индексации страница www.site.ru/catalog/index.wbp. При этом страница была в индексе и успешно продвигалась. Теоретически, так и должно было быть, т.к. в robots.txt запрещалась другая страница, которая в индекс поисковика и не попадала. Но вот где-то с Нового года со страницей начали происходить непонятные вещи — она то появлялась в индексе, то пропадала из него. Причины такой чехарды так и не были найдены. Возможно, все же был виноват robots.txt — не стоило действовать так тонко, запрещая страницу index.wbp и продвигая при этом разводящую. Яндекс все-таки большая и сложная система со множеством заморочек, так что не стоит ходить по краю, лучше действовать проще и надежнее. Кстати, проверка показала, что robots.txt составлен верно.

И еще обратите внимание, что максимальный размер robots.txt , который может прочитать робот Яндекса — 32Kb.

4. Проверка факта нарушения лицензии Яндекса

Для начала — сразу ссылка на «Лицензию на использование поисковой системы Яндекса (Yandex.ru)» -. Нас интересует пункт 3.5 «Поисковый спам», где озвучен основной тезис, который использует Яндекс при оценке сайта на «спамность». К сожалению, в лицензии не расписаны различные случаи, когда Яндекс может наказать сайт. Такие примеры накапливаются с опытом или узнаются на форумах от коллег-оптимизаторов.

Есть ряд случаев, когда сайт в результате нарушения лицензии может быть исключен из индекса поисковой системы (мы рассматриваем здесь только «нормальные» сайты, не дорвеи и не сетки промо сайтов):

- Автоматическая генерация страниц.Если страницы вашего сайта создаются автоматически (например, у вас автоматически пополняемый каталог статей), то это повод для Яндекса забанить ваш сайт. Конечно, вероятность не 100%, но она все равно есть. Всегда оценивайте здраво — «а действительно ли полезен мой сайт пользователю?».

- Расположение на забаненном хостинге.Обычно большие сайты лежат на отдельном выделенном сервере. Но если сайт маленький,его могли вполне разместить на одном хостинге вместе с сайтами сомнительносодержания. В этом случае, нормальный сайт может пострадать.

- Бан поддоменов. У любого сайта можно создать огромное количество поддоменов (если, конечно, хостер позволяет). Эти поддомены можно использовать различным образом. Поэтому,по аналогии с предыдущим случаем — если на поддоменах расположены сайты,уличенные в нарушении лицензии Яндекса, основной сайт также пострадает.

- Немодерируемые каталоги/форумы. Если ваш сайт содержит большое количество страниц, содержащих спам, то это повод для Яндекса забанить весь сайт. Такая ситуация возможна, когда у вас на сайте есть не модерируемый каталог ссылок или форум, где каждый может оставить любое сообщение, в том числе содержащее ссылки на продвигаемый проект.

5. Проверка технической составляющей

Проверка технической составляющей должна осуществляться в любом случае: будь-то выпадение сайта или отдельных страниц.

Так уж повелось, что Яндекс очень четко реагирует на качество работы сервера, где расположен сайт. Не раз я на опыте убеждался, что в случае серьезных технических проблем сайт может потерять, причем сильно, свои позиции. Точно не могу назвать границы, когда Яндекс начинает «штрафовать» сайт за плохую работу сервера, но в качестве гипотезы можно взять следующее утверждение: «Если в течение нескольких дней сервер „лежал“, то это могло стать причиной массового ухудшения позиций сайта в Яндекса». Конечно, сайт полностью не выпадет из индекса поисковой системы — для этого нужна не одна неделя, но «просесть» может.

Рассмотрим подробнее технические ошибки, которые могут негативно отразиться сразу на многих страницах одного сайта:

- Долгое время ответа сервера. Если в результате технических неполадок на сервере невозможно получить тело документа за некоторый период времени, то это может привести к проседанию позиций в выдаче. Сам Яндекс подтверждает тот факт, что если его робот не смог скачать определенную страницу, эта страница может временно вообще пропасть из результатов поиска.

Например, в логах мы заметили:

213.180.206.248 — - [02/Feb/2008:02:18:44 +0400] «GET / HTTP/1.1» 200 24625 «-» «Yandex/1.01.001 (compatible; Win16; I)» — это значит, что сервер отработал запрос правильно. В случае если сервер «лежал», то в логах не появится такая запись. Нужно действовать по-другому.

Существуют различные сервисы, которые позволяют оценить uptime («время бесперебойной работы» сервера). Работают они по следующему принципу. Периодически (обычно несколько раз в час) сайт опрашивается по протоколу http, т.е. как бы имитируется запрос обычного пользователя. Рассчитывается время ответа сервера и фиксируется статус ответа. По собранной таким образом статистике можно делать выводы о качестве работы сервера.

Как уже было сказано, существует много сервисов, которые отслеживают uptime. Обычно можно попробовать воспользоваться услугами в демо-режиме, с ограниченным функционалом. Но этого, как правило, недостаточно. Мне довелось поработать с сервисом — в течение месяца, когда можно было пользоваться услугами без ограничений, вырисовывалась довольно-таки четкая картинка — на сервере были периодические сбои и host-tracker их фиксировал. По прошествии месяца проверка стала производиться гораздо реже — один раз в полчаса. В результате сейчас сервис считает uptime=100%, хотя на самом деле сайт периодически «лежит».

- Некорректная работа сервера (неправильные HTTP-статус — коды, неверные HTTP-заголовки, неверная кодировка). В результате такой вот некорректной работы сервера робот Яндекса просто не получает тело документа. Что уж там конкретно произошло — пусть разбираются администраторы сервера, нам лишь нужно установить сам факт наличия ошибок со стороны сервера. Проще всего это сделать, если заранее зарегистрировать сайт в е — а потом проанализировать информацию в разделе «Ошибки». Если по каким-то причинамЯндекс.Вебмастер не был установлен, то можно проанализировать логи apache: в ответ на запрос робота должен отдаваться 200 ответ сервера, могут также отдаваться ответы 301, 302, 304, но главное не 404. Если получите последний вариант, тогда нужно разбираться с проблемой тщательнее — скорее всего из-за этого сайт потерял свои позиции, а возможно, даже и часть страниц в индексе.

Например, совершенно недопустимым является следующий ответ:

213.180.206.248 — - [02/Feb/2008:03:14:44 +0400] «GET / HTTP/1.1» 404 0 «-» «Yandex/1.01.001 (compatible; Win16; I)». Это говорит о том, что сервер по каким-то причинам отдал вместо главной страницы 404 ответ.

Остальные технические ошибки не являются массовыми, а носят локальный характер, например, наличие мета-тега refresh, из-за которого Яндекс не будет индексировать страницу. Перечень таких ошибок вы найдете на этой .

6. Проверка оригинальности контента

В последнее время Яндекс придает большое значение такому показателю как оригинальность контента. Связано это, прежде всего, с тем, что все больше стало появляться сайтов, содержащих заимствованный контент с других сайтов. Такие вот «творения» не несут пользователю никакой полезной информации и в подавляющем большинстве случаев используются своими владельцами в качестве площадок для продажи ссылок и рекламы.

По теме оригинальности контента уже был написан соответствующий мастер-класс. В нем были озвучены основы теории распознавания дубликатов.

Итого:

- Если вы создали новый сайт с заимствованным контентом без большого количества входящих ссылок, ваш сайт, скорее всего, не будет проиндексирован Яндексом. Поэтому лучше всего начать с оригинального контента, подождать, когда сайт попадет в индекс, а далее уже можно наполнять его неоригинальной информацией.

- Если на сайте встречается много страниц с похожим содержанием (классический пример — обычная страница и «версия для печати»), то часть страниц может быть исключена Яндексом. При этом, до определенного периода с сайтом все может быть хорошо, но потом — раз! — и половина страниц выпадает из индекса. Также в качестве примера можно привести страницы, содержащие мало текстовой информации, например, галереи фотографий. Получается, что страницы схожи тем, что содержат одинаковые навигационные элементы, а отличаются лишь картинками. В этом случае Яндекс может склеить страницы одного сайта, т.к. если не смотреть на сам сайт, то по косвенным признакам можно подумать, что это сгенерированный автоматически сайт, который нужно исключить из поиска.

- Если на сайте неправильно настроена обработка 404 ошибки, это может стать причиной того, что в базу Яндекса попадет много страниц с дублированным контентом, часть из которых переклеится. При этом склейка будет не обязательно в пользу продвигаемой страницы. Чтобы не допустить этого, нужно правильно настроить обработку 404 ошибки. Об этом уже говорилось в мастер-классе «Подготовка сайта к продвижению: технические доработки под промо». Там же есть небольшая инструкция о том, как проверить правильность настройки 404 ошибки.

7. Проверка пессимизации и других фильтров, искусственно понижающих позиции сайта

Существует ряд фильтров, действие которых может привести к тому, что у сайта резко ухудшатся позиции по ряду запросов.

На сегодняшний день можно выделить 2 таких фильтра:

- Пессимизация— это искусственное отключение ссылочного ранжирования для сайта. Таким образом, сайт оказывается на самых нижних позициях в выдаче по запросам. Обычно пессимизацией наказывают сайты, участвующие в беспорядочном обмене ссылками, при этом нетематическими ссылками. За одни только внешние факторы, т.е. фактически входящие ссылки, сайт не может быть пессимизирован. Поэтому сейчас стали уже реже встречаться случаи пессимизации сайта, т.к. мало осталось веб-мастеров, ведущих обмен ссылками, в основном все покупают их у брокеров.

Подробнее о пессимизации можно прочитать в мастер-классе «Что такое пессимизация, что такое „бан“? Признаки, порядок действия».

- Фильтр за продажу ссылок. Относительно новый фильтр, который довольно часто используется Яндексом в последнее время. Его действие заключается в том, что страницы сайта, размещающие ссылочные блоки, могут быть искусственно понижены в выдаче поисковых систем. То есть Яндекс считает, что данные ссылки способствуют некорректному ранжированию сайтов, на которые ведут ссылки из блоков. В итоге сайт-акцептор не штрафуется — под санкции попадает сайт-донор.

Последним пунктом проверки сайта является процедура написания в . Обычно поддержка отвечает в течение 1-2 рабочих дней. Сначала вам сообщается: «Спасибо за внимание к сайту. Мы обязательно рассмотрим вашу заявку». После этого еще через несколько дней приходит ответ.

8. Заключение

Проблемы с сайтом встречаются у каждого оптимизатора, как бы он ни следил за проектом, как бы он ни страховался. Слишком многое зависит от внешних факторов — прежде всего, от самого Яндекса, и в частности, от его неоднозначной трактовки одинаковых действий оптимизаторов. Также техническое состояние сервера может создавать определенные проблемы.

Так вот, от ошибок никто не застрахован. Самое главное уметь быстро обнаруживать, диагностировать и потом исправлять их. Приведенный выше алгоритм проверки поможет вам быстро оценить ситуацию и предпринять определенные действия.

Даже если причины ошибок не были обнаружены, не стоит раньше времени паниковать — часто и у Яндекса случаются сбои. Если вы не смогли установить причину ошибок — пишите в Службу поддержки Яндекса.

P.S. Все приведенные выкладки основаны на личном опыте и теоретических сведениях о функционировании Яндекса. Все слова косвенно подтверждаются письмами от Платона Щукина, большая коллекция которых собрана на этом .

Теги:

Теги: